Nous vivons à l’ère de la révolution industrielle 4.0, où l’intelligence artificielle (IA) devient progressivement un élément indispensable dans de nombreux domaines de la vie sociale. Les médias, en tant que pont d’information entre le public et les événements, ne peuvent pas rester en dehors de cette tendance.

|

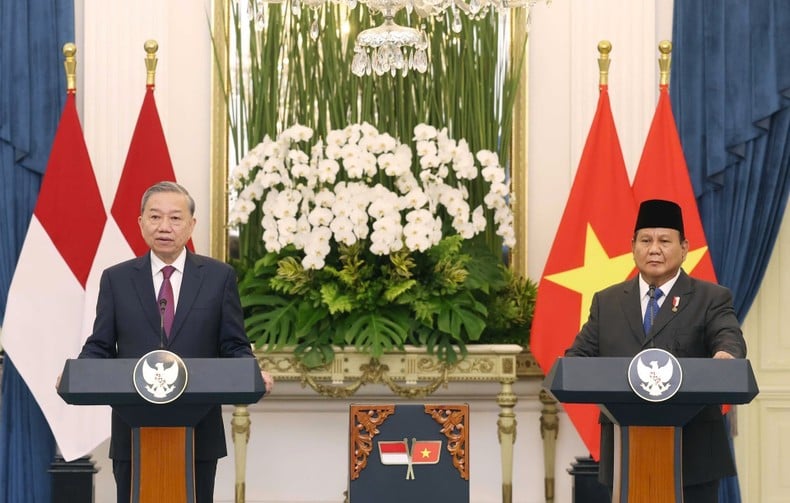

| Mme Nguyen Thi Hai Van - Directrice du Centre de formation au journalisme, Association des journalistes du Vietnam lors de l'atelier sur la technologie de l'IA. (Source : Association des journalistes du Vietnam) |

Pour tirer le meilleur parti des avantages apportés par l’IA, les communicateurs doivent se doter des connaissances nécessaires pour utiliser l’IA efficacement, tout en garantissant la fiabilité et l’éthique dans la transmission des informations.

De la « chaleur » de l’IA

Il est absolument clair que l’IA (Intelligence Artificielle) est l’un des mots-clés les plus en vogue aujourd’hui. En septembre 2024, une recherche Google pour le mot clé « IA » en 0,3 seconde a enregistré 15 milliards 900 millions de résultats ; Avec le mot-clé « outils d’IA », en 0,4 seconde, plus de 3 milliards 400 millions de résultats ont été enregistrés. Ces chiffres énormes témoignent du niveau de couverture et d’intérêt pour l’IA et les outils basés sur l’IA à l’échelle mondiale.

De nos jours, de plus en plus d’outils d’IA émergent dans divers domaines, notamment celui des médias. Outre le célèbre ChatGPT, il existe de nombreuses applications d'IA développées dans une direction spécialisée, servant à des tâches spécialisées. Il n’est pas difficile d’énumérer ici de nombreux outils, par exemple : Bing AI, Clause, Zapier Central pour les groupes de tâches Chatbot ; Jasper, Copy.ai, Anyword pour les tâches de création de contenu ; Descript, Wondershare, Runway pour les tâches de production et de montage vidéo ; DALL-E3, Midjourney, diffusion stable pour tâches d'image créatives ; Murf, AIVA pour les tâches de contenu audio, etc. et tout récemment, le géant Amazon a également introduit des outils d'IA qu'ils ont développés, Video Generator et Image generator, dans le but « d'inspirer la créativité et d'apporter plus de valeur ».

Bien que les outils d’IA varient considérablement en termes d’échelle et de niveau de spécialisation, la technologie a essentiellement deux choses en commun : les outils d’IA sont développés sur la base d’algorithmes et de données pour « former » l’outil d’IA.

Contrôle éthique de l'utilisation de l'IA dans les médias

On ne peut nier la commodité qu’apportent les outils d’IA et avec le rythme rapide des mises à jour technologiques, il y aura de plus en plus d’outils d’IA spécialisés dans tous les coins, répondant à des tâches simples ou complexes dans l’industrie des médias. Parallèlement à ce développement fulgurant, de nombreuses questions se posent concernant la question du contrôle éthique dans le développement et l’utilisation des outils d’IA dans l’industrie des médias ? Et si l’algorithme et les données de cet outil d’IA étaient manipulés d’une manière préjudiciable à la communauté ? À qui appartiennent les droits de propriété intellectuelle sur les données d’entrée que l’outil d’IA utilise pour la formation ? Qui évalue leur niveau de préjudice ?

Existe-t-il une inégalité entre le groupe de personnes qui ont accès et le groupe qui n’ont pas accès aux outils d’IA pour la même tâche ? Des questions ont même été soulevées quant au potentiel de dommages incontrôlés causés par les outils d’IA, en particulier dans des domaines sensibles qui peuvent avoir un impact sur de nombreuses personnes à grande échelle, comme les médias et les réseaux sociaux.

Reconnaissant les préoccupations ci-dessus, de nombreuses organisations, associations, gouvernements et même des entreprises et sociétés développant des outils d’IA ont publié des recommandations, des informations explicatives et des codes de conduite supérieurs liés à la question du contrôle éthique dans la technologie de l’IA. Adoptée par 193 pays en 2021, la Déclaration sur l'éthique de l'intelligence artificielle de l'UNESCO - Organisation des Nations Unies pour l'éducation, la science et la culture - stipule que « l'essor rapide de l'intelligence artificielle (IA) a créé de nombreuses opportunités à l'échelle mondiale, allant de l'aide au diagnostic des soins de santé à la possibilité de connexion humaine via les médias sociaux et à la création d'efficacité du travail grâce à l'automatisation des tâches.

« Cependant, ces changements rapides soulèvent également de profondes préoccupations éthiques. Les risques associés à l’IA ont commencé à aggraver les inégalités existantes, entraînant des préjudices supplémentaires pour des groupes déjà défavorisés… » Et à partir de là, « demander à l’UNESCO de développer des outils pour aider les États membres, notamment la méthodologie d’évaluation de l’état de préparation, un outil permettant aux gouvernements de dresser un tableau complet de leur état de préparation à déployer l’IA de manière éthique et responsable pour tous leurs citoyens.

Dans le cadre de son approche globale, l’UNESCO a lancé l’Observatoire mondial de l’éthique et de la gouvernance de l’IA, qui, selon elle, « fournit des informations sur la préparation des pays à adopter l’IA de manière éthique et responsable ». L'initiative héberge également le laboratoire d'éthique et de gouvernance de l'IA, qui rassemble des contributions, des recherches percutantes, des boîtes à outils et des pratiques actives sur un large éventail de questions d'éthique de l'IA… »

Outre les organisations mondiales comme l'UNESCO, de nombreuses associations professionnelles travaillent également à l'élaboration de leurs propres codes de conduite. Par exemple, l'IABC - International Association of Business Communications, une association comptant des milliers de membres du monde entier, a lancé les Lignes directrices pour l'utilisation éthique de l'IA par les professionnels de la communication, qui visent à guider les membres de l'IABC sur la pertinence du Code d'éthique de l'IABC pour l'IA. Ces lignes directrices peuvent être mises à jour et complétées au fil du temps à mesure que la technologie de l’IA évolue. Dans ce code de conduite, il existe de nombreux points spécifiques auxquels un professionnel de la communication doit adhérer, tels que :

« Les ressources d’IA utilisées doivent être pilotées par l’humain pour créer des expériences positives et transparentes qui inspirent le respect et renforcent la confiance dans la profession des médias. Il est important de rester informé des opportunités de carrière et des risques que présentent les outils d’IA. Il est nécessaire de communiquer l’information de manière précise, objective et équitable. Les outils d’IA peuvent souffrir de nombreux bugs, incohérences et autres problèmes techniques. Cela nécessite un jugement humain pour vérifier de manière indépendante que mon contenu généré par l’IA est exact, transparent et sans plagiat.

Protégez les informations personnelles et/ou confidentielles des autres et n’utilisez pas ces informations sans leur permission. Évaluez vos résultats d’IA en fonction de l’engagement humain et de la compréhension de la communauté que vous souhaitez servir. Éliminez les préjugés du mieux que vous pouvez et soyez sensible aux valeurs culturelles et aux croyances des autres.

Doit vérifier de manière indépendante les faits et vérifier ses propres résultats avec la rigueur professionnelle nécessaire pour garantir que les documents, informations ou références de tiers sont exacts, ont l'attribution et la vérification nécessaires et sont entièrement sous licence ou autorisés à être utilisés. N’essayez pas de cacher ou de déguiser l’utilisation de l’IA dans votre production professionnelle. Reconnaître la nature open source de l’IA et les problèmes de sécurité qui y sont associés, y compris la saisie d’informations fausses, trompeuses ou mensongères...

Les entreprises et les sociétés qui possèdent, développent et commercialisent des outils d’IA sont celles qui comprennent le mieux les tenants et aboutissants de ces outils. Elles connaissent les algorithmes sous-jacents sur lesquels fonctionnent les outils d’IA et les données à partir desquelles ils sont formés. Par conséquent, ces entreprises doivent également fournir des informations relatives aux principes éthiques dans le développement de l’IA. Il y a effectivement des entreprises qui s’intéressent à cette question.

Google s'engage à ne pas développer d'outils d'IA pour les domaines où il existe un risque important de préjudice, et ne procédera que lorsque nous estimerons que les avantages l'emportent largement sur les risques et intégrerons des contraintes de sécurité appropriées. Armes ou autres technologies dont le but principal ou le déploiement est de causer ou de faciliter directement des blessures humaines. Les technologies qui collectent ou utilisent des informations à des fins de surveillance violent les normes internationalement acceptées. Des technologies qui violent les principes largement reconnus du droit international et des droits de l’homme.

Sur le plan de la sécurité et de la sûreté, Google s'engage : « Nous continuerons à développer et à mettre en œuvre des mesures de sécurité et de sûreté robustes pour éviter les résultats imprévus qui créent des risques de préjudice. Nous concevrons nos systèmes d’IA de manière à ce qu’ils soient suffisamment prudents et chercherons à les développer conformément aux meilleures pratiques en matière de recherche sur la sécurité de l’IA. Nous intégrerons nos principes de confidentialité dans le développement et l’utilisation de nos technologies d’IA. Nous créerons des possibilités de notification et de consentement, encouragerons les architectures qui protègent la vie privée et assurerons une transparence et un contrôle appropriés sur l'utilisation des données.

Tout comme Google, Microsoft a également publié une déclaration sur ses principes et son approche en matière d'IA, soulignant : « Nous nous engageons à garantir que les systèmes d'IA soient développés de manière responsable et d'une manière qui garantisse la confiance des gens... ». De plus, d’une manière ou d’une autre, les grandes entreprises technologiques qui investissent massivement dans le développement d’outils d’IA, comme Amazon et OpenAI, ont également pris leurs propres engagements.

De nombreux exemples dans l’histoire ont prouvé la nature bilatérale de la technologie, accompagnée d’éléments positifs et d’éléments négatifs. Après tout, même s’il s’agit d’une plateforme technologique très « high-tech », l’IA est toujours basée sur des algorithmes et des données développés et collectés par des humains ; Dans le même temps, la plupart des produits d’IA font partie des plans d’affaires des entreprises qui les possèdent.

Il existe donc toujours des risques potentiels, tant du côté technique que du côté de l’équipe de développement et de gestion des produits. L’enjeu ici est l’ampleur potentiellement énorme de l’impact que les outils d’IA peuvent avoir sur les masses, même au niveau socio-économique d’une communauté. L’attention opportune portée au contrôle éthique lors de l’utilisation de la technologie de l’IA est un signe bienvenu avec la participation d’organisations internationales à grande échelle telles que les Nations Unies, les gouvernements, les associations industrielles et surtout, au sein même des unités de développement technologique.

Cependant, tout comme la liste des outils d'IA publie continuellement de nouvelles versions, chacune plus sophistiquée et complexe que la précédente, les codes, principes ou lignes directrices doivent également être mis à jour et complétés en temps opportun, et en outre, doivent être proactifs pour prévenir, limiter et contrôler les unités de développement de produits et les utilisateurs dans un cadre où la capacité de se conformer au contrôle éthique de la technologie de l'IA en général et des travailleurs des médias en particulier peut atteindre la plus grande efficacité.

Source

Comment (0)