В предупреждении, распространенном на этой неделе, ФБР сообщило, что в последнее время наблюдается рост числа жертв шантажа, которые утверждают, что стали жертвами искусственного интеллекта, который редактировал обычные изображения, взятые из онлайн-публикаций, личных сообщений или видеочатов, превращая их в поддельные версии.

Испанская полиция однажды арестовала программиста, который использовал ИИ для создания поддельных изображений детской порнографии. Фото: Daily Mail

«Затем изображения напрямую отправляются жертвам злоумышленниками для шантажа или сексуальных домогательств. После распространения жертвы могут столкнуться со значительными трудностями в предотвращении дальнейшего распространения сфальсифицированного контента, а также в удалении его из интернета», — говорится в предупреждении.

Бюро заявило, что изображения выглядят «реалистично», отметив при этом, что в некоторых случаях объектами нападений также становились дети.

В феврале полиция Испании арестовала программиста, который использовал искусственный интеллект для создания ужасающих изображений насилия над детьми. Считается, что это был один из первых арестов такого рода.

ФБР не вдавалось в подробности о программах ИИ, используемых для создания сексуальных изображений, но отметило, что технологический прогресс «постоянно улучшает качество, настраиваемость и доступность создания контента с использованием ИИ».

Редактирование обычных фотографий для создания эротических изображений почти так же старо, как и сама фотография, но недавний взрывной рост числа инструментов искусственного интеллекта с открытым исходным кодом сделал этот процесс проще, чем когда-либо.

Поддельные фотографии и видео часто неотличимы от реальных версий. Фактически, за последние годы появилось несколько веб-сайтов и социальных сетей, посвященных созданию и обмену сексуальными изображениями с использованием искусственного интеллекта.

Это считается одним из ряда рисков, которые искусственный интеллект может представлять для общества, о чем недавно беспокоились и предупреждали эксперты.

Хоанг Ань (по данным Daily Mail, Reuters)

Источник

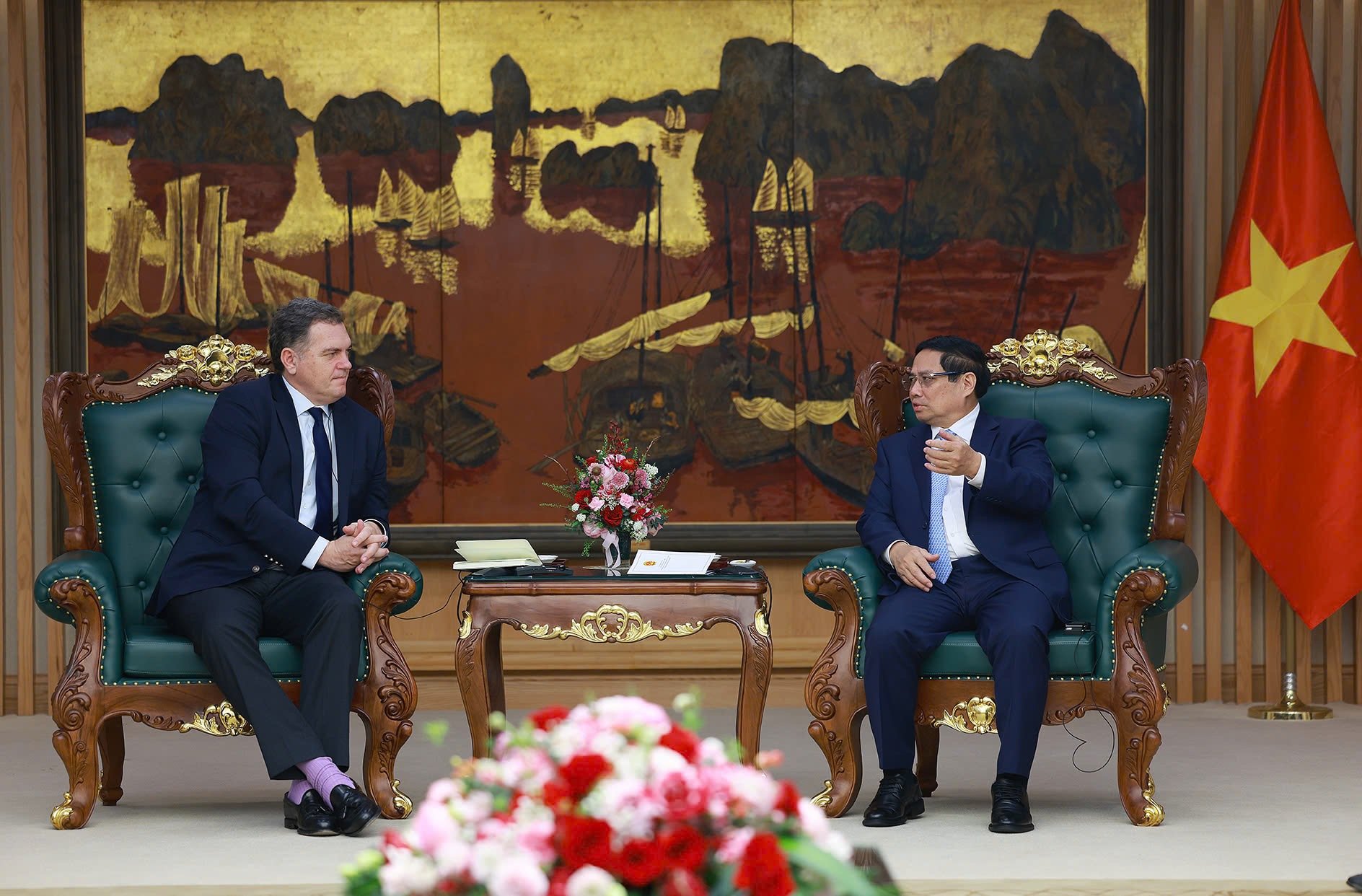

![[Фото] Премьер-министр Фам Минь Чинь принимает главу Республики Татарстан, Российская Федерация](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/7877cb55fc794acdb7925c4cf893c5a1)

![[Фото] Премьер-министр Фам Минь Чинь принимает французского министра транспорта](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/aa649691f85546d59c3624b1821ab6e2)

![[Фото] Познакомьтесь с пилотами эскадрильи «Победа»](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/fd30103acbd744b89568ca707378d532)

Комментарий (0)