Как работают поддельные изображения ИИ?

Сегодня ИИ повсюду — даже на войне. В этом году приложения на основе искусственного интеллекта значительно усовершенствовались, и практически каждый может использовать генераторы ИИ для создания изображений, которые выглядят реалистично, по крайней мере, на первый взгляд.

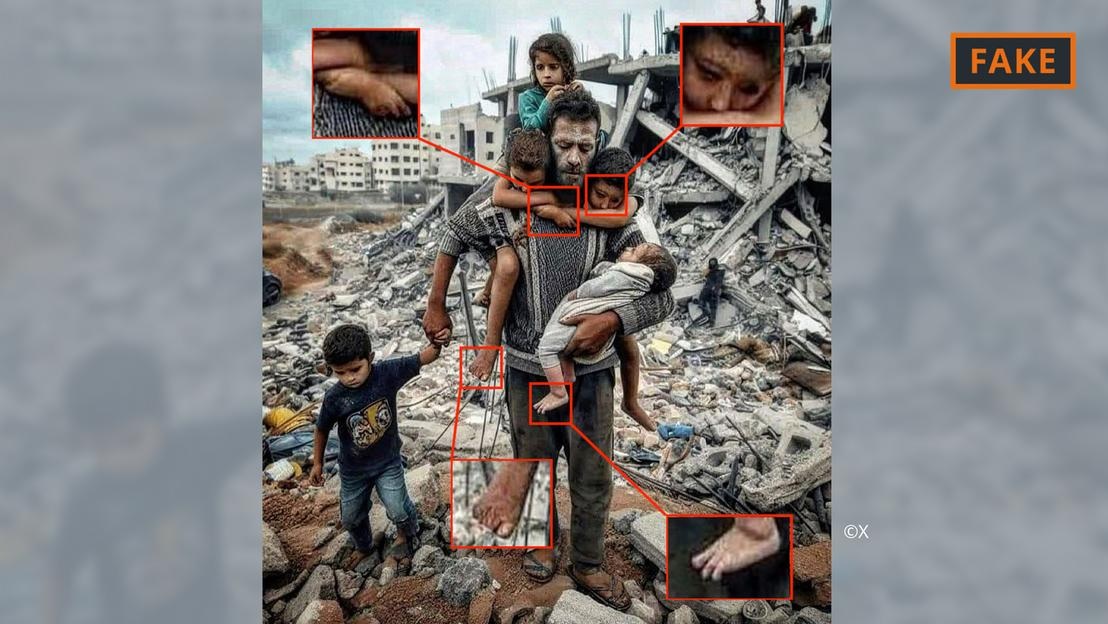

Созданная искусственным интеллектом фейковая фотография войны в Газе.

Для этого пользователям просто нужно предоставить таким инструментам, как Midjourney или Dall-E, несколько подсказок, включая технические характеристики и информацию. Затем инструменты ИИ преобразуют текстовые или даже голосовые подсказки в изображения.

Этот процесс генерации изображений основан на так называемом машинном обучении. Например, если создатель просит показать 70-летнего мужчину, едущего на велосипеде, он выполнит поиск в своей базе данных, чтобы сопоставить термины с изображением.

На основе имеющейся информации алгоритм ИИ сгенерирует изображение пожилого велосипедиста. Благодаря постоянно растущему объему информации и техническим обновлениям эти инструменты значительно усовершенствовались и постоянно обучаются.

Все это применяется к изображениям, связанным с конфликтом на Ближнем Востоке. По словам эксперта по искусственному интеллекту Хани Фарида, в конфликте, где «эмоции очень сильны», дезинформация, в том числе распространяемая с помощью изображений ИИ, оказывает огромное влияние.

Фарид, профессор цифровой аналитики Калифорнийского университета в Беркли, считает, что ожесточенные бои являются идеальной питательной средой для создания и распространения фейкового контента, а также для нагнетания эмоций.

Изображения войны Израиля и ХАМАС, полученные с помощью искусственного интеллекта

Изображения и видео, созданные с помощью искусственного интеллекта, подпитывают дезинформацию, связанную с войной на Украине, и то же самое продолжается в войне Израиля и ХАМАС.

По мнению экспертов, распространяемые в социальных сетях изображения войны, созданные искусственным интеллектом, часто делятся на две категории. Фильм, который фокусируется на страданиях людей и вызывает сочувствие. Другой — фальшивый ИИ, который преувеличивает события, тем самым провоцируя конфликты и эскалацию насилия.

Созданная искусственным интеллектом фейковая фотография отца и ребенка среди завалов в секторе Газа.

Например, к первой категории относится фотография выше, на которой изображен отец с пятью детьми на фоне груды обломков. Его много раз публиковали в X (ранее Twitter) и Instagram, его просмотрели сотни тысяч раз.

Это изображение было отмечено сообществом, по крайней мере на X, как поддельное. Его можно распознать по различным ошибкам и несоответствиям, которые часто встречаются в изображениях ИИ (см. изображение выше).

Похожие аномалии можно увидеть и на фейковом изображении ИИ, которое стало вирусным на сайте X ниже. На нем якобы изображена палестинская семья, обедающая вместе на руинах.

Сгенерированная искусственным интеллектом фейковая фотография палестинской вечеринки.

Между тем, еще одно изображение, на котором солдаты размахивают израильскими флагами, маршируя по поселению, заполненному разбомбленными домами, относится ко второй категории и призвано разжигать ненависть и насилие.

Откуда берутся такие ИИ-изображения?

Большинство изображений конфликтов, созданных с помощью ИИ, публикуются на платформах социальных сетей, но они также доступны на ряде других платформ и организаций, и даже на некоторых новостных сайтах.

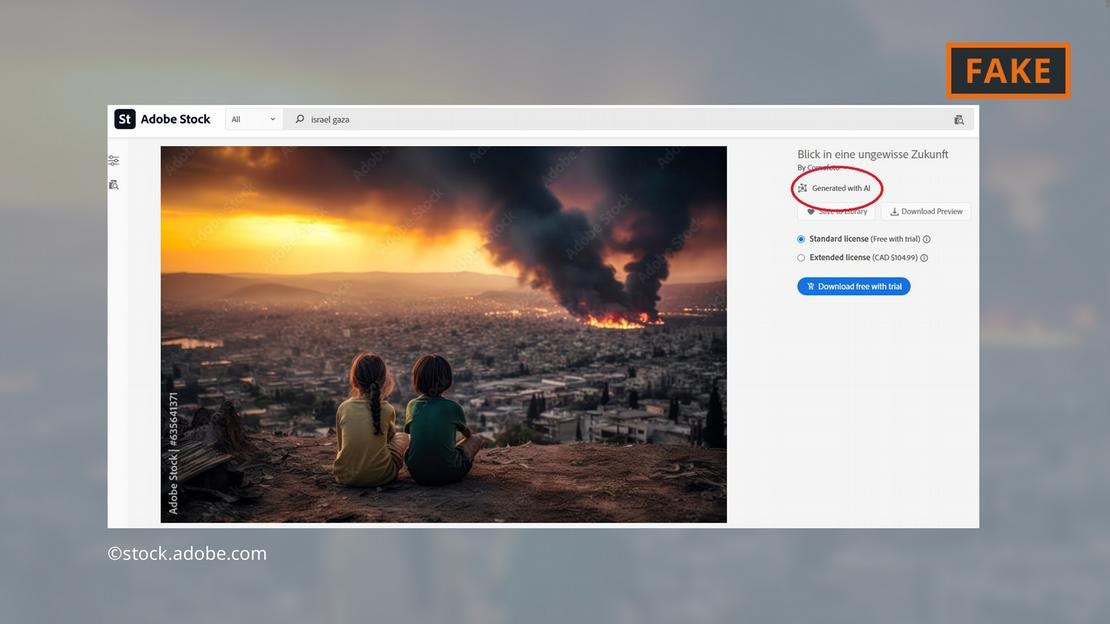

Компания-разработчик программного обеспечения Adobe произвела фурор, добавив к своему ассортименту стоковых фотографий к концу 2022 года изображения, созданные с помощью искусственного интеллекта. В базе данных они помечены соответствующим образом.

Adobe теперь также предлагает на продажу созданные с помощью искусственного интеллекта изображения войны на Ближнем Востоке — например, взрывы, протестующие или клубы дыма за мечетью Аль-Акса.

Adobe предлагает созданные с помощью искусственного интеллекта изображения боевых действий в секторе Газа.

Критики сочли это тревожным, поскольку некоторые сайты продолжали использовать изображения, не помечая их как созданные с помощью искусственного интеллекта. Например, приведенное выше изображение появилось на странице «Newsbreak» без какого-либо указания на то, что оно было создано с использованием ИИ.

Даже Европейская парламентская исследовательская служба, научное подразделение Европейского парламента, проиллюстрировала онлайн-документ о конфликте на Ближнем Востоке изображением из базы данных Adobe, созданным с помощью ИИ, — не пометив его как созданное с помощью ИИ.

Европейская обсерватория цифровых медиа призывает журналистов и специалистов в области СМИ быть предельно осторожными при использовании изображений, полученных с помощью искусственного интеллекта, и рекомендует воздержаться от их использования, особенно при освещении реальных событий, таких как война в секторе Газа.

Насколько опасны изображения, созданные с помощью ИИ?

Вирусный контент и изображения, созданные с использованием искусственного интеллекта, заставляют пользователей чувствовать себя неловко из-за всего, с чем они сталкиваются в сети. «Если мы вступаем в этот мир, где изображения, звуки и видео могут быть подвергнуты манипуляциям, все становится подозрительным. Поэтому вы теряете веру во все, включая правду», — объясняет исследователь из Калифорнийского университета в Беркли Фарид.

Именно это и произошло в следующем случае: премьер-министр Израиля Биньямин Нетаньяху и несколько других политиков поделились в социальных сетях фотографией, предположительно, обугленного тела израильского ребенка.

Антиизраильский влиятельный деятель Джексон Хинкль позже заявил, что изображение было создано с помощью искусственного интеллекта. Заявление Хинкля было просмотрено более 20 миллионов раз в социальных сетях и вызвало бурные дебаты на платформе.

В конечном итоге многочисленные организации и инструменты проверки объявили изображение подлинным, а утверждение Хинкля — ложным. Однако, очевидно, не существует инструмента, который мог бы помочь пользователям легко вернуть утраченное доверие!

Хоанг Хай (по данным DW)

Источник

![[Фото] Премьер-министр Фам Минь Чинь председательствует на специальном заседании правительства по вопросам организации административных единиц на всех уровнях.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/9/6a22e6a997424870abfb39817bb9bb6c)

![[Фото] Российская военная мощь продемонстрирована на параде в честь 80-летия победы над фашизмом](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/9/ce054c3a71b74b1da3be310973aebcfd)

![[Фото] Генеральный секретарь То Лам и мировые лидеры присутствуют на параде, посвященном 80-летию победы над фашизмом в России](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/9/4ec77ed7629a45c79d6e8aa952f20dd3)

![[Фото] Волшебный момент двойных пятицветных облаков на горе Баден в день шествия реликвий Будды](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/9/7a710556965c413397f9e38ac9708d2f)

Комментарий (0)