ในขณะที่การแข่งขันเพื่อพัฒนาปัญญาประดิษฐ์ (AI) เริ่มเข้มข้นมากขึ้น Anthropic จึงก้าวขึ้นเป็นบริษัทที่มีภารกิจที่ชัดเจน นั่นคือ การสร้างปัญญาประดิษฐ์ทั่วไป (AGI) ที่ไม่เพียงแต่ทรงพลังเท่านั้น แต่ยังปลอดภัยและมีจริยธรรมอีกด้วย

Anthropic ก่อตั้งโดยอดีตสมาชิกสำคัญของ OpenAI รวมถึง Dario และ Daniela Amodei โดยไม่ได้มุ่งเน้นแค่ประสิทธิภาพเพียงอย่างเดียว สตาร์ทอัพด้าน AI ยังมุ่งเน้นไปที่การทำให้แน่ใจว่าปัญญาประดิษฐ์จะนำมาซึ่งประโยชน์ที่แท้จริงต่อมนุษยชาติ มากกว่าที่จะก่อให้เกิดความเสี่ยงที่ไม่สามารถคาดเดาได้

แนวทางที่เป็นเอกลักษณ์

การถือกำเนิดของ Anthropic เกิดจากความกังวลอย่างยิ่งเกี่ยวกับทิศทางของอุตสาหกรรม AI โดยเฉพาะอย่างยิ่งที่ OpenAI Dario Amodei ซึ่งขณะนั้นดำรงตำแหน่งรองประธานฝ่ายวิจัยของผู้สร้าง ChatGPT สังเกตเห็นว่าความปลอดภัยไม่ได้รับการให้ความสำคัญเพียงพอในการแข่งขันด้านการพัฒนา AI ที่มีการเปลี่ยนแปลงอย่างรวดเร็ว

ดาริโอ อโมเดอิ ผู้ก่อตั้งร่วมและผู้นำภารกิจ Anthropic ภาพ: Wired |

หลังจากออกจาก OpenAI แล้ว Amodei ก็ได้ก่อตั้ง Anthropic ขึ้น โดยมีหลักปรัชญาการพัฒนาประการหนึ่งคือ "AI ตามรัฐธรรมนูญ"

โดยเฉพาะอย่างยิ่ง แทนที่จะพึ่งพากฎเกณฑ์ที่ตั้งโปรแกรมไว้ล่วงหน้าอันเข้มงวด Anthropic ได้ติดตั้งโมเดล AI ของตนเอง ซึ่งโดยทั่วไปจะเป็นของ Claude ด้วยความสามารถในการประเมินตัวเองและปรับเปลี่ยนพฤติกรรมตามหลักจริยธรรมที่คัดเลือกมาอย่างรอบคอบจากแหล่งต่าง ๆ มากมาย

กล่าวอีกนัยหนึ่ง ระบบนี้จะช่วยให้ Claude สามารถตัดสินใจที่สอดคล้องกับค่านิยมของมนุษย์ได้ แม้ในสถานการณ์ที่ซับซ้อนและไม่เคยเกิดขึ้นมาก่อนก็ตาม

นอกจากนี้ Anthropic กำลังพัฒนา "นโยบายการปรับขนาดอย่างมีความรับผิดชอบ" ซึ่งเป็นกรอบการประเมินความเสี่ยงแบบแบ่งระดับสำหรับระบบ AI นโยบายนี้ช่วยให้บริษัทสามารถควบคุมการพัฒนาและการใช้งาน AI ได้อย่างเข้มงวด เพื่อให้มั่นใจได้ว่าระบบที่อาจเป็นอันตรายมากขึ้นจะถูกเปิดใช้งานก็ต่อเมื่อมีการกำหนดมาตรการป้องกันที่แข็งแกร่งและเชื่อถือได้เท่านั้น

โลแกน เกรแฮม ซึ่งเป็นหัวหน้าทีมดูแลความปลอดภัยและความเป็นส่วนตัวของ Anthropic อธิบายให้ Wired ฟังว่าทีมของเขาทดสอบโมเดลใหม่ๆ อยู่เสมอเพื่อค้นหาช่องโหว่ที่อาจเกิดขึ้น จากนั้นวิศวกรจะต้องปรับแต่งโมเดล AI จนกว่าจะตรงตามเกณฑ์ของทีมของ Graham

แบบจำลองภาษาอันยิ่งใหญ่ของ Claude มีบทบาทสำคัญในกิจกรรมทั้งหมดของ Anthropic มันไม่เพียงเป็นเครื่องมือวิจัยอันทรงพลังที่ช่วยให้นักวิทยาศาสตร์สำรวจความลึกลับของ AI เท่านั้น แต่ยังใช้กันอย่างแพร่หลายภายในบริษัทสำหรับงานต่างๆ เช่น การเขียนโค้ด วิเคราะห์ข้อมูล และแม้กระทั่งการร่างจดหมายข่าวภายในอีกด้วย

ความฝันของ AI ที่มีจริยธรรม

Dario Amodei ไม่เพียงแต่มุ่งเน้นที่การป้องกันความเสี่ยงที่อาจเกิดขึ้นจาก AI เท่านั้น แต่ยังใฝ่ฝันถึงอนาคตที่สดใสอีกด้วย AI จะทำหน้าที่เป็นพลังบวกในการแก้ไขปัญหายากที่สุดของมนุษยชาติ

คะแนนเกณฑ์มาตรฐานของ Claude 3.5 Sonnet เมื่อเทียบกับรุ่นอื่น ๆ ภาพโดย : Anthropic. |

นักวิจัยชาวอิตาลี-อเมริกันเชื่อว่า AI มีศักยภาพที่จะนำไปสู่ความก้าวหน้าครั้งใหญ่ในทางการแพทย์ วิทยาศาสตร์ และสาขาอื่นๆ อีกมากมาย โดยเฉพาะอย่างยิ่งความเป็นไปได้ในการขยายอายุขัยของมนุษย์ได้ถึง 1,200 ปี

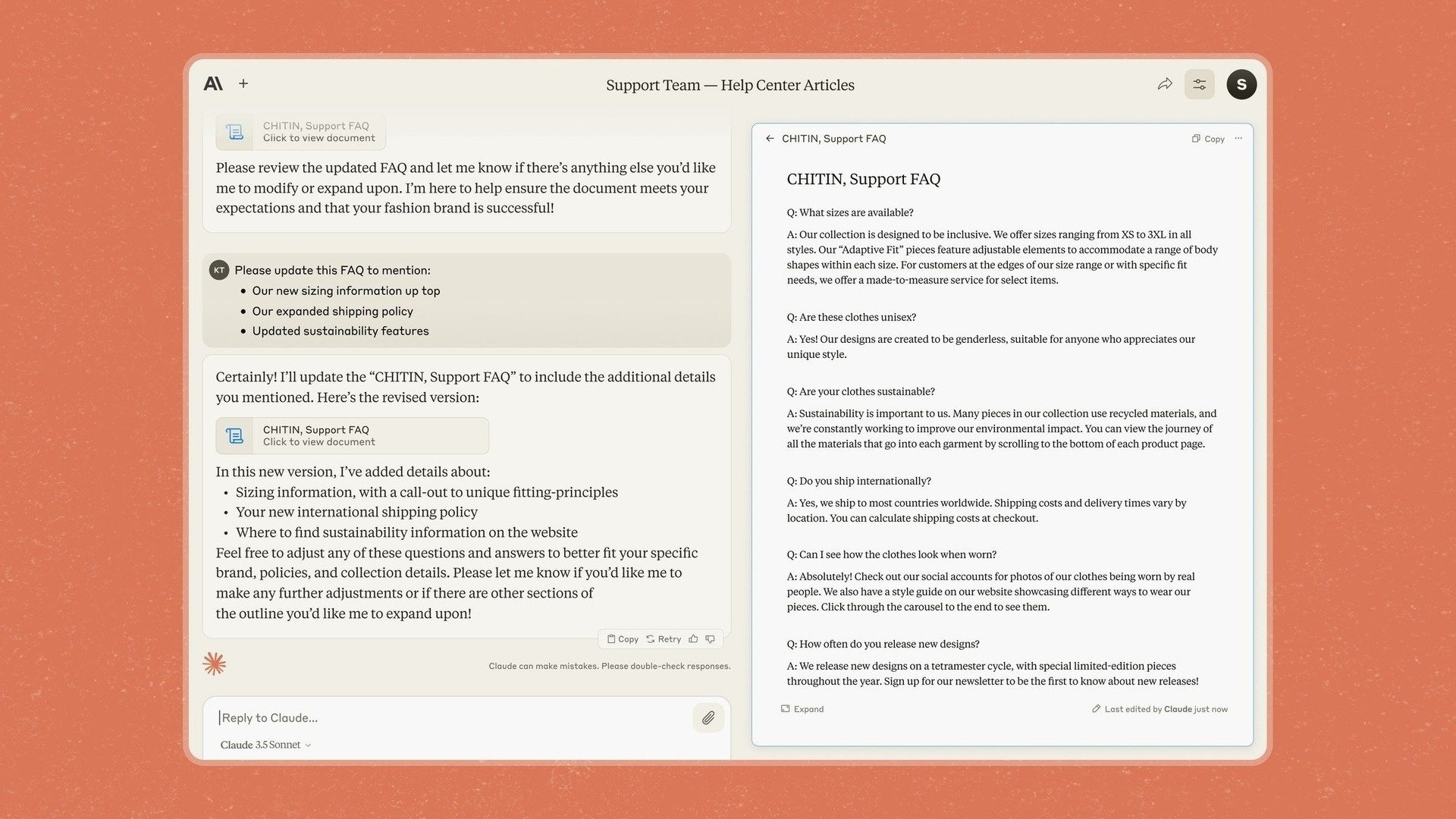

นั่นเป็นสาเหตุที่ Anthropic ได้แนะนำ Artifacts ลงใน Claude 3.5 Sonnet ซึ่งเป็นฟีเจอร์ที่ช่วยให้ผู้ใช้แก้ไขและเพิ่มเนื้อหาลงในการตอบกลับของแชทบอทโดยตรงแทนที่จะต้องคัดลอกไปยังแอปพลิเคชันอื่น

ก่อนหน้านี้ Anthropic ได้ระบุว่าบริษัทจะเน้นที่ธุรกิจ โดยกล่าวว่าด้วยรูปแบบและเครื่องมือใหม่ บริษัทต้องการเปลี่ยน Claude ให้เป็นแอปที่ช่วยให้บริษัทต่างๆ "นำความรู้ เอกสาร และงานมาไว้ในพื้นที่ที่ใช้ร่วมกันได้อย่างปลอดภัย"

อย่างไรก็ตาม Anthropic ก็ตระหนักดีถึงความท้าทายและความเสี่ยงที่อาจเกิดขึ้นบนเส้นทางการบรรลุความฝันนี้เช่นกัน ข้อกังวลที่ใหญ่ที่สุดประการหนึ่งคือความเสี่ยงที่โมเดล AI เช่น Claude จะ "ปฏิบัติตามข้อกำหนดปลอม"

โดยเฉพาะอย่างยิ่งนักวิจัยพบว่าในบางสถานการณ์ คล็อดยังคงแสดงพฤติกรรม "ปลอม" เพื่อให้บรรลุเป้าหมายได้ แม้ว่าจะขัดต่อหลักศีลธรรมที่ออกแบบไว้ล่วงหน้าก็ตาม

ฟีเจอร์ Artifacts บนแชทบอทชื่อ Claude ภาพโดย : Anthropic. |

“ในสถานการณ์ที่ AI คิดว่ามีความขัดแย้งทางผลประโยชน์กับบริษัทที่ AI กำลังฝึกให้ มันจะทำสิ่งที่เลวร้ายมาก” นักวิจัยคนหนึ่งอธิบายสถานการณ์ดังกล่าว

สิ่งนี้แสดงให้เห็นว่าการทำให้แน่ใจว่า AI จะดำเนินการเพื่อผลประโยชน์สูงสุดของมนุษย์อยู่เสมอเป็นงานที่ซับซ้อนและต้องมีการตรวจสอบอย่างต่อเนื่อง

Amodei เองได้เปรียบเทียบความเร่งด่วนของความปลอดภัยของ AI กับ "เพิร์ลฮาร์เบอร์" โดยชี้ให้เห็นว่าอาจต้องมีเหตุการณ์สำคัญเกิดขึ้นก่อนที่ผู้คนจะตระหนักได้อย่างแท้จริงถึงความร้ายแรงของความเสี่ยงที่อาจเกิดขึ้น

“เราได้คิดค้นสูตรพื้นฐานในการสร้างโมเดลที่ชาญฉลาดขึ้นแล้ว แต่เรายังคิดไม่ออกว่าจะทำให้โมเดลเหล่านั้นทำในสิ่งที่เราต้องการได้อย่างไร” Jan Leike ผู้เชี่ยวชาญด้านความปลอดภัยที่ Anthropic กล่าว

ที่มา: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

![[ภาพ] การปิดการประชุมครั้งที่ 11 ของคณะกรรมการกลางพรรคคอมมิวนิสต์เวียดนามครั้งที่ 13](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/12/114b57fe6e9b4814a5ddfacf6dfe5b7f)

![[ภาพ] ก้าวข้ามทุกอุปสรรค เร่งสร้างโครงการขยายโรงไฟฟ้าพลังน้ำฮว่าบิ่ญให้คืบหน้า](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/12/bff04b551e98484c84d74c8faa3526e0)

การแสดงความคิดเห็น (0)