説明責任を育むことは、AI をより有用なものにするための重要な要素です。イラスト:ブルームバーグ。 |

生成AIは多くの分野に変化をもたらしています。教育分野では、AI が学習をサポートし、盗作を検出し、指導を支援します。医療分野では、AI が画像診断、治療計画の個別化、医薬品の研究をサポートします。このツールは、自動コンテンツ作成を促進し、顧客ケアをサポートし、ビジネスとマーケティングにおける「仮想KOL」を作成します。

生成 AI の普及はメリットとともに、ツールが偏見を増幅させ、誤った情報を広める可能性があるため、倫理的な懸念も引き起こします。 AI はプライバシー、データ セキュリティ、労働力の安定性を損なう可能性もあります。

世界中の多くの国と同様に、ベトナムも生成型 AI の応用で台頭しています。 AIを人間にとって有害なものではなく、有用なツールにするためには、責任を持ってAIを開発することが重要な課題の一つです。

責任あるAIのトレンド

RMITベトナムの情報技術上級講師サム・グンダール博士は、生成AIの倫理をめぐる論争のいくつかを改めて指摘する。テイラー・スウィフトのフェイクポルノスキャンダルから、ジョー・バイデン前米大統領のなりすまし電話、AIを使った学術詐欺まで。

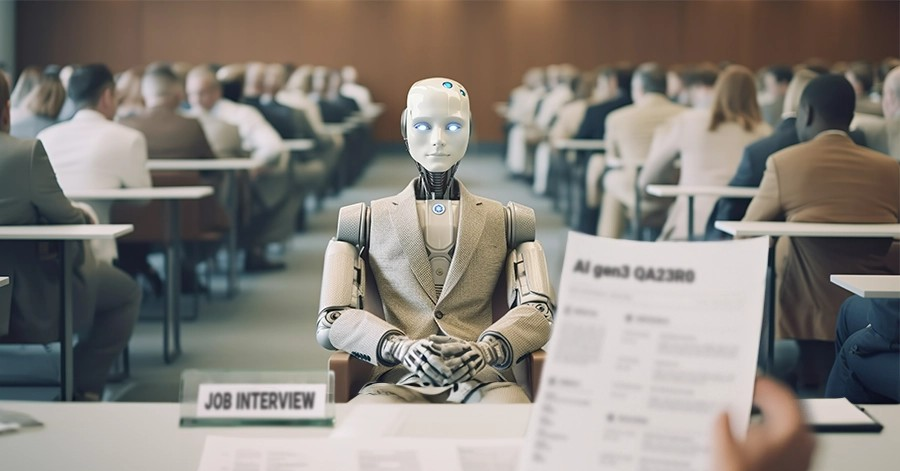

「さらに心配なのは、チャットボットが自殺を扇動したり、児童虐待コンテンツを作成したり、暗殺を奨励したり、偏った採用アルゴリズムを使用したり、AIによってセキュリティの脆弱性が悪用されたりするケースです。

これらの問題は、AIの誤用を軽減し、個人と社会の利益を保護するために人間中心のアプローチが必要であることを浮き彫りにしています」とグンダール博士は述べています。

Microsoft Copilot ツール画面。写真:ブルームバーグ。 |

グンダール博士によると、2025 年には責任ある人間中心の AI へのトレンドが見られるようになるでしょう。偏見、誤報、倫理的リスクに対する懸念が高まる中、透明な AI (XAI) テクノロジーが優先され、AI がどのように意思決定を行うかをユーザーが理解できるように支援しています。

米国、カナダ、オーストラリア、中国、日本などのいくつかの国では、業界全体で倫理的な AI の導入を管理および保証するために AI 規制を導入し始めています。

もう一つのトレンドは、AIと人間を組み合わせたモデルであるハイブリッドAIであり、これも2025年に発展する可能性があります。

持続可能な開発において、AI は気候変動への取り組みやグリーン テクノロジーの推進に役立ちます。さらに、AI はサイバーセキュリティにおける応用を拡大し、デジタル空間におけるリスクの分析や脅威への対応能力の向上に貢献します。

「AIの導入が加速する中、テクノロジーのメリットを最適化し、潜在的なリスクを軽減するには、責任あるAIガバナンスを確保することが不可欠です」とグンダール博士は強調しました。

責任あるAI開発ソリューション

ベトナムはAI分野で積極的に革新を進めている国の一つです。したがって、偏った AI アルゴリズム、プライバシーのリスク、および国民の信頼の喪失を回避するには、倫理的な AI 開発を確保することが重要です。

倫理原則に従って AI を開発するために、グンダール博士は、AI 倫理に関する研究への投資や、大学と協力して責任ある AI 展開のための法的枠組みを提供するなど、いくつかの解決策を提案しました。

次に、AI 倫理を大学のカリキュラムに統合し、ビジネスリーダー、教育者、政策立案者向けの AI トレーニング プログラムを拡大することを検討します。

責任と倫理を促進することは、AI が人間にとって有用なツールとなるのに役立ちます。写真:ブルームバーグ。 |

国民の意識を高め、個人や企業が AI がプライバシーに与える影響を理解できるようにすることも重要です。さらに、利益だけに焦点を当てるのではなく、医療、環境、教育などの社会的な目的に AI を応用することを奨励することもできます。

教育と意識向上に加えて、法的枠組みも責任ある AI 開発を持続させる上で重要な役割を果たします。

RMITベトナムの専門家は、AIに対するより厳しい規制の適用、国際的なAIガバナンスモデルへのアプローチ、倫理的なAI認証の開始、高リスクシステムを評価およびテストするためのAIリスク分類および監査システムの構築など、いくつかの解決策を提案しました。

「ベトナムは2030年までに地域のAI大国になることを目指しており、その成功は技術の進歩だけでなく、強力な規制、倫理的なAI投資、潜在的なリスクに対抗するための国民の意識にもかかっている」とグンダール博士は強調した。

出典: https://znews.vn/xu-huong-ai-moi-cua-nam-2025-post1538816.html

![[写真] クチトンネル訪問 - 英雄的な地下の偉業](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/8/06cb489403514b878768dd7262daba0b)

コメント (0)