Lors de sa conférence annuelle GTC, Nvidia a annoncé ses dernières avancées dans la course à la domination du marché des puces d'intelligence artificielle (IA) avec deux nouvelles gammes de produits phares, Blackwell Ultra et Vera Rubin.

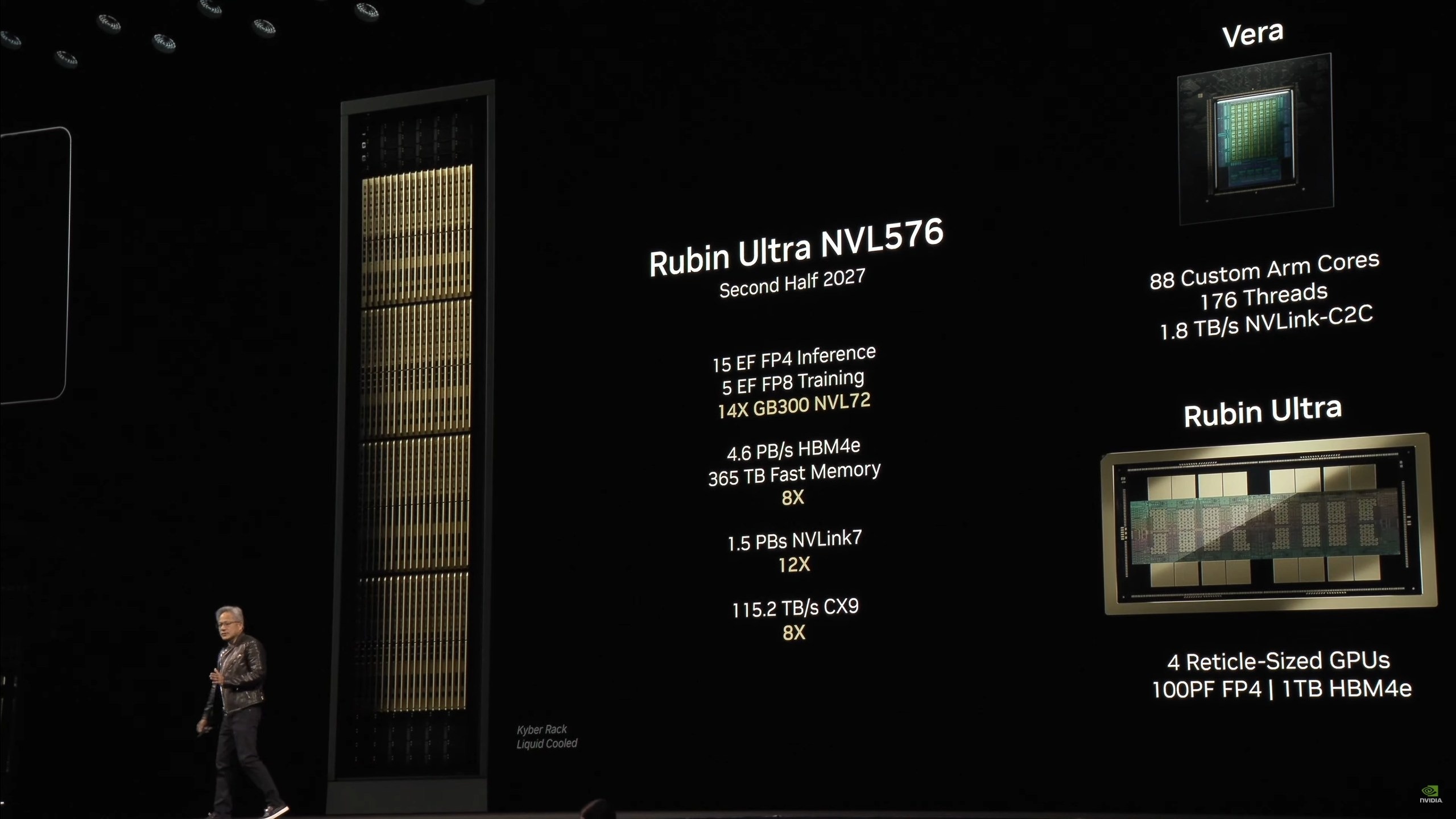

Selon le PDG Jensen Huang, le lancement de Blackwell Ultra est prévu au second semestre 2025. Parallèlement, Vera Rubin, l'architecture GPU de nouvelle génération, apparaîtra en 2026, suivie de Rubin Ultra en 2027.

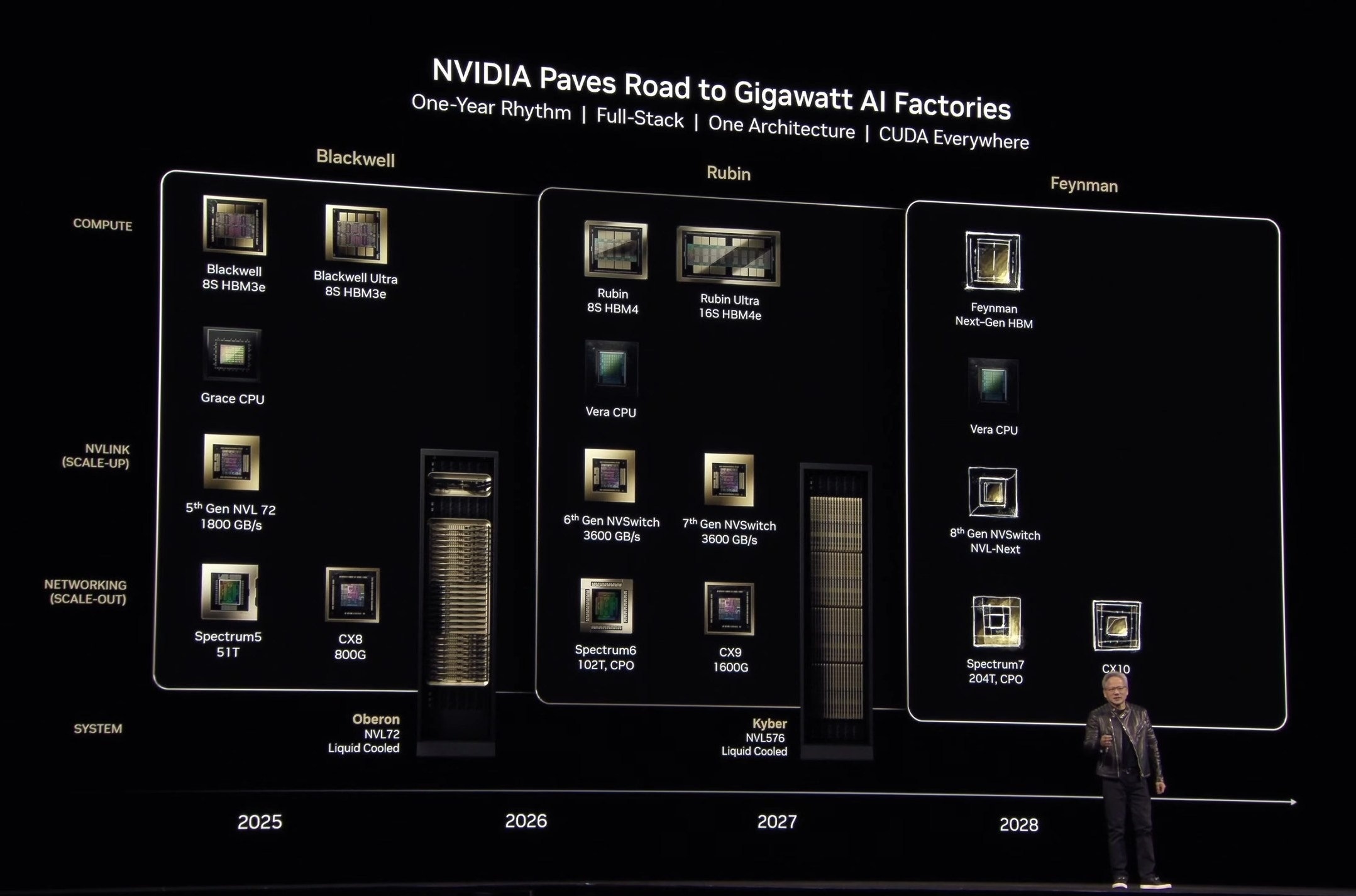

Ces annonces démontrent non seulement les prouesses technologiques supérieures de Nvidia, mais marquent également un changement dans la stratégie de sortie de produits de l'entreprise, passant d'un cycle biennal à un cycle annuel.

Blackwell Ultra : un grand pas en avant sur la plateforme Blackwell

En 2024, la puce Blackwell AI a occupé le devant de la scène. Selon le géant des puces, les processeurs basés sur l'architecture Blackwell, tels que le GB200, apportent d'énormes améliorations de performances aux entreprises appliquant l'IA.

Cependant, ce n'est que récemment que le Blackwell a commencé à être expédié en grand nombre, suite aux retards liés à la production en série de cette conception complexe.

Des rumeurs ont circulé dans l'industrie concernant les défauts de conception de la plateforme. La fenêtre de livraison initiale du troisième trimestre 2024 a été déplacée à 2025. Lors de la réunion qui a suivi la publication du rapport financier, la moitié des investisseurs de NVIDIA ont remis en question le problème de Blackwell.

Pour « compenser », Jensen Huang a présenté une version améliorée de cette gamme de puces, appelée Blackwell Ultra, lors de son discours lors de l'événement.

|

La nouvelle feuille de route des GPU de Nvidia. Photo : Nvidia. |

Plus précisément, Blackwell Ultra est une version améliorée de l’architecture Blackwell, axée sur l’optimisation des performances et de la mémoire pour des tâches d’IA de plus en plus complexes.

Bien qu'il ne s'agisse pas d'une architecture entièrement nouvelle, Blackwell Ultra offre néanmoins des améliorations significatives par rapport à la génération précédente, en particulier le H100 (lancé en 2022), la gamme de puces qui a jeté les bases du succès de Nvidia dans le domaine de l'IA.

En conséquence, une seule puce Blackwell Ultra a des performances d'IA de 20 pétaflops, équivalentes à Blackwell, mais est équipée jusqu'à 288 Go de mémoire HBM3e. Cette mise à niveau représente une augmentation significative par rapport au stockage de 192 Go du Blackwell. Ceci est particulièrement important pour les grands modèles d’IA qui nécessitent un accès rapide aux données.

Comparé au H100, Blackwell Ultra offre des performances d'inférence FP4 1,5 fois supérieures et accélère considérablement le « raisonnement de l'IA ».

Le cluster NVL72 utilisant Blackwell Ultra peut exécuter le grand modèle de langage DeepSeek-R1 671B et renvoyer une réponse en seulement 10 secondes, un bond par rapport aux 1,5 minutes du H100. En particulier, cette nouvelle puce est capable de traiter jusqu'à 1 000 jetons par seconde, soit 10 fois plus que le H100.

Selon Nvidia, les principaux clients ont acheté trois fois plus de puces Blackwell que Hopper, démontrant une forte confiance et une forte demande pour l'architecture.

Architecture GPU de nouvelle génération pour 2026

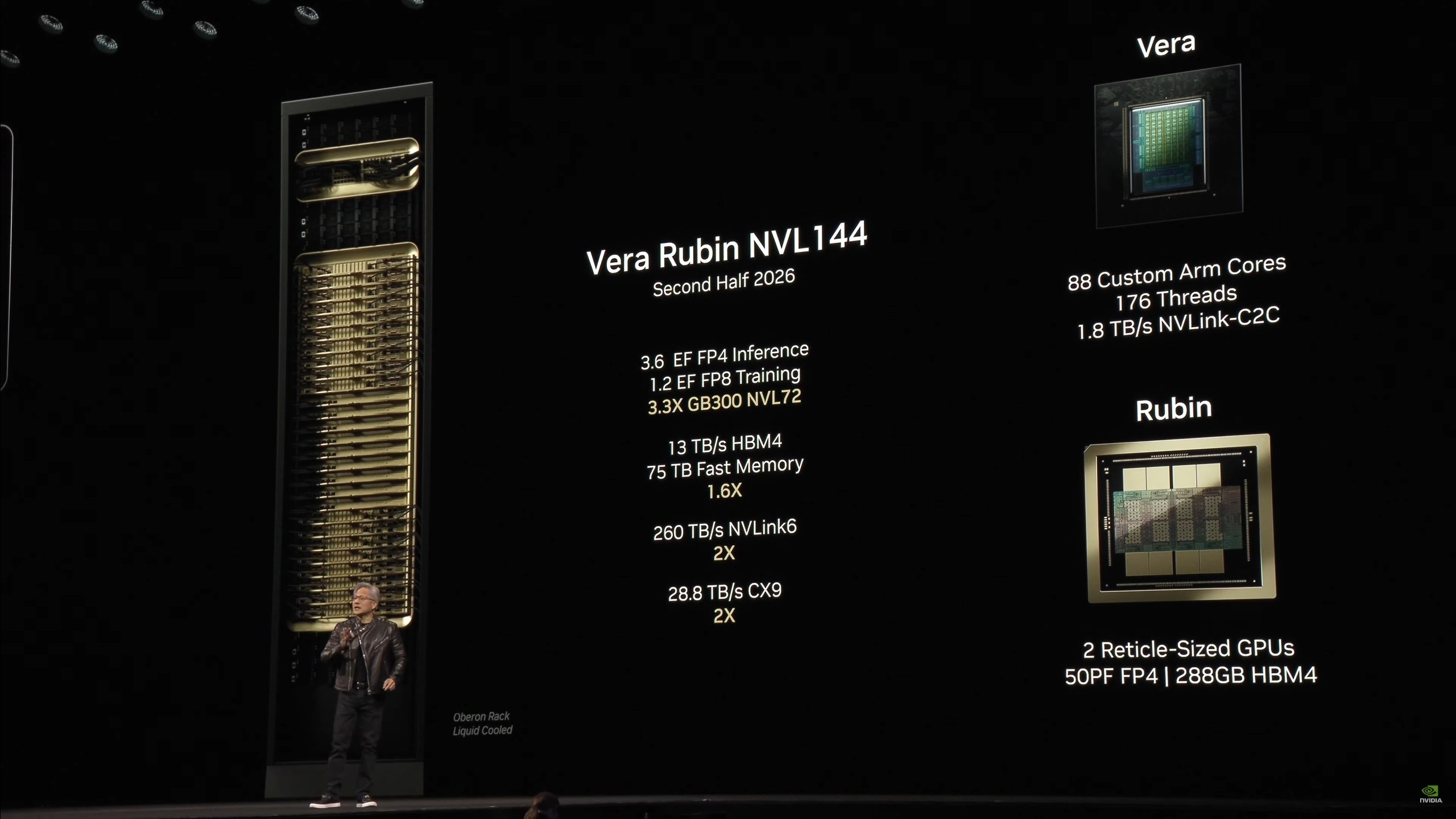

Après Blackwell Ultra, le géant des puces a dévoilé son architecture GPU de nouvelle génération appelée Vera Rubin, dont le lancement est prévu au second semestre 2026. Ce système comprend deux composants principaux : le CPU Vera (la première conception de CPU personnalisée de Nvidia basée sur l'architecture Olympus) et le GPU Rubin.

Selon The Verge , le processeur Vera est conçu pour être deux fois plus rapide que le processeur utilisé dans la puce Grace Blackwell 2024.

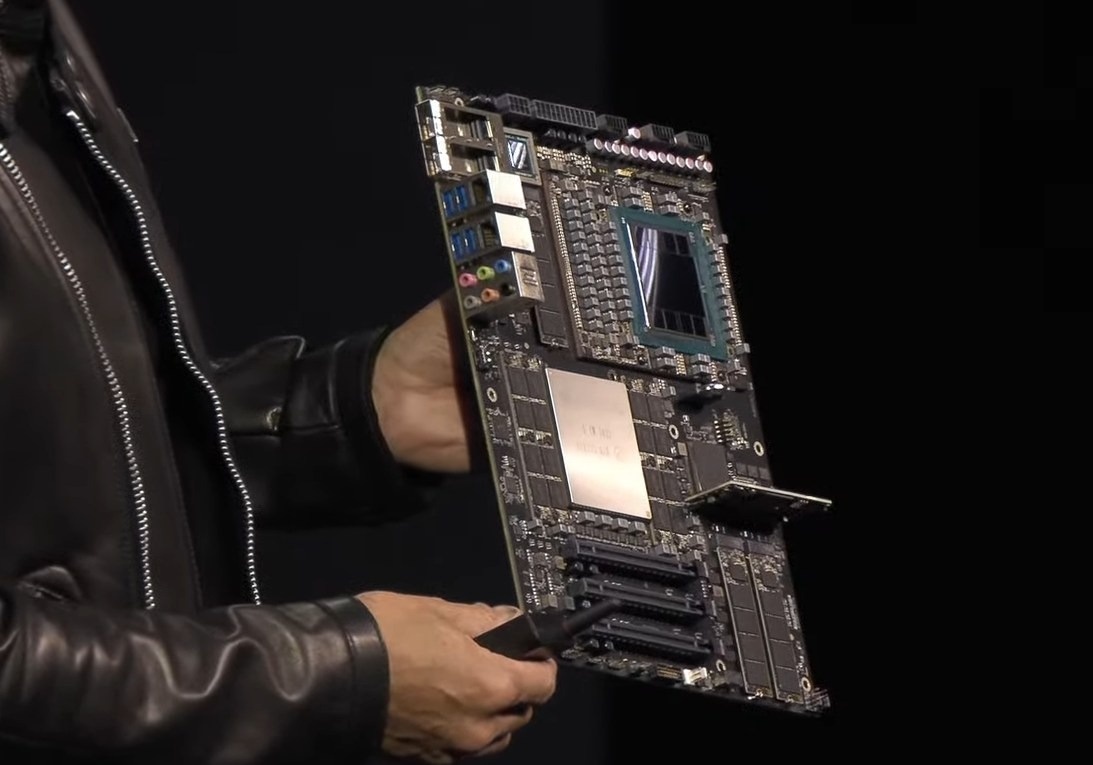

|

La carte mère de bureau DGX Station intègre le GPU Blackwell Ultra de Nvidia à bord. Photo : Nvidia. |

Pendant ce temps, le GPU Rubin promet d'offrir des performances supérieures avec la capacité de gérer 50 pétaflops lors de l'exécution de l'inférence, soit plus du double des 20 pétaflops de la puce Blackwell actuelle. Rubin prend également en charge jusqu'à 288 Go de mémoire rapide, une spécification importante pour les développeurs d'IA.

Un autre changement notable est que Nvidia va redéfinir le concept de GPU avec Rubin. Au lieu de considérer une seule puce assemblée à partir de plusieurs composants comme un GPU, Nvidia désignera chaque composant comme un GPU distinct lorsqu'ils sont combinés. Cela signifie que la puce Rubin aura jusqu'à deux GPU sur une seule puce.

Enfin, le plus grand fabricant de GPU au monde prévoit de lancer Rubin Ultra (également connu sous le nom de Rubin Next) au cours du second semestre 2027. Rubin Ultra constituera un énorme bond en avant en termes de performances, car une seule puce contiendra deux GPU Rubin connectés ensemble, offrant jusqu'à 100 pétaflops de performances FP4.

À titre de comparaison, ces performances sont le double de celles d’un GPU Rubin. De plus, la mémoire du Rubin Ultra est également considérablement améliorée pour atteindre 1 To.

À la fin de la présentation, Nvidia a continué à dévoiler sa feuille de route de développement à long terme en déclarant que l'architecture de la puce après Vera Rubin, dont le lancement est prévu en 2028, portera le nom de Feynman d'après le célèbre physicien théoricien Richard Feynman.

|

Les performances du duo utilisant l'architecture GPU de nouvelle génération appelée Vera Rubin devraient être lancées en 2026 et 2027. Photo : Nvidia. |

Ces nouvelles annonces interviennent alors que Nvidia profite grandement du boom de l’IA. Les ventes de l'entreprise ont été multipliées par six depuis le lancement de ChatGPT, grâce à la domination du GPU de Nvidia dans le développement de l'IA.

La demande de puissance de calcul de l’IA augmente à un rythme rapide, et le PDG Jensen Huang estime que l’industrie aura besoin de 100 fois plus de puissance de calcul que prévu d’ici 2024 pour répondre à cette demande.

L'un des points forts notables du GTC 2025 est que Nvidia travaille en étroite collaboration avec des sociétés d'IA de premier plan, notamment DeepSeek en Chine. L'utilisation du modèle R1 de DeepSeek pour évaluer ses nouvelles puces montre que le géant des semi-conducteurs se concentre sur les performances dans les tâches d'inférence complexes.

Source : https://znews.vn/at-chu-bai-moi-cua-nvidia-da-lo-dien-post1539279.html

Comment (0)