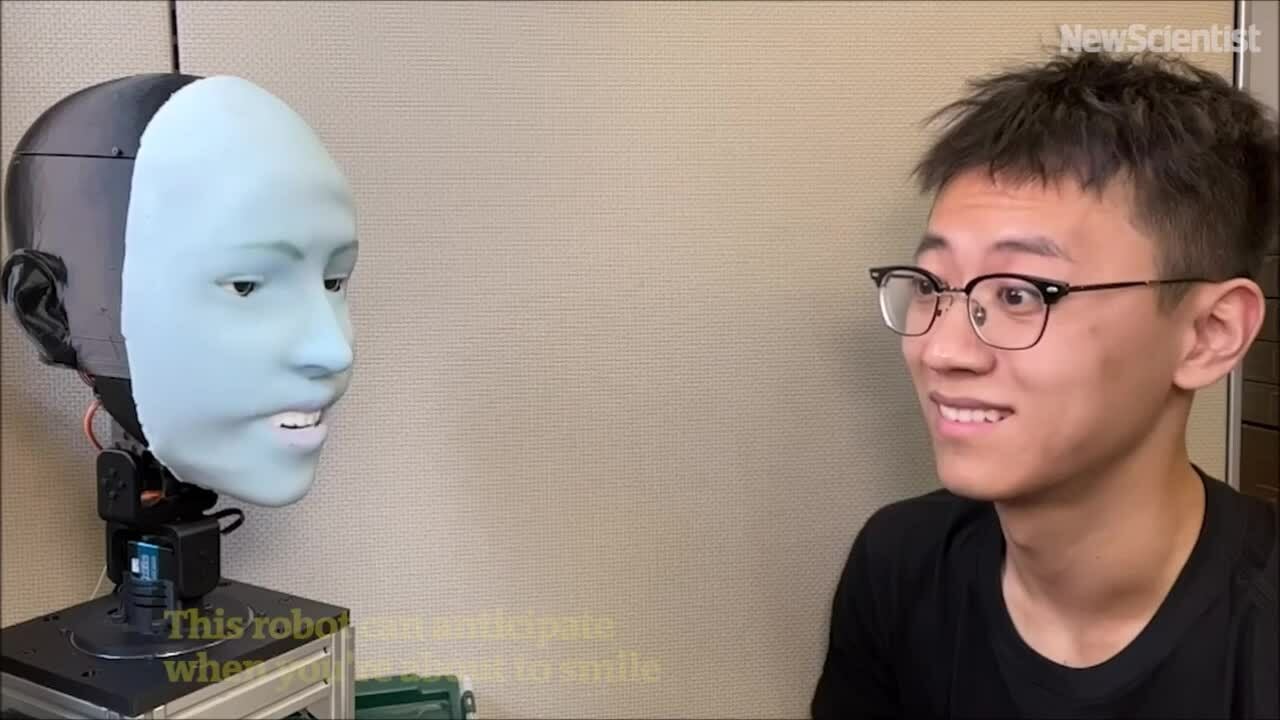

アメリカのロボット「エモ」は、向かい側の人が笑う約 840 ミリ秒前に笑顔を予測し、同時に笑顔を浮かべることができます。

エモロボットは、相手の表情を予測し、同時に笑顔を浮かべることができます。ビデオ:ニューサイエンティスト

ChatGPTのような大規模言語モデルの進歩もあって、人間は言語的に流暢にコミュニケーションできるロボットに慣れつつあるが、非言語コミュニケーション能力、特に表情に関しては、まだ大きく遅れをとっている。さまざまな表情を表現できるだけでなく、適切なタイミングでその表情を表現する方法も知っているロボットを設計することは非常に困難です。

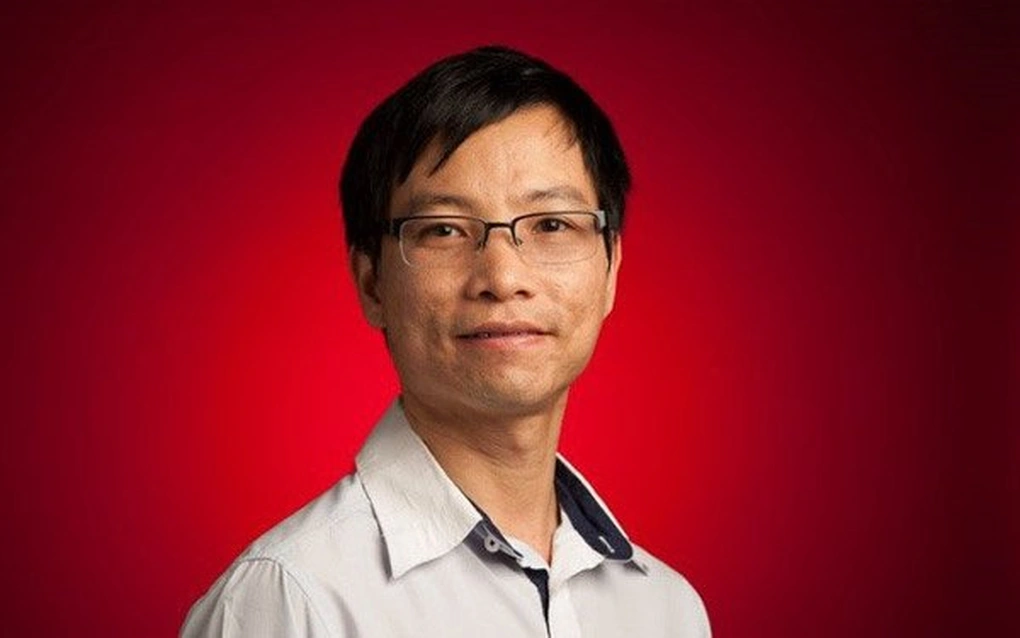

コロンビア大学工学部のイノベーティブマシン研究所は、5年以上にわたってこの問題を研究してきました。科学誌「サイエンス・ロボティクス」に掲載された新たな研究で、ここの専門家チームは、人間の表情を予測し、その人と同時に表情を再現できるAIロボット「Emo」を発表したと、 TechXploreが3月27日に報じた。人が笑う約 840 ミリ秒前に笑顔を予測し、同時に笑顔になります。

Emo は、多彩な表情を可能にする 26 個のアクチュエータを搭載した顔を持つヒューマノイド ロボットです。ロボットのヘッドは磁気リンクシステムを備えた柔らかいシリコンスキンで覆われており、簡単に調整でき、メンテナンスも素早く行えます。より没入感のあるインタラクションを実現するために、チームは高解像度のカメラを各目の瞳孔に組み込み、エモが非言語コミュニケーションに不可欠な目でインタラクションできるようにしました。

チームは2つの AI モデルを開発しました。最初のモデルは、反対側の顔の微妙な変化を分析することで人間の表情を予測し、2 番目のモデルは対応する表情を使用して運動コマンドを生成します。

ロボットに感情表現を訓練するために、研究チームはエモをカメラの前に置き、ランダムな動きをさせた。数時間後、ロボットは顔の表情と運動命令の関係を学習した。これは人間が鏡を見て表情を練習するのと似ている。研究者たちはこれを「自己モデリング」と呼んでいます。これは、人間が特定の表情をしたときに自分がどのように見えるかを想像する能力に似ています。

次に、研究チームはエモがフレームごとに観察できるように人間の表情のビデオを再生しました。何時間もの訓練を経て、エモは人が笑おうとするときの微妙な顔の変化を観察して表情を予測できるようになりました。

「人間の表情を正確に予測することは、人間とロボットのインタラクションの分野における革命だと思います。これまで、ロボットはインタラクション中に人間の表情を考慮するようには設計されていませんでした。現在、ロボットは表情を統合して応答することができます」と、クリエイティブマシンラボの博士課程の学生で研究チームのメンバーであるユーハン・フー氏は述べた。

「ロボットが人間と同時にリアルタイムで表情を見せるということは、やりとりの質が向上するだけでなく、人間とロボットの間に信頼関係を築くことにも役立ちます。将来的には、ロボットとやりとりをする際に、ロボットは本物の人間と同じように、あなたの表情を観察し、解釈するようになるはずです」と胡氏は付け加えた。

Thu Thao ( TechXploreによる)

[広告2]

ソースリンク

コメント (0)