サイバーセキュリティ企業SlashNextの報告によると、サイバー犯罪者はChatGPTのような生成型人工知能(AI)ツールを活用してフィッシングメールを作成し、企業などを騙している。北米のサイバーセキュリティ専門家300人以上を対象にした調査では、ほぼ半数が自社を狙ったフィッシング攻撃に遭遇したことがあると回答し、77%が自分自身も悪意のある攻撃者の標的になったことがあると回答しました。

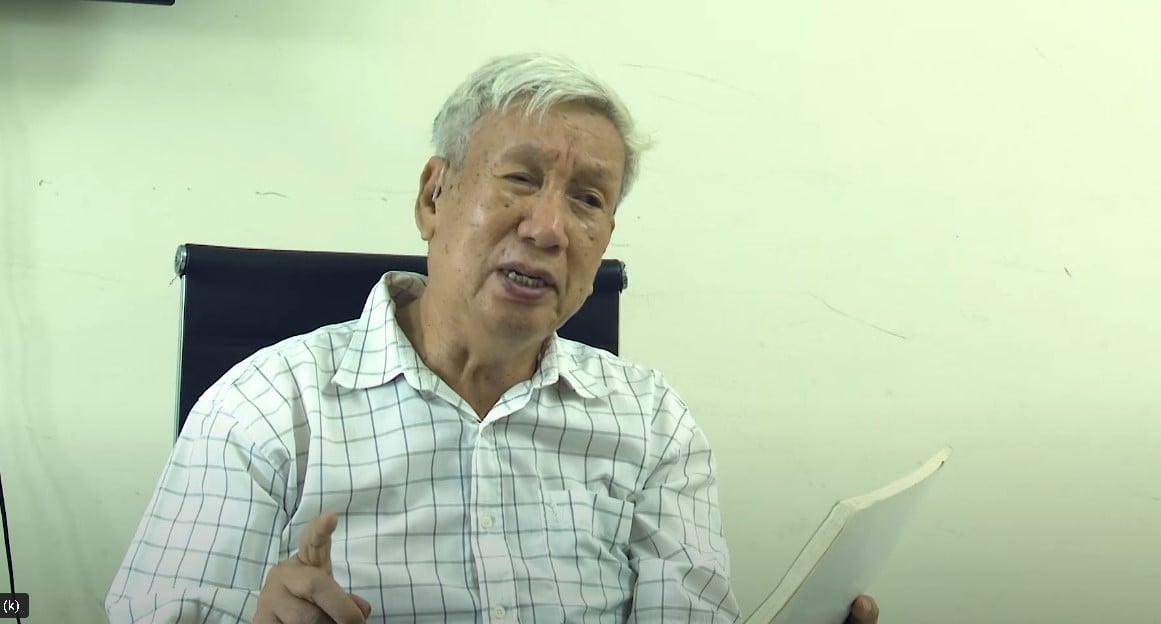

スラッシュネクストのCEO、パトリック・ハー氏は、今回の調査結果は、生成AIが詐欺の増加に寄与しているのではないかという懸念を強めるものだと述べた。犯罪者は成功率を高めるために、マルウェアやソーシャル エンジニアリング詐欺を開発する際に AI を使用することがよくあります。

報告によると、毎日平均 31,000 件のオンライン詐欺が発生しています。

ハー氏はさらに、ChatGPTが2022年後半に開始される時期は、SlashNextでフィッシング攻撃が急増した時期と一致すると付け加えた。

米連邦捜査局(FBI)のインターネット犯罪報告書によると、企業に偽のメールを送信する手口により、2022年までに約27億ドルの被害が発生した。

生成AIがサイバー犯罪に実際どのような影響を与えるかは議論があるが、ハー氏はChatGPTのようなチャットボットがサイバー攻撃の「武器」に転用されていると考えている。たとえば、7月にSlashNextの研究者は、WormGPTとFraudGPTと呼ばれる2つの悪意のあるチャットボットを発見しました。これらは、詐欺師が高度なフィッシングキャンペーンを実行するためのツールであると考えられていました。

エンタープライズ・マネジメント・アソシエイツのリサーチディレクター、クリス・ステッフェン氏は、ハッカーは詐欺を働くために生成AIツールと自然言語処理(NLP)モデルを利用していると述べた。 AI を使用して古い情報や記事を分析し、政府や企業の文書を模倣することで、フィッシング メールは非常に説得力のあるものになり、見分けることが困難になります。

攻撃の増加に対処するには、セキュリティ意識を高め、疑わしい電子メールや活動に対して警戒する必要があります。もう 1 つの解決策は、詐欺を防ぐために AI と機械学習を使用した電子メール フィルタリング ツールを導入することです。組織は、定期的なセキュリティ監査を実施し、従業員のトレーニング中にシステムの脆弱性と弱点を特定し、既知の問題に迅速に対処して攻撃のリスクを軽減する必要もあります。

[広告2]

ソースリンク

![[写真] フック・トーの桑の実の季節 – 緑の農業から生まれた甘い果実](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/1710a51d63c84a5a92de1b9b4caaf3e5)

![[写真] ファム・ミン・チン首相がベトナムの輸出入品に対する税制上の解決策を議論する会議を主宰](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/19b9ed81ca2940b79fb8a0b9ccef539a)

![[写真] チュオン村祭りのユニークな民俗遊び](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/cff805a06fdd443b9474c017f98075a4)

コメント (0)