Google は、スマートフォンと高性能ワークステーションの両方で実行可能な Gemma 3 という新しい AI モデルをリリースしました。

人工知能(AI)モデル「ジェマ」の2つのバージョンをリリースしてから1年以上が経ち、

|

| Google、高性能AIモデル「Gemma 3」を発表 |

この AI モデルの新しいアップグレードであるバージョン Gemma 3 をリリースし続けました。

Gemma 3 には、10 億、40 億、120 億、270 億のパラメータを含む 4 つのバリエーションがあります。 Google によれば、これは世界最高の単一アクセラレーション モデルであり、大規模なコンピューター クラスターを必要とせず、単一の GPU または TPU で実行できます。

理論的には、これにより、Google の Gemma 3 は、Gemini Nano モデルがモバイル デバイス上でローカルに実行されるのと同様に、Pixel スマートフォンの Tensor Processing Unit (TPU) 上で直接実行できるようになります。

Gemini AI モデル ラインと比較すると、Gemma 3 の最大の利点はオープン ソースであることです。これにより、開発者はモバイル アプリケーションやデスクトップ ソフトウェアをオンデマンドで簡単にカスタマイズ、パッケージ化、展開できます。さらに、Gemma は 140 を超える言語をサポートしており、そのうち 35 言語はすでにトレーニング パッケージとして利用可能です。

|

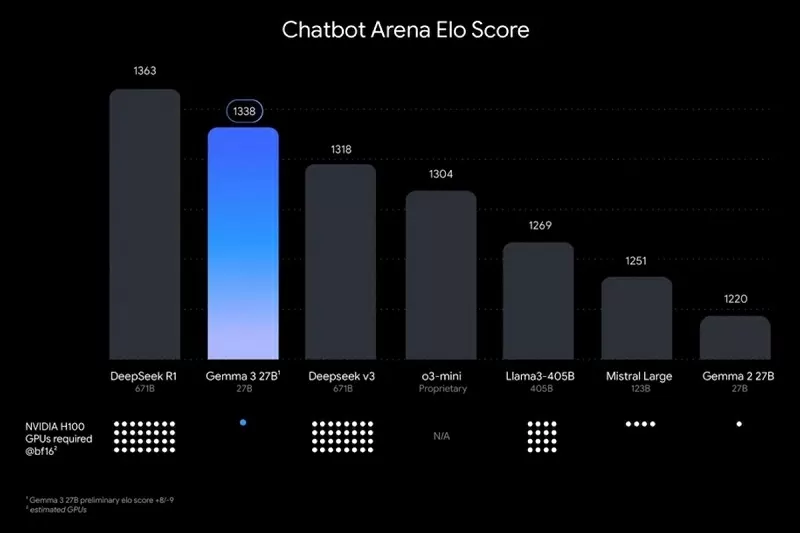

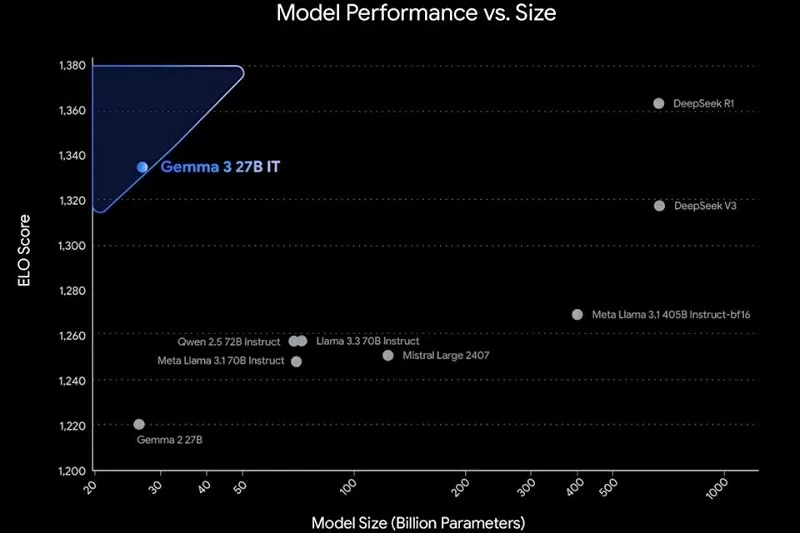

| Gemma 3(270億パラメータ版)と他のAIモデルのパフォーマンスを比較 |

パフォーマンスの面では、Google は、Gemma 3 が DeepSeek V3、OpenAI o3-mini、Meta の Llama-405B バリアントなど、他の多くの一般的なオープンソース AI モデルよりも優れていると自信を持って主張しています。

Google の Gemma 3 AI モデルでは、テキスト、画像、ビデオなどの処理も可能で、ユーザーの説明に従って画像やビデオ コンテンツを生成するなど、オンデマンドの応答を提供します。

|

| Gemma 3(270億パラメータ版)と他のAIモデルのパフォーマンスを比較 |

Google の最新のオープンソース AI モデルは、ローカルに展開することも、Vertex AI などの同社のクラウド サービスを通じて展開することもできます。 Gemma 3 は現在、Google AI Studio のほか、Hugging Face、Ollama、Kaggle などのサードパーティ プラットフォームでも利用できます。

Google の第 3 世代オープンソース モデルは、企業が大規模言語モデル (LLM) と小規模言語モデル (SLM) の両方を並行して開発するという業界のトレンドの一部です。 Google のライバルである Microsoft も、オープンソースのマイクロ言語モデル Phi で同様の戦略を追求しています。

Gemma や Phi などの小規模な言語モデルはリソース効率が高く評価されており、スマートフォンなどのデバイスで実行するのに最適です。さらに、レイテンシが低いため、モバイル アプリケーションに特に適しています。

[広告2]

ソース

コメント (0)