Googleは3月12日、スマートフォンと高性能ワークステーションの両方で実行できる第3世代のオープンソースAIモデル、Gemma 3を発表した。

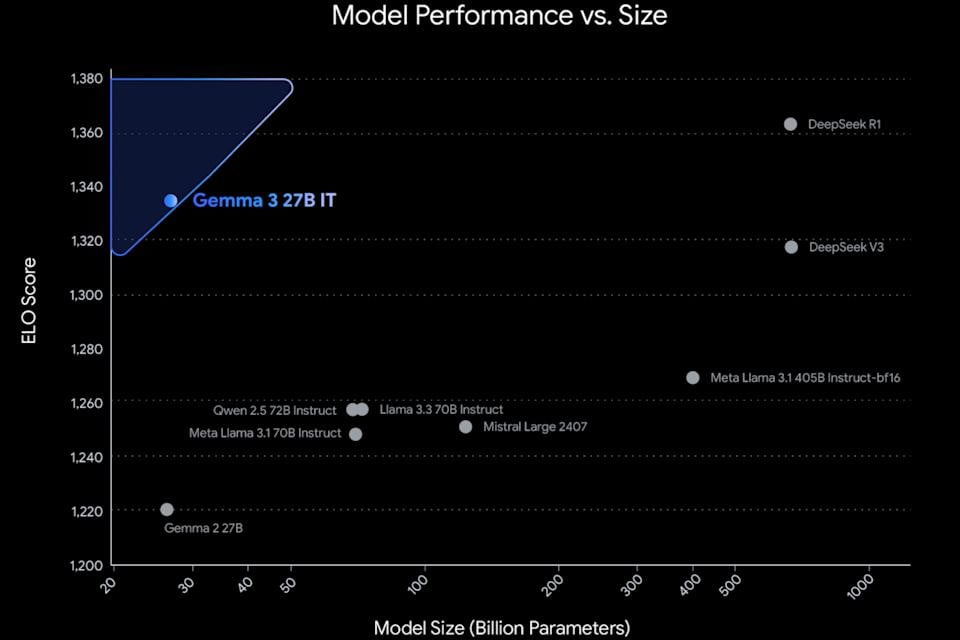

Gemma 3 は、10 億、40 億、120 億、270 億のパラメータを含む 4 つのバリエーションでリリースされます。 Google によれば、これは世界最高のシングルスピード モデルであり、大規模なコンピューター クラスターを必要とせず、単一の GPU または TPU で実行できます。

理論的には、これにより、Gemini Nano モデルがモバイル デバイス上でローカルに実行されるのと同様に、Gemma 3 を Pixel スマートフォンの Tensor Processing Unit (TPU) 上で直接実行できるようになります。

Gemini AI モデル シリーズと比較すると、Gemma 3 の最大の利点はオープン ソースであることです。これにより、開発者はモバイル アプリケーションやデスクトップ ソフトウェアをオンデマンドで簡単にカスタマイズ、パッケージ化、展開できます。さらに、Gemma は 140 を超える言語をサポートしており、そのうち 35 言語はすでにトレーニング パッケージとして利用可能です。

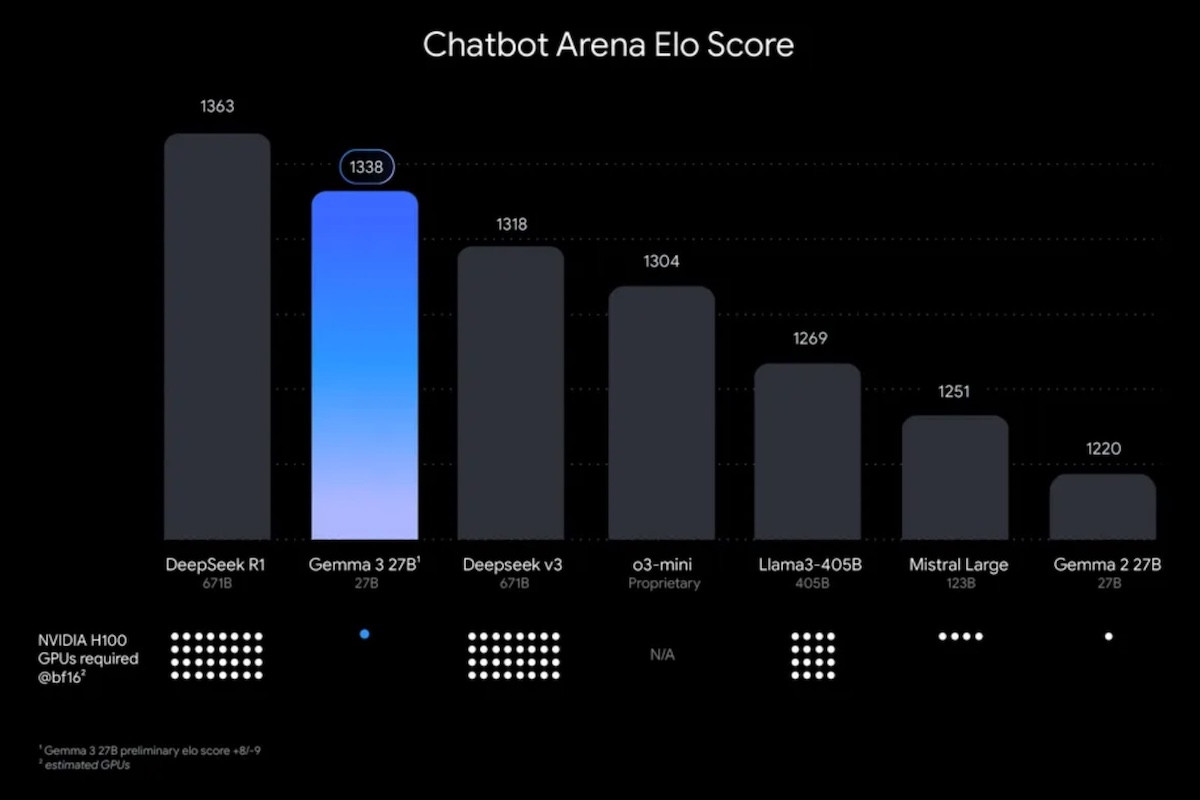

最新の Gemini 2.0 モデルと同様に、Gemma 3 はテキスト、画像、ビデオを処理できます。パフォーマンスの面では、Gemma 3 は、DeepSeek V3、OpenAI o3-mini、Meta の Llama-405B バリアントなど、他の多くの一般的なオープンソース AI モデルよりも優れています。

200ページの本に相当する内容

Gemma 3 は最大 128,000 トークンのコンテキスト ウィンドウをサポートします。これは 200 ページの本のデータの量に相当します。一方、比較すると、Gemini 2.0 Flash Lite モデルには最大 100 万トークンのコンテキスト ウィンドウがあります。

Gemma 3 は、Gemini が Gmail や Docs などのプラットフォーム間での作業をシームレスにサポートするのと同様に、外部データセットと対話し、自動エージェントとして機能します。

Google の最新のオープンソース AI モデルは、ローカルに展開することも、Vertex AI などの同社のクラウド サービスを通じて展開することもできます。 Gemma 3 は現在、Google AI Studio のほか、Hugging Face、Ollama、Kaggle などのサードパーティ プラットフォームでも利用できます。

Google の第 3 世代オープンソース モデルは、企業が大規模言語モデル (LLM) と小規模言語モデル (SLM) の両方を並行して開発するという業界のトレンドの一部です。 Google のライバルである Microsoft も、オープンソースの小規模言語モデル Phi ファミリーで同様の戦略を追求している。

Gemma や Phi などの小規模な言語モデルはリソース効率が高く評価されており、スマートフォンなどのデバイスで実行するのに最適です。さらに、レイテンシが低いため、モバイル アプリケーションに特に適しています。

[広告2]

出典: https://vietnamnet.vn/google-ra-mat-gemma-3-mo-hinh-ai-ma-nguon-mo-voi-hieu-suat-vuot-troi-2380097.html

コメント (0)