Selon des sources de Tech.co , alors que la controverse autour du licenciement du PDG Sam Altman puis de son retour à OpenAI faisait rage, l'une des rumeurs concernait une lettre envoyée par les chercheurs de l'entreprise au conseil d'administration, exprimant des inquiétudes concernant le modèle de superintelligence de l'IA en cours de développement qui pourrait potentiellement constituer une menace pour l'humanité.

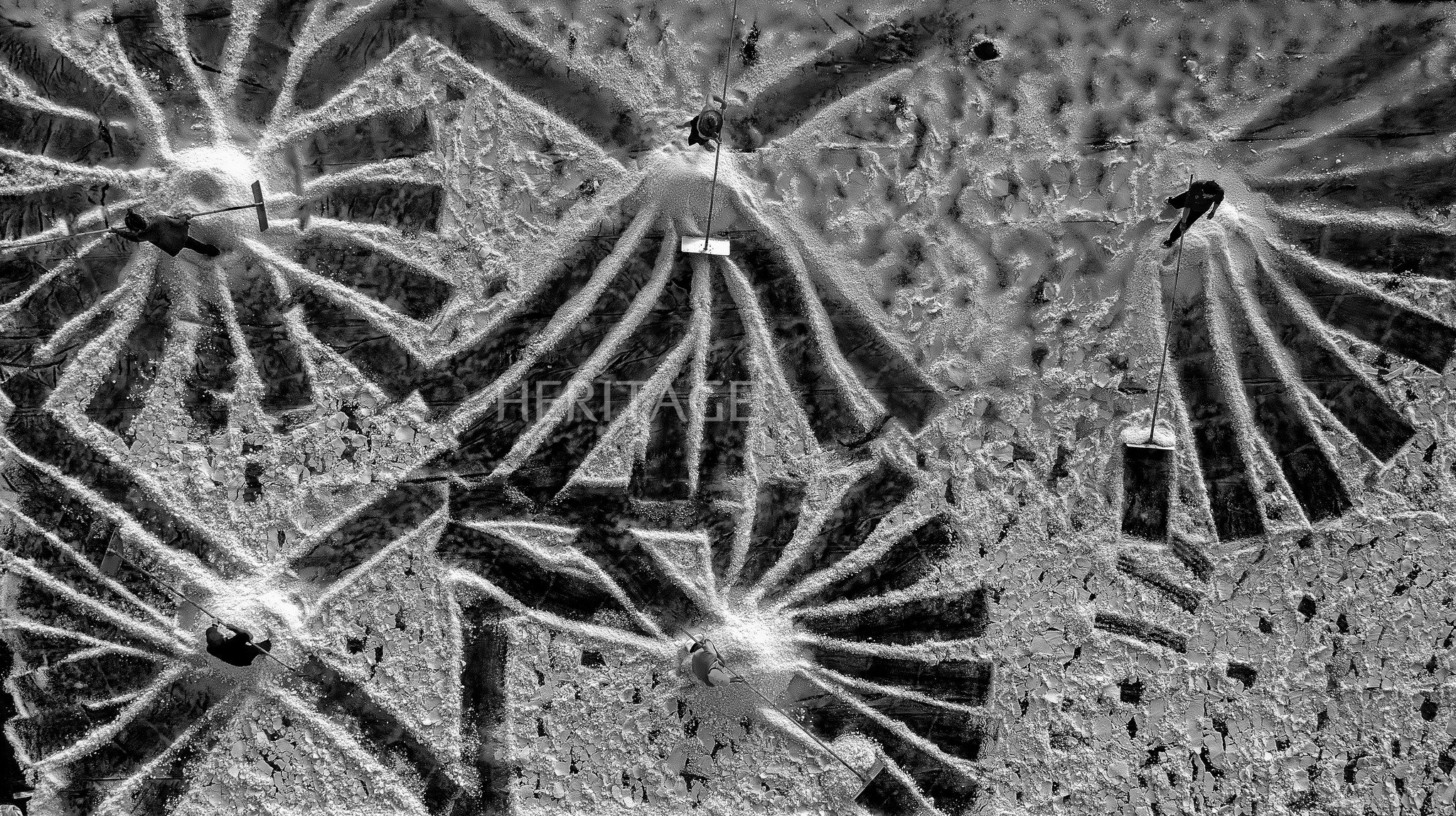

(Illustration)

Projet Q*

Le modèle, connu en interne sous le nom de Projet Q* (prononcé Q-star), est censé représenter une avancée majeure dans la quête d'OpenAI en matière d'intelligence artificielle générale (AGI) - une branche hautement autonome de la superintelligence capable d'apprentissage cumulatif et de surpasser les humains dans la plupart des tâches.

Q* pourrait marquer un grand pas en avant dans l'intelligence artificielle en améliorant radicalement les capacités de raisonnement de l'IA et en rapprochant OpenAI d'une percée majeure dans le développement de l'AGI, selon des personnes proches du dossier.

Contrairement aux modèles d’IA actuels, qui se concentrent sur la capacité à générer des réponses basées sur des informations précédemment apprises, l’AGI est un système autonome qui peut appliquer la « raison » aux décisions, lui conférant des capacités de résolution de problèmes de niveau humain.

Bien que l’AGI ne soit pas encore pleinement réalisée, de nombreux experts pensent que la technologie aura également la capacité d’apprendre de manière cumulative, une autre caractéristique qui donne aux humains la possibilité d’améliorer leurs capacités.

Certaines sources affirment que Q* - le projet d'OpenAI - a été en mesure de démontrer les propriétés ci-dessus lors de la résolution de problèmes. De plus, grâce à l’énorme puissance de calcul du modèle, Q* a pu surpasser les élèves de l’école primaire, démontrant des capacités de raisonnement et des capacités cognitives bien au-delà des capacités de la technologie d’IA actuelle.

On ne sait pas exactement depuis combien de temps Q* est en développement et quelles pourraient être ses applications, mais OpenAI a informé les employés et les membres du conseil d'administration du projet avant que le scandale du personnel n'éclate.

Préoccupations éthiques

Alors que le PDG d'OpenAI, Sam Altman, est convaincu que la technologie AGI sera le moteur de l'innovation, certains chercheurs ont rapidement souligné les dangers potentiels du projet.

Dans une lettre adressée au conseil d’administration, les chercheurs ont mis en garde contre les dangers potentiels de ce puissant algorithme pour l’humanité. Les préoccupations spécifiques en matière d’éthique de l’IA décrites dans la lettre n’ont pas été divulguées, mais les avertissements ont été suffisants pour justifier la décision du conseil d’administration de licencier Altman.

Entre-temps, la raison initiale invoquée pour le licenciement d’Altman était que le PDG « communiquait mal ». Peu de temps après, il a trouvé un nouveau poste chez Microsoft. Cette décision a incité 700 des 770 employés d'OpenAI à menacer de faire la même chose si le PDG n'était pas réintégré.

Alors que l'entreprise était en danger d'effondrement, le conseil d'administration d'OpenAI a été contraint de réintégrer Altman à son poste de direction, ce qui a également conduit à une refonte majeure de l'équipe de direction de l'entreprise et a mis en évidence de profondes divisions au sein de sa direction.

Maintenant qu’Altman est de retour au pouvoir et que le Projet Q* est susceptible d’obtenir à nouveau le feu vert, cela soulève de nouvelles questions.

Dans quelle mesure le projet Q* est-il réaliste ?

Bien que les jours tumultueux chez OpenAI aient mis le concept d'AGI sous les projecteurs, ce n'est pas la première fois qu'Altman mentionne cette technologie.

En septembre, l’entrepreneur de la Silicon Valley s’est retrouvé dans une situation délicate après avoir comparé AGI à « un être humain moyen que vous pourriez embaucher comme collègue ». Il a ensuite confirmé les commentaires qu’il avait faits l’année dernière sur la façon dont cette IA pourrait « faire tout ce que vous pouvez faire avec un collègue distant », y compris apprendre à devenir un bon médecin et un bon programmeur.

Bien que comparer l’AGI à l’intelligence d’un « humain moyen » n’ait rien de nouveau, l’utilisation de cette expression par Altman a été jugée « odieuse » par Henry Shevlin, éthicien de l’IA et professeur à l’Université de Cambridge, alors que les inquiétudes concernant l’impact de l’IA sur la sécurité de l’emploi s’intensifient.

Les avancées potentielles dans le domaine de l’AGI suscitent également l’inquiétude d’autres chercheurs : la technologie se développe à une vitesse telle que les humains ne peuvent pas pleinement comprendre son impact.

OpenAI estime que les résultats positifs de l'AGI valent la peine d'être essayés dans ce « champ de mines » risqué. Cependant, alors que l’entreprise continue d’avancer dans cette direction, nombreux sont ceux qui craignent qu’Altman privilégie le succès commercial au détriment des intérêts des utilisateurs et de la société.

Phuong Anh (Source : Tech.co, The Guardian)

Source

Comment (0)