Исследование Google DeepMind показывает, что создание изображений, видео и аудио, имитирующих людей, встречается почти в два раза чаще, чем распространение дезинформации с использованием таких инструментов, как чат-боты на основе искусственного интеллекта.

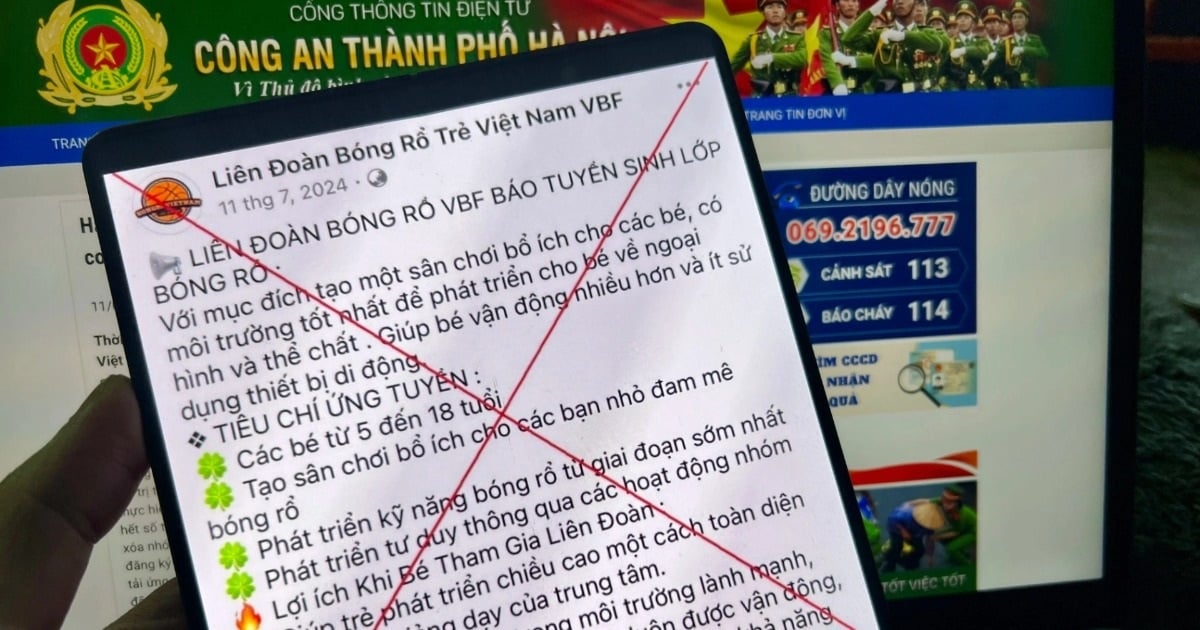

Анализ показал, что наиболее распространенной целью злоупотреблений искусственным интеллектом является формирование или влияние на общественное мнение. Эта цифра составляет 27% использования, что вызывает опасения относительно того, как дипфейки могут повлиять на выборы по всему миру в этом году.

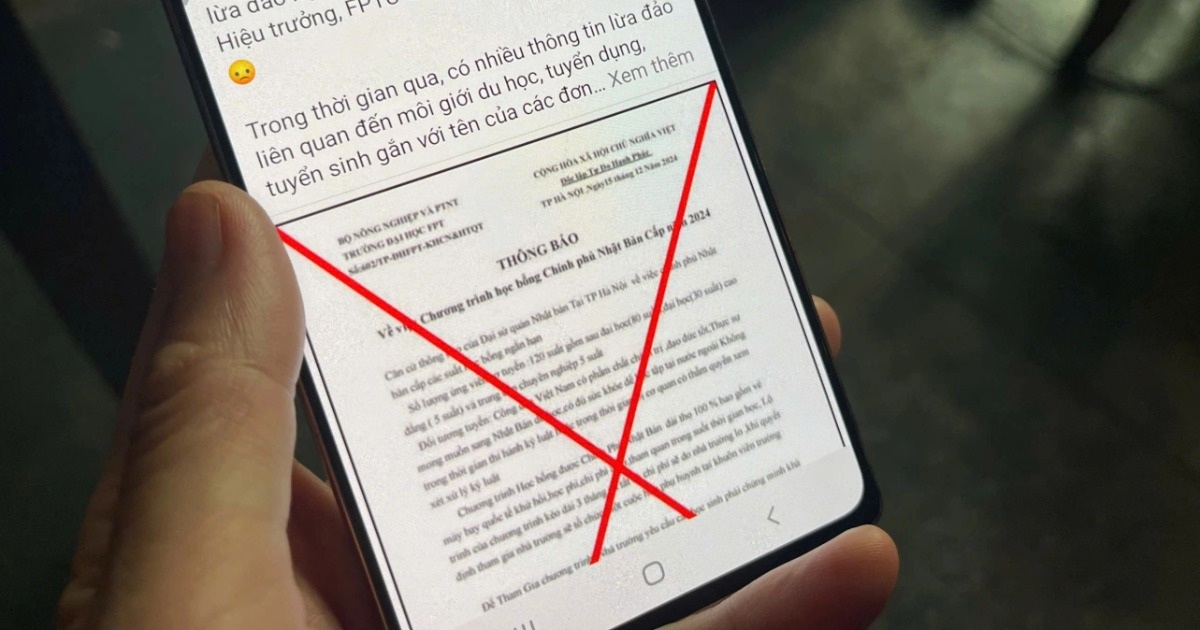

В преддверии всеобщих выборов в TikTok и Instagram появились фейковые изображения премьер-министра Великобритании Риши Сунака. Фото: АФП

За последние месяцы в TikTok, X и Instagram появились дипфейки с изображением канцлера Великобритании Риши Сунака и других мировых лидеров. На следующей неделе британские избиратели пойдут на всеобщие выборы.

Существуют опасения, что, несмотря на усилия социальных сетей по маркировке или удалению такого контента, аудитория может не распознать его как фейковый и что его распространение может повлиять на избирателей.

Арди Джанджева, научный сотрудник Института Алана Тьюринга, назвала выводы статьи «особенно актуальными», поскольку общедоступная информация, генерируемая ИИ, может «искажать наше общее понимание социально-политической реальности».

«Даже если мы не уверены в влиянии дипфейков на поведение избирателей, это искажение может быть трудно обнаружить в краткосрочной перспективе и представляет долгосрочные риски для демократии», — добавила Джанджева.

«Существует много опасений по поводу довольно сложных кибератак, которые создаются с использованием этих инструментов», — говорит исследователь Нахема Маршал, ведущий автор исследования в Google DeepMind.

Исследователи из Google DeepMind и Jigsaw проанализировали около 200 случаев неправомерного использования ИИ в период с января 2023 года по март 2024 года, взятых из социальных сетей X и Reddit, а также из онлайн-блогов и сообщений СМИ о неправомерном использовании.

Второй по распространенности мотивацией злоупотреблений является монетизация, которая включает в себя создание обнаженных фотографий реальных людей или использование ИИ для создания различного контента, например фейковых новостных статей. В большинстве сценариев используются доступные инструменты, «требующие минимальных технических знаний», а это значит, что многие злоумышленники могут злоупотреблять креативным ИИ.

Нгок Ань (по данным FT)

Источник: https://www.congluan.vn/nghien-cuu-deepfake-chinh-tri-dung-dau-trong-danh-sach-su-dung-ai-doc-hai-post300851.html

![[Фото] Премьер-министр Фам Минь Чинь председательствует на правительственной конференции с местными властями по вопросам экономического роста](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/2/21/f34583484f2643a2a2b72168a0d64baa)

Комментарий (0)