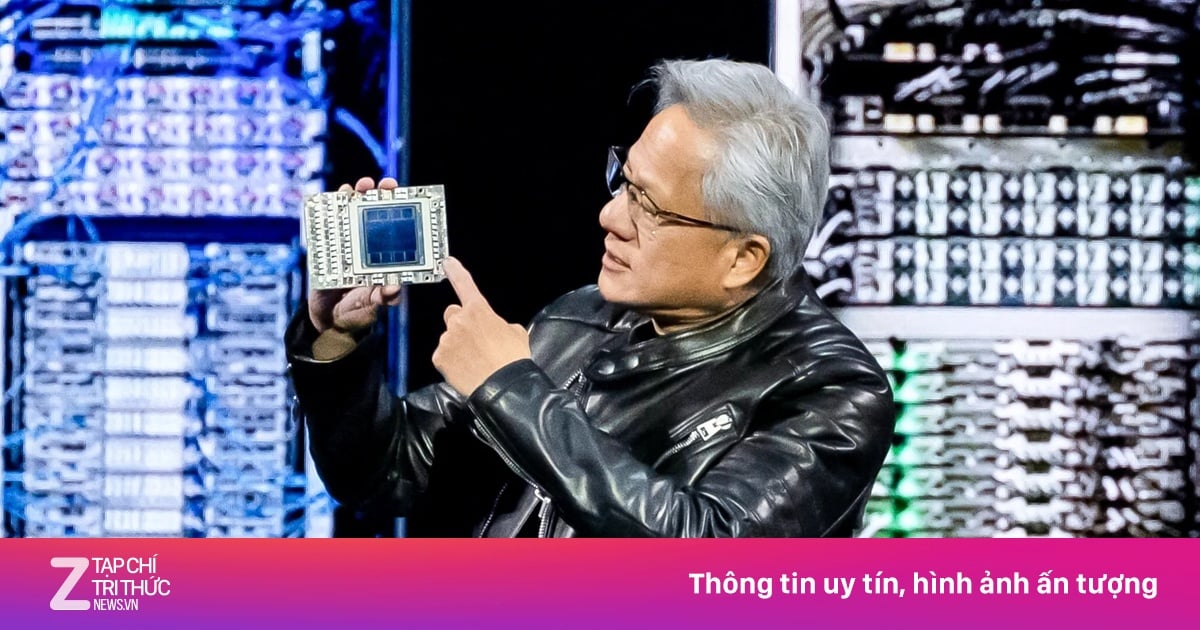

En la conferencia GTC 2025 celebrada en San José (EE. UU.), Asus anunció una versión mejorada del sistema de servidor AI POD. Con la integración de la plataforma Nvidia GB300 NVL72, el sistema está equipado con 72 GPU Blackwell Ultra y 36 CPU Grace, lo que proporciona un mayor rendimiento en aplicaciones de inteligencia artificial (IA).

Asus presenta el sistema AI POD de próxima generación en GTC 2025, con GPU Nvidia Blackwell y tecnología de refrigeración líquida

El nuevo AI POD está diseñado en un modelo a escala de rack, lo que permite una expansión flexible y admite hasta 40 TB de memoria de alta velocidad por rack. Además, el sistema integra la tecnología de redes Ethernet NVIDIA Quantum-X800 InfiniBand y Spectrum-X, lo que ayuda a mejorar las velocidades de transmisión de datos entre clústeres de servidores. También se aplica refrigeración líquida para garantizar un funcionamiento estable, especialmente en tareas computacionalmente intensivas, como el entrenamiento de modelos de lenguaje grandes (LLM).

Además del AI POD, Asus también lanzó varias nuevas líneas de servidores AI en los ecosistemas Blackwell y HGX, incluidos los modelos XA NB3I-E12, ESC NB8-E11 y ESC N8-E11V. Estos productos admiten una amplia gama de dominios, como ciencia de datos, finanzas, atención médica e inteligencia artificial general. Según Asus, ampliar la cartera de servidores de inteligencia artificial ofrece a las empresas más opciones para adaptarse a sus necesidades específicas.

Asus afirma que la nueva generación AI POD puede satisfacer las necesidades de grandes centros de datos y organizaciones de investigación de IA. La estrecha colaboración con Nvidia en este proyecto ayuda a optimizar el desarrollo y las operaciones de IA a escala.

[anuncio_2]

Fuente: https://thanhnien.vn/asus-ra-mat-ai-pod-su-dung-chip-blackwell-gb300-tai-gtc-2025-18525031920230298.htm

![[Foto] Resumen del taller "Eliminando las deficiencias políticas para promover el papel de la economía privada en la economía vietnamita"](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/d1c58c1df227467b8b33d9230d4a7342)

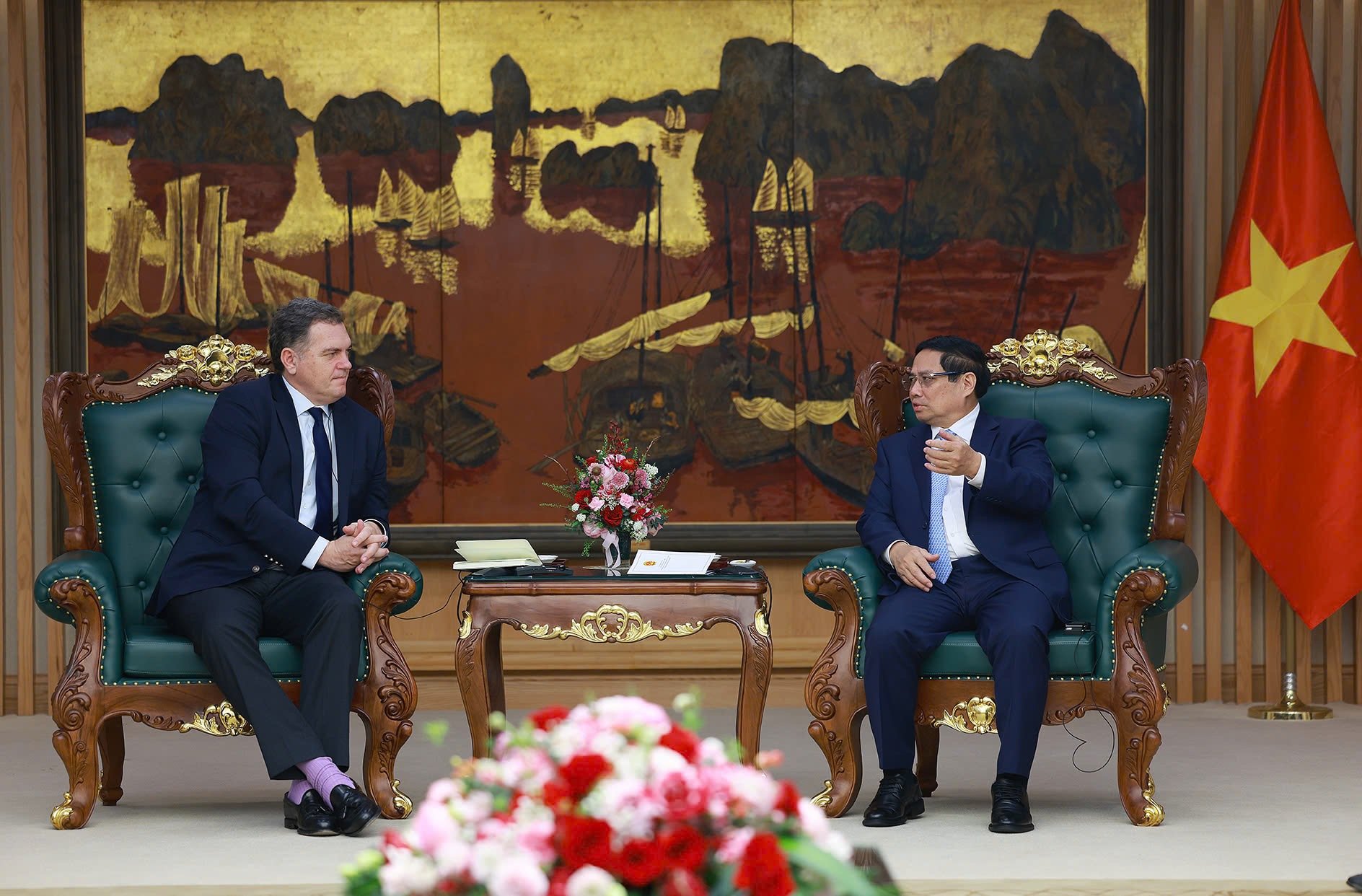

![[Foto] El primer ministro Pham Minh Chinh recibe al ministro francés encargado del Transporte](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/aa649691f85546d59c3624b1821ab6e2)

![[Foto] El primer ministro Pham Minh Chinh recibe al jefe de la República de Tartaristán, Federación de Rusia](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/7877cb55fc794acdb7925c4cf893c5a1)

![[Foto] Conozca a los pilotos del Escuadrón Victoria](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/fd30103acbd744b89568ca707378d532)

Kommentar (0)