Eine Gruppe führender internationaler Experten traf sich letzte Woche in Peking und identifizierte dort „rote Linien“ in der KI-Entwicklung, darunter die Herstellung von Biowaffen und die Durchführung von Cyberangriffen.

In einer Erklärung wenige Tage nach dem Treffen warnten die Wissenschaftler, dass ein gemeinsamer Ansatz zur KI-Sicherheit erforderlich sei, um „katastrophale oder sogar existenzielle Risiken für die Menschheit zu unseren Lebzeiten“ zu verhindern.

„Auf dem Höhepunkt des Kalten Krieges trug die internationale Zusammenarbeit zwischen Regierungen und Wissenschaftlern dazu bei, eine nukleare Katastrophe zu verhindern. Die Menschheit muss erneut zusammenarbeiten, um eine Katastrophe zu verhindern, die durch eine beispiellose Technologie entstehen könnte“, heißt es in der Erklärung.

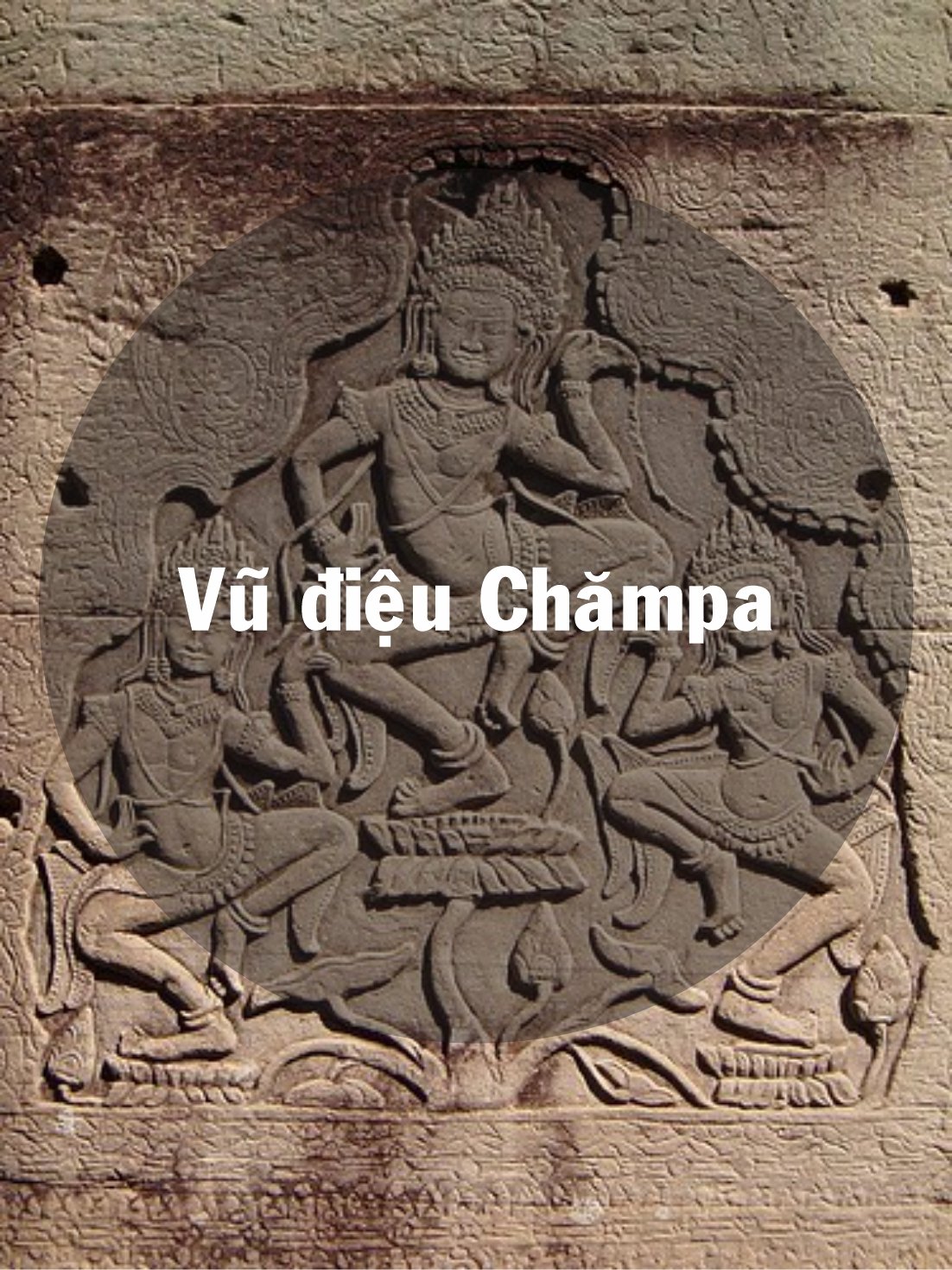

Experten haben beim International Dialogue on AI Safety in Peking „rote Linien“ in der KI-Entwicklung identifiziert. Foto: FT

Zu den Unterzeichnern gehören Geoffrey Hinton und Yoshua Bengio, die oft als die „Väter“ der KI bezeichnet werden; Stuart Russell, Professor für Informatik an der University of California; und Andrew Yao, einer der bekanntesten Informatiker Chinas.

Die Erklärung erfolgt im Anschluss an den International AI Safety Dialogue in Peking letzte Woche, ein Treffen, an dem chinesische Regierungsvertreter teilnahmen, um ihre Zustimmung zu dem Forum und seinen Ergebnissen auszudrücken.

US-Präsident Joe Biden und der chinesische Präsident Xi Jinping trafen sich im vergangenen November und besprachen die Sicherheit von KI. Sie einigten sich darauf, einen Dialog zu diesem Thema aufzunehmen. Die weltweit führenden KI-Unternehmen haben sich in den letzten Monaten auch privat mit chinesischen KI-Experten getroffen.

Im November 2023 einigten sich 28 Länder, darunter China, und führende KI-Unternehmen auf dem KI-Sicherheitsgipfel des britischen Schatzkanzlers Rishi Sunak auf eine umfassende Verpflichtung zur Zusammenarbeit bei der Bewältigung der existenziellen Risiken, die von fortschrittlicher KI ausgehen.

In der vergangenen Woche diskutierten Experten in Peking über die Gefahren, die mit der Entwicklung einer „künstlichen allgemeinen Intelligenz“ (AGI) einhergehen, also von KI-Systemen, die dem Menschen ebenbürtig oder ihm überlegen sind.

„Der Kernpunkt der Diskussion waren die roten Linien, die kein leistungsstarkes KI-System überschreiten sollte und die Regierungen weltweit bei der Entwicklung und dem Einsatz von KI setzen sollten“, sagte Bengio.

Diese roten Linien würden sicherstellen, dass „kein KI-System sich ohne ausdrückliche menschliche Zustimmung und Unterstützung replizieren oder verbessern kann“ oder „Maßnahmen ergreifen kann, die seine Macht und seinen Einfluss übermäßig vergrößern“.

Die Wissenschaftler fügten hinzu, dass kein System „die Fähigkeit von Akteuren, Massenvernichtungswaffen zu entwickeln, die Konvention zum Verbot biologischer oder chemischer Waffen zu verletzen, erheblich verbessern“ oder in der Lage sein würde, „automatisch Cyberangriffe durchzuführen, die zu schweren finanziellen Verlusten oder vergleichbaren Schäden führen“.

Hoang Hai (laut FT)

[Anzeige_2]

Quelle

Kommentar (0)