BGRによると、新たな研究レポートで、AI(人工知能)自体を使用して、Google の Gemini を含む他の高度な AI モデルを標的とした非常に効果的なプロンプト インジェクション攻撃を自動的に作成するという「Fun-Tuning」と呼ばれる驚くべき手法が発表されたとのことです。

この方法により、AIの「クラッキング」がこれまで以上に高速、安価、容易になり、AI関連のサイバーセキュリティ戦争の新たな激化を示すことになる。

悪者がAIを利用してAIを破壊する危険性

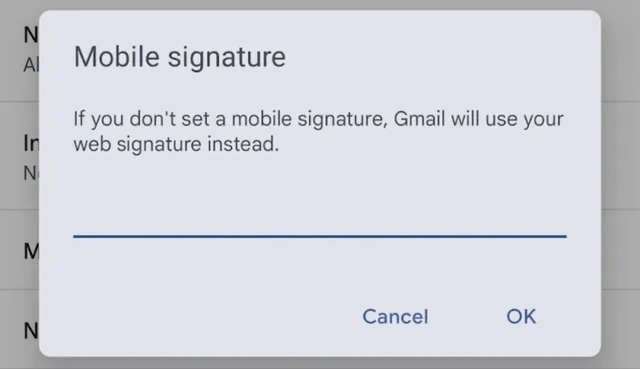

プロンプト インジェクションは、攻撃者が AI モデルの入力データに悪意のある命令を密かに挿入する手法です (ソース コード内のコメント、Web 上の隠しテキストなど)。目的は、AI を「騙して」、事前にプログラムされた安全ルールを回避させ、機密データの漏洩、虚偽の情報の提供、その他の危険な動作の実行などの深刻な結果をもたらすことです。

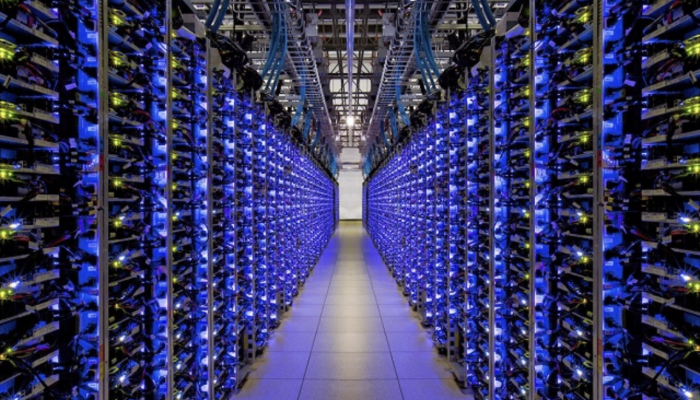

ハッカーはAIを利用してAIを攻撃している

写真: LINKEDIN スクリーンショット

以前は、特に Gemini や GPT-4 などの「クローズド」モデルでこれらの攻撃を正常に実行するには、多くの複雑で時間のかかる手動テストが必要になることが多かった。

しかし、Fun-Tuning はゲームを完全に変えました。複数の大学の研究者チームによって開発されたこの手法は、Google が Gemini ユーザーに無料で提供しているのと同じ、微調整されたアプリケーション プログラミング インターフェース (API) を巧みに利用しています。

Fun-Tuning は、チューニング中の Gemini モデルの微妙な反応 (データ内のエラーに対する反応など) を分析することで、悪意のあるステートメントを隠すために最も効果的な「プレフィックス」と「サフィックス」を自動的に決定できます。これにより、AI が攻撃者の悪意ある意図に従う可能性が大幅に高まります。

テスト結果によると、Fun-Tuning は Gemini の一部のバージョンで最大 82% の成功率を達成しており、これは従来の攻撃方法の 30% 未満を上回る数字です。

Fun-Tuning の危険性をさらに高めているのは、実装コストが非常に低いことです。 Google の調整 API は無料で利用できるため、効果的な攻撃を作成するための計算コストはわずか 10 ドルになる可能性があります。さらに、研究者らは、あるバージョンの Gemini 向けに設計された攻撃が他のバージョンにも簡単に適用され、広範囲にわたる攻撃のリスクが生じる可能性があることを発見しました。

Google は Fun-Tuning 技術がもたらす脅威を認識していることを確認したが、調整 API の動作方法を変更するかどうかについてはまだコメントしていない。チームはまた、チューニングプロセスから Fun-Tuning が悪用する情報を削除することの防御上の難しさを指摘し、正当な開発者にとって API の有用性が低下するとしています。それどころか、そのままにしておけば、悪者が悪用する踏み台となり続けることになるでしょう。

Fun-Tuning の出現は、サイバー空間における対立が新たな、より複雑な段階に入ったことを明確に警告しています。 AI は現在、悪意のある行為者の標的であるだけでなく、ツールや武器としても利用されています。

[広告2]

出典: https://thanhnien.vn/hacker-dung-ai-de-tan-cong-gemini-cua-google-18525033010473121.htm

コメント (0)