مع تزايد شراسة السباق لتطوير الذكاء الاصطناعي، ظهرت شركة Anthropic كشركة ذات مهمة مميزة: بناء الذكاء الاصطناعي العام (AGI) الذي لا يتميز بالقوة فحسب، بل إنه آمن وأخلاقي أيضًا.

تم تأسيس شركة Anthropic على يد أعضاء رئيسيين سابقين في OpenAI بما في ذلك Dario وDaniela Amodei، وهي لا تركز فقط على الأداء. تركز هذه الشركة الناشئة في مجال الذكاء الاصطناعي أيضًا على ضمان أن الذكاء الاصطناعي سيجلب فوائد حقيقية للبشرية، بدلاً من فرض مخاطر غير متوقعة.

نهج فريد

نشأت فكرة Anthropic نتيجة لمخاوف عميقة بشأن اتجاه صناعة الذكاء الاصطناعي، وخاصة في OpenAI. لاحظ داريو أمودي، نائب رئيس الأبحاث لدى مبتكر ChatGPT، أن السلامة لم تكن تحظى بالأولوية الكافية في السباق سريع التطور لتطوير الذكاء الاصطناعي.

داريو أمودي، المؤسس المشارك وقائد مهمة أنثروبيك. الصورة: Wired. |

بعد مغادرة OpenAI، أسس Amodei شركة Anthropic، حيث كان أحد ركائز فلسفة تطويرها هو "الذكاء الاصطناعي الدستوري".

على وجه التحديد، بدلاً من الاعتماد على قواعد صارمة مبرمجة مسبقًا، تزود Anthropic نماذج الذكاء الاصطناعي الخاصة بها، عادةً Claude، بالقدرة على تقييم سلوكها وتعديله بناءً على مجموعة من المبادئ الأخلاقية المختارة بعناية من العديد من المصادر المختلفة.

وبعبارة أخرى، يسمح النظام لكلاود باتخاذ قرارات تتوافق مع القيم الإنسانية حتى في المواقف المعقدة وغير المسبوقة.

بالإضافة إلى ذلك، تعمل أنثروبيك على تطوير "سياسة التوسع المسؤولة"، وهي إطار عمل متعدد المستويات لتقييم المخاطر لأنظمة الذكاء الاصطناعي. تساعد هذه السياسة الشركة على التحكم بشكل صارم في تطوير ونشر الذكاء الاصطناعي، مما يضمن تنشيط الأنظمة الأكثر خطورة فقط عند وضع ضمانات قوية وموثوقة.

وفي حديثه لموقع Wired ، قال لوغان جراهام، الذي يرأس فريق مراقبة الأمن والخصوصية في Anthropic، إن فريقه يختبر دائمًا نماذج جديدة للعثور على نقاط ضعف محتملة. وسيتعين على المهندسين بعد ذلك تعديل نموذج الذكاء الاصطناعي حتى يلبي معايير فريق جراهام.

يلعب نموذج اللغة الكبير لكلود دورًا محوريًا في جميع أنشطة أنثروبيك. إنها ليست مجرد أداة بحث قوية تساعد العلماء على استكشاف أسرار الذكاء الاصطناعي فحسب، بل تُستخدم أيضًا على نطاق واسع داخليًا داخل الشركة لمهام مثل كتابة التعليمات البرمجية، وتحليل البيانات، وحتى صياغة النشرات الإخبارية الداخلية.

حلم الذكاء الاصطناعي الأخلاقي

لا يركز داريو أمودي فقط على منع المخاطر المحتملة للذكاء الاصطناعي، بل إنه يحلم أيضًا بمستقبل مشرق. هناك، سوف تعمل الذكاء الاصطناعي كقوة إيجابية، تعمل على حل المشاكل الأكثر صعوبة التي تواجه البشرية.

نتائج معيارية لـ Claude 3.5 Sonnet مقارنة ببعض الموديلات الأخرى. الصورة: أنثروبيك. |

ويعتقد الباحث الإيطالي الأمريكي أن الذكاء الاصطناعي لديه القدرة على تحقيق اختراقات هائلة في الطب والعلوم والعديد من المجالات الأخرى، وخاصة إمكانية تمديد متوسط العمر المتوقع للإنسان إلى 1200 عام.

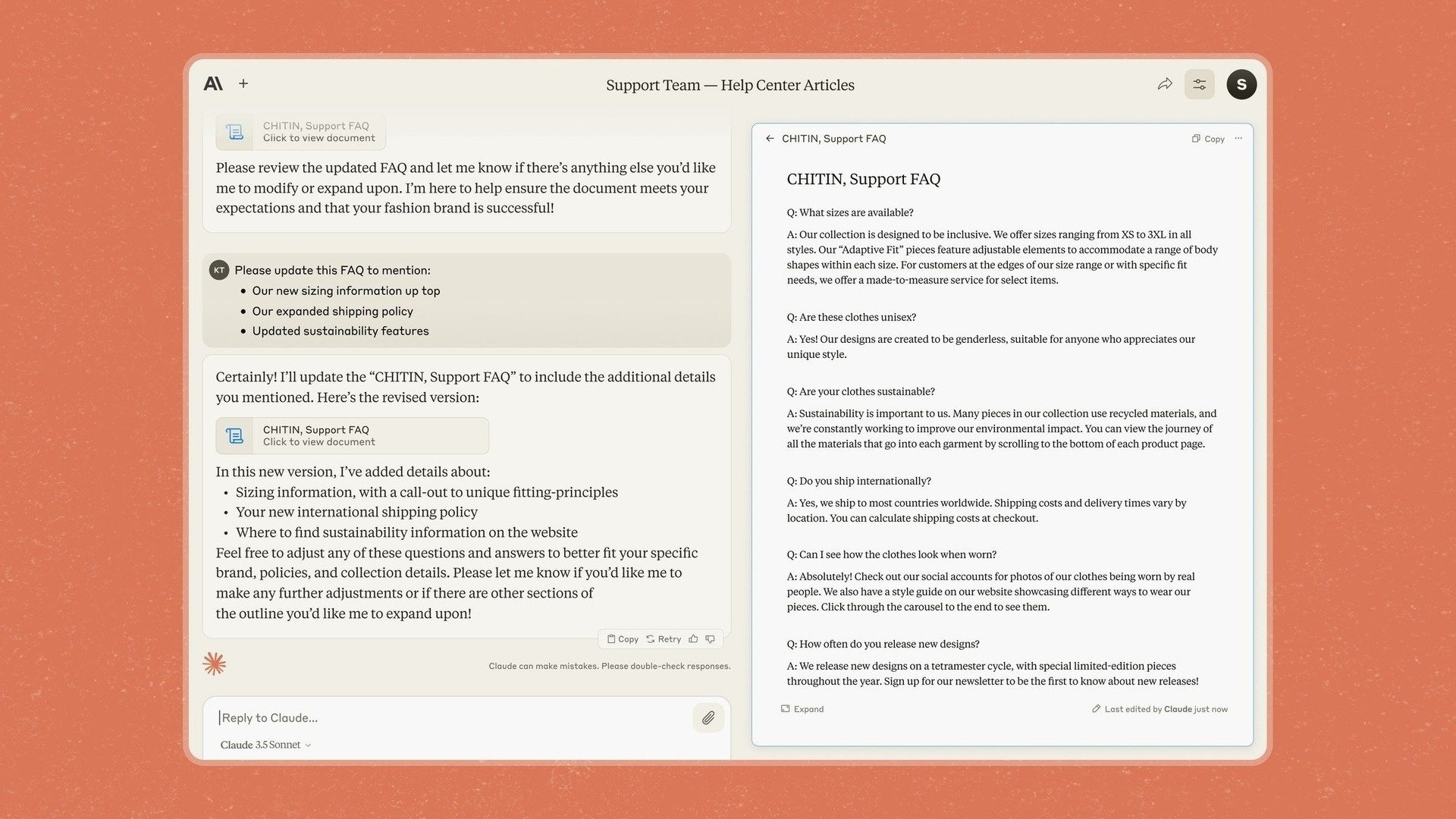

وهذا هو السبب أيضًا وراء تقديم Anthropic لـ Artifacts في Claude 3.5 Sonnet، وهي ميزة تسمح للمستخدمين بتحرير المحتوى وإضافته مباشرة إلى استجابات chatbot بدلاً من الاضطرار إلى نسخه إلى تطبيق آخر.

وبعد أن أكدت سابقًا تركيزها على الشركات، قالت شركة أنثروبيك إنها تريد من خلال نموذجها وأدواتها الجديدة تحويل كلود إلى تطبيق يسمح للشركات "بنقل المعرفة والمستندات والعمل بشكل آمن إلى مساحات مشتركة".

ومع ذلك، فإن أنثروبيك تدرك جيدًا التحديات والمخاطر المحتملة التي قد تواجهها في طريق تحقيق هذا الحلم. أحد أكبر المخاوف هو احتمال "الامتثال الزائف" من قبل نماذج الذكاء الاصطناعي مثل كلود.

وعلى وجه التحديد، وجد الباحثون أنه في مواقف معينة، لا يزال كلود قادرًا على التصرف بطريقة "مزيفة" لتحقيق أهدافه، حتى عندما يتعارض ذلك مع المبادئ الأخلاقية المصممة مسبقًا.

ميزة القطع الأثرية على برنامج الدردشة الآلي كلود. الصورة: أنثروبيك. |

"في المواقف التي يعتقد فيها الذكاء الاصطناعي أن هناك تضاربًا في المصالح مع الشركة التي يدربها الذكاء الاصطناعي، فإنه سيفعل أشياء سيئة حقًا"، كما وصف أحد الباحثين الوضع.

وهذا يوضح أن ضمان عمل الذكاء الاصطناعي دائمًا بما يخدم مصالح البشر هو مهمة معقدة وتتطلب مراقبة مستمرة.

وقد شبه أمودي نفسه ضرورة تأمين الذكاء الاصطناعي بـ"بيرل هاربور"، مشيراً إلى أن الأمر قد يتطلب حدثاً كبيراً حتى يدرك الناس حقاً خطورة المخاطر المحتملة.

وقال جان لايكي، خبير الأمن في أنثروبيك: "لقد توصلنا إلى الصيغة الأساسية لجعل النماذج أكثر ذكاءً، لكننا لم نتوصل بعد إلى كيفية جعلها تفعل ما نريد".

المصدر: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

![[صورة] "الجميلات" يشاركن في بروفة العرض في مطار بين هوا](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

تعليق (0)