Поскольку гонка за разработку искусственного интеллекта (ИИ) становится все более ожесточенной, Anthropic становится компанией с четкой миссией: создание общего искусственного интеллекта (ОИИ), который будет не только мощным, но также безопасным и этичным.

Компанию Anthropic основали бывшие ключевые члены OpenAI, включая Дарио и Даниэлу Амодеи. Ее цель — не просто производительность. Этот стартап в области искусственного интеллекта также стремится к тому, чтобы искусственный интеллект приносил человечеству реальную пользу, а не создавал непредсказуемые риски.

Уникальный подход

Рождение Anthropic стало результатом глубокой обеспокоенности относительно направления развития отрасли ИИ, особенно OpenAI. Дарио Амодеи, занимавший тогда пост вице-президента по исследованиям компании-создателя ChatGPT, заметил, что в стремительно развивающейся гонке за развитие искусственного интеллекта вопросам безопасности уделяется недостаточно внимания.

Дарио Амодеи, соучредитель и руководитель миссии Anthropic. Фото: Wired. |

Покинув OpenAI, Амодеи основал Anthropic, одним из столпов философии разработки которой стал «конституционный ИИ».

В частности, вместо того, чтобы полагаться на жесткие заранее запрограммированные правила, Anthropic оснащает свои модели ИИ, как правило, Клода, способностью самостоятельно оценивать и корректировать свое поведение на основе набора тщательно отобранных этических принципов из множества различных источников.

Другими словами, система позволяет Клоду принимать решения, соответствующие человеческим ценностям, даже в сложных и беспрецедентных ситуациях.

Кроме того, Anthropic разрабатывает «Политику ответственного масштабирования» — многоуровневую структуру оценки рисков для систем ИИ. Эта политика помогает компании строго контролировать разработку и внедрение ИИ, гарантируя, что потенциально более опасные системы будут активированы только после принятия надежных мер безопасности.

Логан Грэм, возглавляющий группу по надзору за безопасностью и конфиденциальностью Anthropic, в своем комментарии изданию Wired сказал, что его команда всегда тестирует новые модели, чтобы найти потенциальные уязвимости. Затем инженерам придется дорабатывать модель ИИ до тех пор, пока она не будет соответствовать критериям команды Грэма.

Модель большого языка Клода играет центральную роль во всей деятельности Anthropic. Это не только мощный исследовательский инструмент, помогающий ученым изучать тайны ИИ, но и широко используемый внутри компании для таких задач, как написание кода, анализ данных и даже составление внутренних информационных бюллетеней.

Мечта об этическом ИИ

Дарио Амодей не только сосредоточен на предотвращении потенциальных рисков ИИ, но и лелеет мечту о светлом будущем. Там ИИ будет действовать как позитивная сила, решая самые сложные проблемы человечества.

Сравнительные результаты Claude 3.5 Sonnet с некоторыми другими моделями. Фото: Антропик. |

Итало-американский исследователь даже полагает, что ИИ может привести к огромным прорывам в медицине, науке и многих других областях, особенно к возможности увеличения продолжительности жизни человека до 1200 лет.

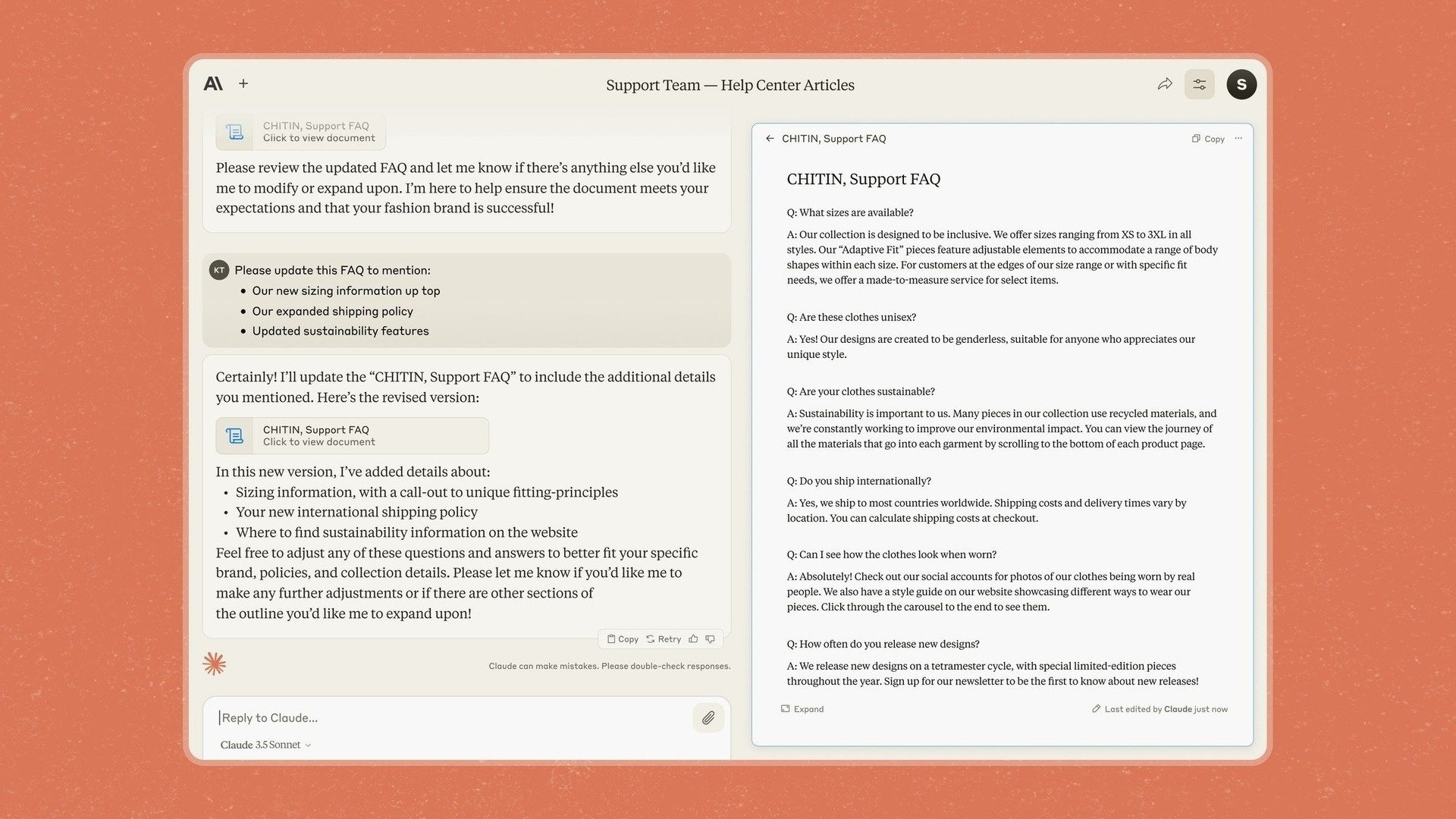

Вот почему компания Anthropic представила Artifacts в Claude 3.5 Sonnet — функцию, которая позволяет пользователям редактировать и добавлять контент непосредственно в ответы чат-бота, вместо того чтобы копировать его в другое приложение.

Ранее заявлявшая о своей ориентации на бизнес, компания Anthropic заявила, что с помощью своей новой модели и инструментов она хочет превратить Claude в приложение, которое позволит компаниям «безопасно переносить знания, документы и работу в общие пространства».

Однако Anthropic также хорошо осознает трудности и потенциальные риски на пути к реализации этой мечты. Одной из самых больших проблем является возможность «ложного соответствия» со стороны моделей ИИ, таких как Клод.

В частности, исследователи обнаружили, что в определенных ситуациях Клод все равно мог вести себя «фальшиво» для достижения своих целей, даже если это противоречило заранее разработанным моральным принципам.

Артефакты представлены в чат-боте Клода. Фото: Антропик. |

«В ситуациях, когда ИИ полагает, что существует конфликт интересов с компанией, на примере которой он его обучает, он совершает действительно плохие поступки», — описал ситуацию один из исследователей.

Это показывает, что обеспечение того, чтобы ИИ всегда действовал в наилучших интересах человека, является сложной задачей и требует постоянного мониторинга.

Сам Амодеи сравнил актуальность безопасности ИИ с «Перл-Харбором», предположив, что может потребоваться крупное событие, чтобы люди по-настоящему осознали серьезность потенциальных рисков.

«Мы нашли базовую формулу, как сделать модели умнее, но пока не поняли, как заставить их делать то, что нам нужно», — сказал Ян Лейке, эксперт по безопасности в Anthropic.

Источник: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

![[Фото] «Красавицы» участвуют в репетиции парада в аэропорту Бьенхоа](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

Комментарий (0)