저명한 국제 전문가 그룹이 지난주 베이징에서 만나 생물학 무기 제작 및 사이버 공격 수행을 포함한 AI 개발의 "적선"을 확인했습니다.

회의 며칠 후 발표된 성명에서 학자들은 "우리의 일생 동안 인류에게 재앙적이거나 심지어 존재적 위험을 예방하기 위해" AI 안전에 대한 공통된 접근 방식이 필요하다고 경고했습니다.

"냉전이 한창일 때 국제 정부와 과학 협력은 핵 재앙을 막는 데 도움이 되었습니다. "인류는 전례 없는 기술로 인해 발생할 수 있는 재앙을 막기 위해 다시 한번 힘을 합쳐야 합니다."라는 성명이 나왔습니다.

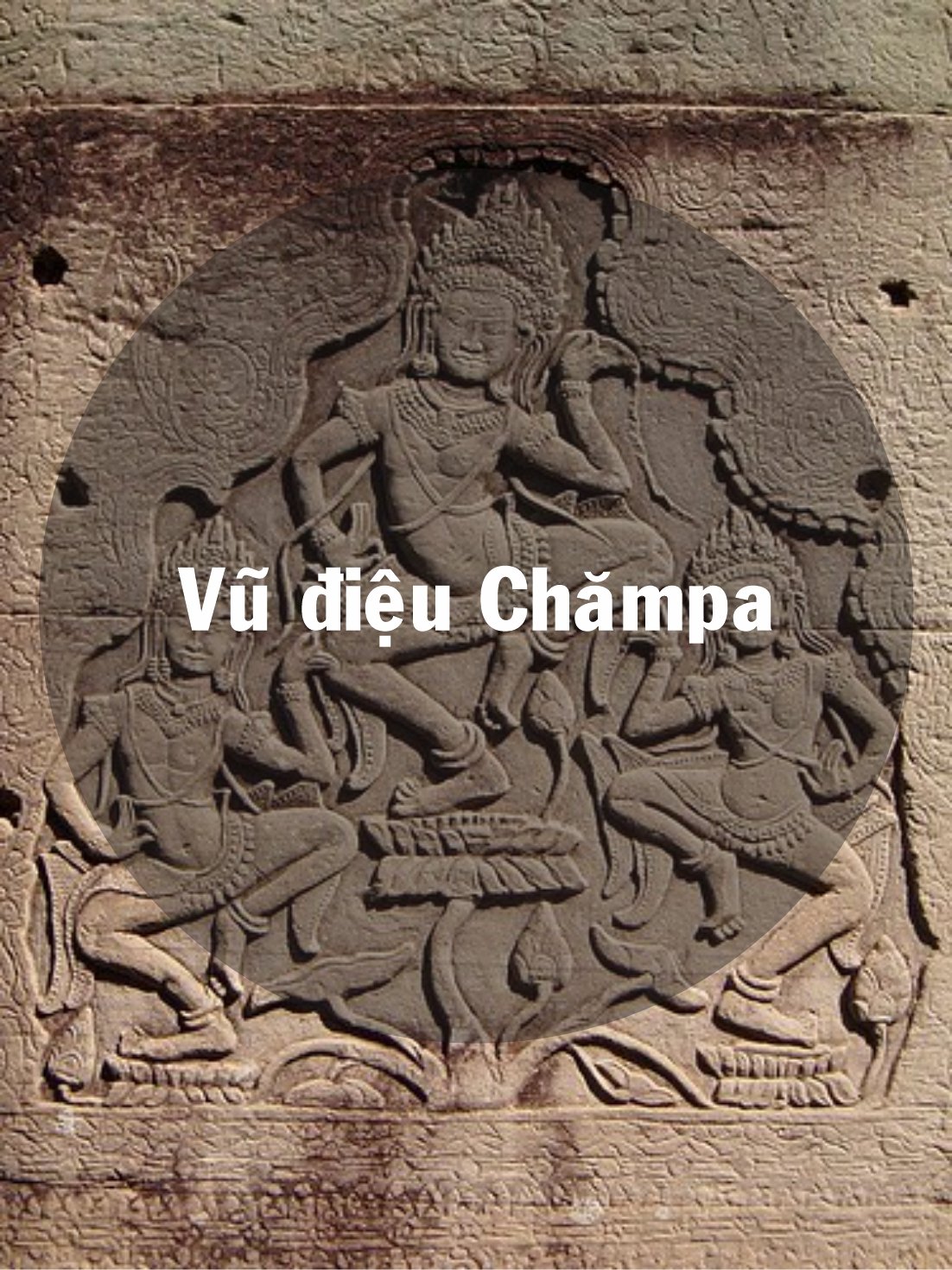

베이징에서 열리는 AI 안전에 관한 국제 대화의 전문가들은 AI 개발의 "적선"을 확인했습니다. 사진: FT

서명자에는 AI의 "아버지"로 불리는 Geoffrey Hinton과 Yoshua Bengio가 포함됩니다. 캘리포니아 대학 컴퓨터 과학 교수, 스튜어트 러셀 그리고 중국의 가장 저명한 컴퓨터 과학자 중 한 명인 앤드류 야오.

이 성명은 지난주 베이징에서 열린 국제 AI 안전 대화에 이어 나왔다. 이 회의에는 중국 정부 관리들이 참석해 포럼과 그 결과에 대한 지지를 표명했다.

지난 11월 미국 조 바이든 대통령과 중국 시진핑 국가주석은 만나 AI 안전에 대해 논의했고, 이 문제에 대한 대화의 장을 마련하기로 합의했습니다. 최근 몇 달 동안 세계 유수의 AI 기업들도 중국 AI 전문가들과 비공개로 회동했습니다.

2023년 11월, 중국을 포함한 28개국과 선도적인 AI 기업들이 영국 재무장관 리시 수낵의 AI 안전 정상회담에서 첨단 AI에서 비롯된 실존적 위험을 해결하기 위해 협력한다는 광범위한 공약을 체결했습니다.

지난주 베이징에서 전문가들은 인간과 동등하거나 더 우수한 AI 시스템인 "인공 일반 지능(AGI)"의 개발과 관련된 위협에 대해 논의했습니다.

Bengio는 "토론의 핵심 초점은 강력한 AI 시스템이 넘어서는 안 되는 한계와 전 세계 정부가 AI 개발 및 배포에 적용해야 하는 한계였습니다."라고 말했습니다.

이러한 붉은 선은 "어떤 AI 시스템도 명확한 인간의 승인과 지원 없이는 스스로를 복제하거나 개선할 수 없다" 또는 "그 힘과 영향력을 부당하게 증가시키는 행동을 취할 수 없다"는 것을 보장합니다.

과학자들은 어떤 시스템도 "행위자들이 대량 살상 무기를 설계하거나, 생물학적 또는 화학적 무기 협정을 위반하는 능력을 크게 향상시키지 못할 것"이며 "심각한 재정적 손실이나 동등한 피해를 초래하는 사이버 공격을 자동으로 수행할 수 없을 것"이라고 덧붙였다.

황하이 (FT에 따르면)

[광고2]

원천

댓글 (0)