台湾企業のFoxconnは本日(3月10日)、初の大規模言語モデルを開発し、その技術を活用して製造およびサプライチェーン管理を改善する計画を発表した。

世界最大の受託チップメーカーである同社によると、「FoxBrain」と名付けられたこのモデルは、NvidiaのH100 GPU 120個を使用してトレーニングされ、約4週間で完成したという。

Foxconn が世界最先端の標準に非常に近い初の主要言語モデルを発表しました。

アップルのiPhoneを組み立て、またNVIDIAの人工知能サーバーも製造している同社は、このモデルはMetaのLlama 3.1アーキテクチャに基づいていると述べた。

これは、繁体字中国語と台湾語の言語スタイルに最適化された推論機能を備えた台湾初の大規模言語モデルです。

Foxconnは、DeepSeekの中国製精製品と比べるとパフォーマンスに若干の差があるものの、FoxBrainの全体的なパフォーマンスは世界をリードする基準に非常に近いと述べた。

もともと社内アプリケーション用に設計された FoxBrain には、データ分析、意思決定サポート、ドキュメント共同作業、数学、推論と問題解決、プログラミング コード生成などの機能が含まれています。

フォックスコンは、テクノロジーパートナーと協力してモデルの適用範囲を拡大し、オープンソース情報を共有し、製造、サプライチェーン管理、スマートな意思決定に人工知能を活用する計画だ。

Foxconnによれば、Nvidiaは台湾にある「Taipei-1」スーパーコンピューターを通じてサポートを提供し、モデルのトレーニング中に技術的なアドバイスを提供したという。

台湾最大のスーパーコンピューター「台北1号」は、台湾南部の都市高雄でNvidiaが所有・運営している。

Foxconnは3月中旬に開催されるNvidiaのGTC開発者会議でこのモデルに関する詳細を発表する予定だ。

(出典ロイター)

[広告2]

出典: https://www.baogiaothong.vn/foxconn-ra-mat-mo-hinh-ngon-ngu-lon-dau-tien-192250310181358802.htm

![[写真] タンソンニャット第3ターミナル - 主要プロジェクトが予定より早く完了](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/85f0ae82199548e5a30d478733f4d783)

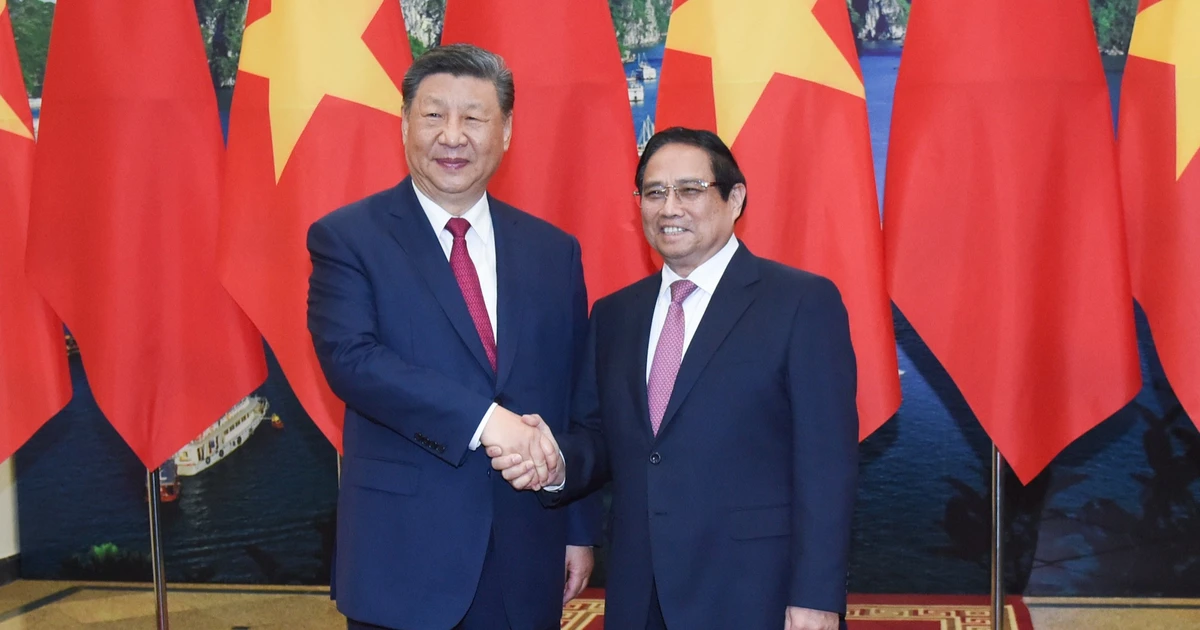

![[写真] ファム・ミン・チン首相は国営企業と協力し、デジタル変革と成長促進に取り組む](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/f55bfb8a7db84af89332844c37778476)

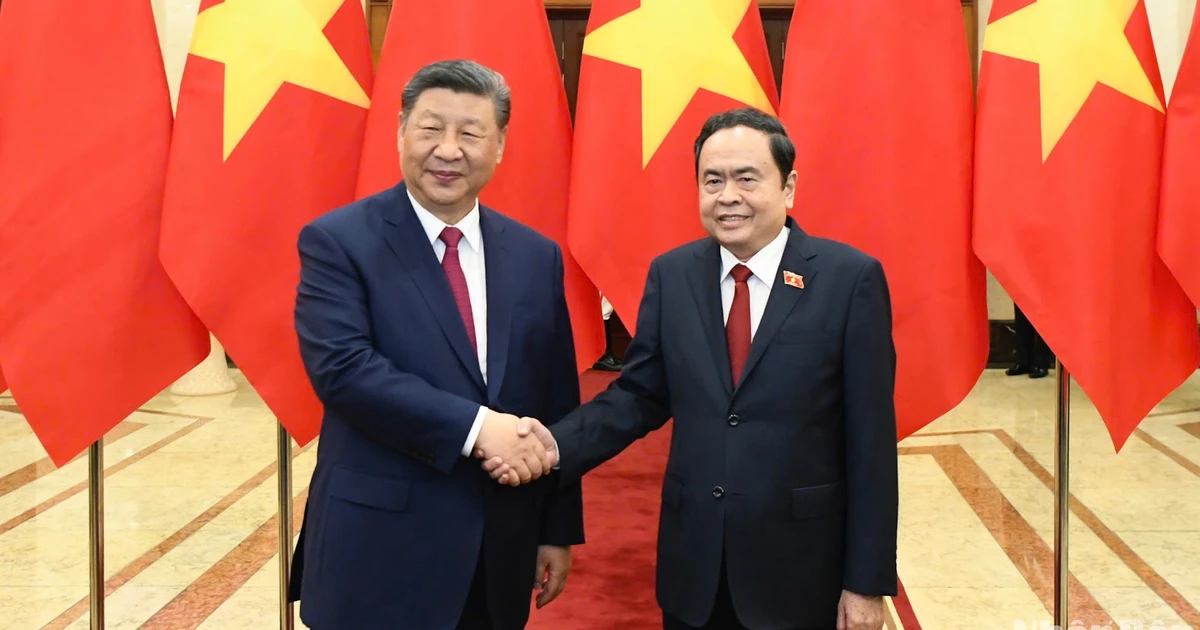

![[写真] ベトナムと中国の指導者が両国人民友好会議に出席](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/7d45d6c170034d52be046fa86b3d1d62)

![[写真] 習近平中国総書記兼国家主席歓迎レセプション](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/ef636fe84ae24df48dcc734ac3692867)

コメント (0)