人工知能(AI)の急速な発展により、その影響が人間に理解されるよりも速いペースで発展しているのではないかという懸念が生じている。

写真: ST

ChatGPT のようなツールの登場により、汎用 AI の使用が大幅に増加しました。これらのツールには多くの利点がありますが、悪意を持って誤用される可能性もあります。

このリスクを管理するために、米国および他のいくつかの国は、Amazon、Anthropic、Google、Inflection、Meta、Microsoft、OpenAIを含む7つの企業と、AI技術の開発における安全な慣行にコミットする契約を確保しました。

ホワイトハウスの発表には、「レッドチーム演習」や「ウォーターマーキング」など、一般の人には馴染みのない独自の用語が使われていた。注意すべき AI 関連用語を 7 つ紹介します。

機械学習

この AI の分野は、パターンを識別することで特定のタスクを正確に実行できるように機械をトレーニングすることを目的としています。機械はそのデータに基づいて予測を行うことができます。

ディープラーニング

クリエイティブな AI タスクは、多くの場合、ディープラーニングに依存しています。ディープラーニングとは、人間の脳のニューロンを模倣するように設計された一連のアルゴリズムであるニューラルネットワークを使用してコンピューターをトレーニングし、パターン間の複雑な接続を作成してテキスト、画像、その他のコンテンツを生成する手法です。

ディープラーニング モデルには複数のニューロン層があるため、従来の機械学習よりも複雑なパターンを学習できます。

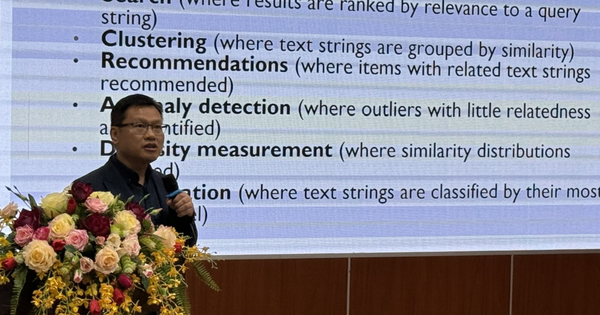

大規模言語モデル

大規模言語モデル (LLM) は、膨大な量のデータでトレーニングされ、言語をモデル化したり、シーケンス内の次の単語を予測したりすることを目的としています。 ChatGPT や Google Bard などの大規模言語モデルは、要約、翻訳、会話などのタスクに使用できます。

アルゴリズム

機械が予測を行ったり、問題を解決したり、タスクを完了したりできるようにする一連の命令または規則。アルゴリズムは、ショッピングの推奨を提供したり、不正行為の検出を支援したり、顧客サービスのチャット機能を提供したりできます。

バイアス

AI は大規模なデータセットでトレーニングされるため、ヘイトスピーチなどの有害な情報がデータに取り込まれる可能性があります。 AI のトレーニングに使用されるデータセットには人種差別や性差別も含まれ、偏ったコンテンツにつながる可能性があります。

AI企業は、AIシステムにおける有害な偏見や差別を回避する方法をさらに深く検討することに合意した。

レッドチーム

企業がホワイトハウスに対して行った公約の 1 つは、AI モデルとシステムの内外で「レッド チーム演習」を実施することです。

「レッドチーム演習」では、モデルをテストして潜在的な危害を明らかにします。この用語は、チームが攻撃者の行動をシミュレートして戦略を立てる軍事演習に由来しています。

この方法は、Microsoft や Google などの企業のクラウド コンピューティング プラットフォームなどのシステムのセキュリティ脆弱性をテストするために広く使用されています。

透かし

ウォーターマークは、音声または画像が AI によって生成されたものかどうかを確認する方法です。検証のために集められた事実には、誰がそれを作成したか、また、どのように、いつ作成または変更されたかに関する情報が含まれる場合があります。

たとえば、マイクロソフトは、自社の AI ツールで生成された画像に透かしを入れることを約束している。両社はまた、ホワイトハウスに対し、AIが生成した写真であることを示すために、画像に「透かし」を入れたり、出所を記録したりすることを約束した。

透かしは知的財産権の侵害を追跡するためにもよく使用されます。 AI 生成画像の透かしは、7 ピクセルごとにわずかに変化するなど、目に見えないノイズとして表示される場合があります。

ただし、AI 生成テキストに透かしを入れる作業はより複雑になる可能性があり、AI 生成コンテンツとして識別できるように単語テンプレートを微調整する必要がある場合があります。

ホアン・トン(ポインターによる)

[広告2]

ソース

コメント (0)