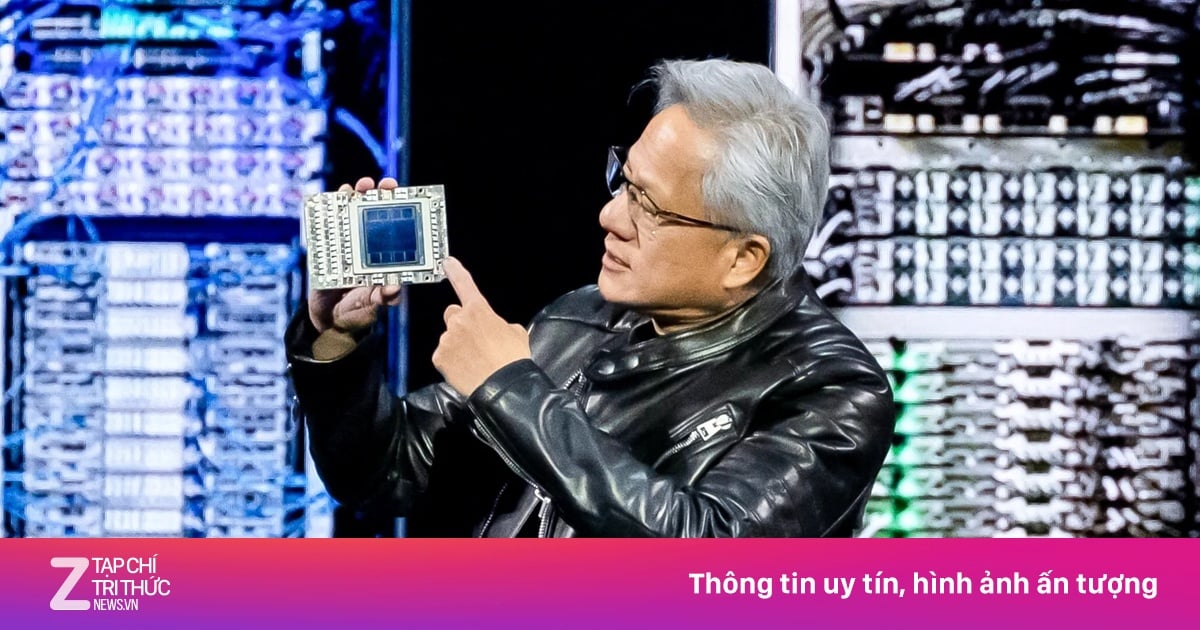

サンノゼ(米国)で開催されたGTC 2025カンファレンスにおいて、ASUSはAI PODサーバーシステムのアップグレード版を発表しました。 Nvidia GB300 NVL72 プラットフォームの統合により、システムには 72 個の Blackwell Ultra GPU と 36 個の Grace CPU が搭載され、人工知能 (AI) アプリケーションでより高いパフォーマンスを実現します。

ASUS、GTC 2025でNvidia Blackwell GPUと液体冷却技術を搭載した次世代AI PODシステムを披露

新しい AI POD はラックスケール モデルで設計されており、柔軟な拡張が可能で、ラックあたり最大 40 TB の高速メモリをサポートします。さらに、このシステムには NVIDIA Quantum-X800 InfiniBand と Spectrum-X Ethernet ネットワーキング テクノロジが統合されており、サーバー クラスター間のデータ転送速度が向上します。特に大規模言語モデル (LLM) トレーニングなどの計算集約型タスクでは、安定した動作を確保するために液体冷却も適用されます。

AI PODに加えて、Asusは、XA NB3I-E12、ESC NB8-E11、ESC N8-E11Vモデルを含む、BlackwellおよびHGXエコシステムでいくつかの新しいAIサーバーラインも発売しました。これらの製品は、データ サイエンス、金融、ヘルスケア、一般的な AI など、幅広い分野をサポートします。 Asus によれば、AI サーバーのポートフォリオを拡大することで、企業は特定のニーズに合わせた選択肢を増やすことができるという。

Asus は、新世代の AI POD は大規模なデータセンターや AI 研究組織のニーズを満たすことができると述べています。このプロジェクトで Nvidia と緊密に連携することで、大規模な AI 開発と運用を最適化できます。

[広告2]

出典: https://thanhnien.vn/asus-ra-mat-ai-pod-su-dung-chip-blackwell-gb300-tai-gtc-2025-18525031920230298.htm

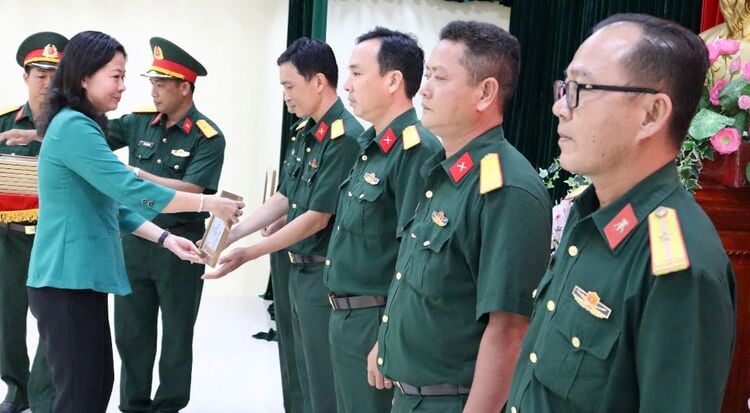

![[写真] 勝利飛行隊のパイロットたちに会いましょう](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/fd30103acbd744b89568ca707378d532)

コメント (0)