Les dangers de la perte de contrôle de l'IA

L’humanité semble ignorer un spectre à l’horizon. Il s’agit du spectre d’une guerre nucléaire mondiale provoquée par l’intelligence artificielle (IA). Le secrétaire général de l’ONU, Antonio Guterres, a mis en garde contre ce phénomène. Mais jusqu’à présent, les nations dotées de l’arme nucléaire n’ont pas réussi à se réunir pour négocier cette menace catastrophique.

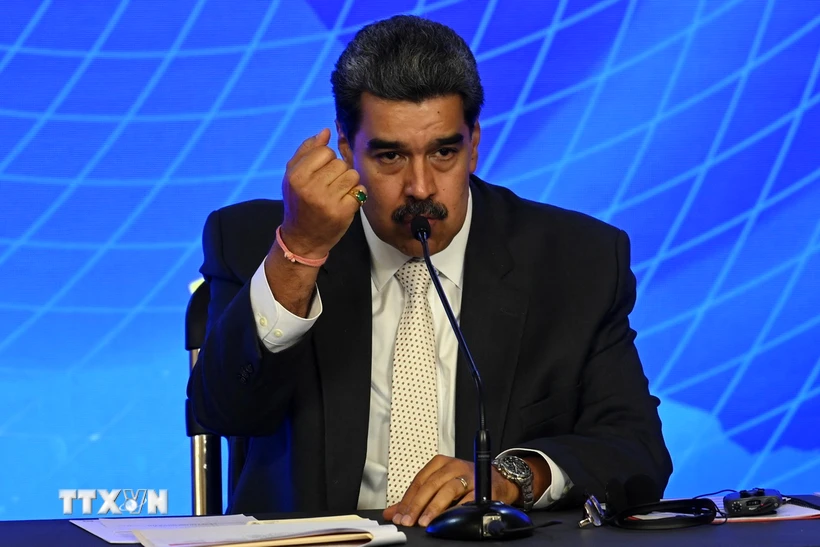

Le développement rapide de l’intelligence artificielle (IA) augmente le risque que l’IA puisse intervenir dans le processus de lancement d’armes nucléaires. Illustration

Il existe depuis longtemps un consensus informel entre les cinq plus grandes puissances nucléaires – les États-Unis, la Russie, la Chine, le Royaume-Uni et la France – sur le principe de « l’implication humaine dans la boucle », ce qui signifie que chaque pays dispose d’un système garantissant que des humains sont impliqués dans la décision de lancer des armes nucléaires.

Aucune des cinq puissances ne déclare déployer l’IA dans ses systèmes de commandement de lancement nucléaire. Selon le Dr Sundeep Waslekar, président du Strategic Foresight Group, une organisation de recherche internationale basée à Mumbai (Inde), cela est vrai mais trompeur.

L’IA est déjà utilisée pour la détection des menaces et la sélection des cibles. Les systèmes alimentés par l’IA analysent en temps réel des quantités massives de données provenant de capteurs, de satellites et de radars, analysent les attaques de missiles entrantes et suggèrent des options de réponse.

L'opérateur vérifie ensuite la menace provenant de différentes sources et décide s'il faut intercepter les missiles ennemis ou lancer des frappes de représailles.

« Actuellement, le temps de réponse des opérateurs est de 10 à 15 minutes. D'ici 2030, ce délai sera réduit à 5 à 7 minutes », a déclaré Sundeep Waslekar. Si les décisions finales seront prises par des humains, elles seront influencées par les analyses prédictives et prescriptives de l'IA. L'IA pourrait être le moteur des décisions de lancement dès les années 2030.

Le problème est que l’IA peut faire des erreurs. Les algorithmes de détection des menaces peuvent indiquer une attaque de missiles alors qu’il n’y en a pas. Cela peut être dû à des erreurs informatiques, à des intrusions dans le réseau ou à des facteurs environnementaux qui obscurcissent les signaux. À moins que les opérateurs ne confirment les fausses alarmes provenant d’autres sources dans un délai de 2 à 3 minutes, ils peuvent déclencher des attaques de représailles.

Une très petite erreur, un énorme désastre

L’utilisation de l’IA dans de nombreuses fonctions civiles telles que la prédiction de la criminalité, la reconnaissance faciale et le pronostic du cancer est connue pour avoir une marge d’erreur de 10 %. Selon M. Sundeep Waslekar, dans les systèmes d’alerte nucléaire précoce, la marge d’erreur peut être d’environ 5 %.

À mesure que la précision des algorithmes de reconnaissance d’images s’améliorera au cours de la prochaine décennie, cette marge d’erreur pourrait tomber à 1-2 %. Mais même une marge d’erreur de 1 % pourrait déclencher une guerre nucléaire mondiale.

Des décisions de frappe nucléaire ou de représailles pourraient être déclenchées par des erreurs d’IA. Photo : Modern War Institute

Le risque pourrait augmenter au cours des deux à trois prochaines années à mesure que de nouveaux logiciels malveillants émergent et sont capables de contourner les systèmes de détection des menaces. Le logiciel malveillant s'adaptera pour éviter d'être détecté, en identifiant automatiquement les cibles et en les attaquant automatiquement.

Il y a eu plusieurs situations de « politique de la corde raide » pendant la guerre froide. En 1983, un satellite soviétique a détecté par erreur cinq missiles lancés par les États-Unis. Stanislaw Petrov, un officier du centre de commandement russe Sepukhov-15, a conclu qu'il s'agissait d'une fausse alerte et n'a pas alerté ses supérieurs pour qu'ils puissent lancer une contre-attaque.

En 1995, la station radar d'Olenegorsk a détecté une attaque de missile au large des côtes norvégiennes. Les forces stratégiques russes ont été mises en état d'alerte maximale et le président russe de l'époque, Boris Eltsine, s'est vu remettre la mallette nucléaire. Il a soupçonné qu’il s’agissait d’une erreur et n’a pas appuyé sur le bouton. Il s’est avéré que c’était une fusée scientifique. Si l’IA est utilisée pour déterminer les réponses dans les deux situations, les résultats pourraient être catastrophiques.

Actuellement, les missiles hypersoniques utilisent l’automatisation conventionnelle au lieu de l’IA. Ils peuvent voyager à des vitesses allant de Mach 5 à Mach 25, évitant ainsi la détection radar et contrôlant leur trajectoire de vol. Les superpuissances prévoient d’améliorer les missiles hypersoniques avec l’IA pour localiser et détruire instantanément les cibles en mouvement, transférant la décision de tuer des humains aux machines.

Il existe également une course au développement de l’intelligence artificielle générale, qui pourrait conduire à des modèles d’IA fonctionnant au-delà du contrôle humain. Lorsque cela se produit, les systèmes d’IA apprendront à s’améliorer et à se répliquer, prenant ainsi le contrôle des processus de prise de décision. Lorsque cette IA sera intégrée aux systèmes d’aide à la décision pour les armes nucléaires, les machines seront en mesure de déclencher des guerres dévastatrices.

Il est temps d'agir

Face aux risques mentionnés ci-dessus, de nombreux experts estiment que l’humanité a besoin d’un accord global entre les grandes puissances pour minimiser le risque de guerre nucléaire, allant au-delà de la répétition du slogan « les humains dans la boucle ».

Cet accord doit inclure des mesures de transparence, de responsabilité et de coopération ; normes internationales en matière de tests et d’évaluation; canaux de communication de crise; commissions nationales de surveillance; et des règles visant à interdire les modèles d’IA agressifs capables de contourner les opérateurs humains.

Le Secrétaire général António Guterres assiste à une cérémonie commémorative pour la paix à Hiroshima, ville frappée par une bombe atomique en 1945. Photo : ONU

Les changements géopolitiques créent une opportunité pour un tel traité. Par exemple, d’éminents experts en IA de Chine et des États-Unis ont participé à un certain nombre de dialogues de deux axes sur les risques liés à l’IA, qui ont abouti à une déclaration conjointe de l’ancien président américain Joe Biden et du président chinois Xi Jinping en novembre dernier.

Selon le Dr Sundeep Waslekar, le milliardaire Elon Musk est un ardent défenseur de la nécessité de sauver l’humanité des risques existentiels posés par l’IA. M. Musk pourrait exhorter l’actuel président américain Donald Trump à transformer la déclaration conjointe entre M. Joe Biden et M. Xi Jinping en un traité.

Le défi de l’IA nucléaire nécessite également la participation de la Russie, selon le Dr Sundeep Waslekar. Jusqu’en janvier de cette année, la Russie a refusé de discuter de toute mesure de réduction des risques nucléaires, y compris la convergence avec l’IA, à moins que la question ukrainienne ne soit évoquée.

Alors que le président Donald Trump a engagé un dialogue avec le président russe Vladimir Poutine pour améliorer les relations bilatérales et mettre fin à la guerre en Ukraine, la Russie pourrait désormais être ouverte aux discussions.

En février de cette année, à la suite du discours du vice-président américain JD Vance au Sommet d'action sur l'IA de Paris, le Center for a New American Security (CNAS) a également publié un rapport intitulé « Prévenir l'apocalypse de l'IA : la concurrence entre les États-Unis, la Chine et la Russie au carrefour des armes nucléaires et de l'intelligence artificielle ».

Le rapport identifie les risques les plus importants du lien entre l’IA et le nucléaire et exhorte l’administration américaine à établir un ensemble complet de mécanismes d’atténuation des risques et de gestion de crise avec la Chine et la Russie.

En septembre dernier, environ 60 pays, dont les États-Unis, avaient adopté un « plan d’action » pour gérer l’utilisation responsable de l’IA dans l’armée lors du sommet REAIM (Responsable AI in Military) qui s’est tenu à Séoul, en Corée du Sud. Il s’agit de la deuxième conférence de ce type, après celle qui s’est tenue à La Haye l’année dernière. Ces mouvements montrent que le risque d’une guerre nucléaire initiée par l’IA n’est pas de la science-fiction.

Le monde est clairement confronté à un problème existentiel de plus en plus urgent qui nécessite une action réelle de la part des puissances nucléaires pour garantir que « chaque décision concernant l’utilisation d’armes nucléaires soit prise par des personnes, et non par des machines ou des algorithmes » – comme l’a demandé le secrétaire général de l’ONU, Antonio Guterres.

Nguyen Khanh

![[Photo] Le journal Nhan Dan célèbre le 94e anniversaire de la fondation de l'Union de la jeunesse communiste Ho Chi Minh](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/5571705682934ac5be5014ce171facb4)

![[Photo] Le ministre de la Défense préside l'inspection des exercices de défilé et de marche](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/35c2dd58a3e840d3a8cd615e70e89039)

![[Photo] Le secrétaire général To Lam préside la réunion permanente du Comité directeur central sur la prévention et la lutte contre la corruption, le gaspillage et la négativité](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/839ea9ed0cd8400a8ba1c1ce0728b2be)

Comment (0)