|

L’IA ne peut pas encore remplacer les humains dans le domaine de la programmation. Photo : John McGuire . |

Ces derniers temps, les principaux modèles d’IA d’OpenAI et d’Anthropic sont de plus en plus utilisés pour la programmation d’applications. ChatGPT et Claude ont augmenté la mémoire et la puissance de traitement pour pouvoir analyser des centaines de lignes de code, ou Gemini a intégré un affichage des résultats Canvas spécifiquement pour les programmeurs.

En octobre 2024, le PDG de Google, Sundar Pichai, a déclaré que 25 % du nouveau code de l'entreprise était généré par l'IA. Mark Zuckerberg, PDG de Meta, a également exprimé son ambition de déployer largement des modèles d'IA de codage au sein de l'entreprise.

Cependant, une nouvelle étude de Microsoft Research, la branche R&D de Microsoft, montre que les modèles d'IA, notamment Claude 3.7 Sonnet d'Anthropic et o3-mini d'OpenAI, n'ont pas réussi à gérer de nombreuses erreurs dans un benchmark de test de programmation appelé SWE-bench Lite.

Les auteurs de l’étude ont testé neuf modèles d’IA différents qui ont été intégrés à une variété d’outils de débogage comme le débogueur Python, et ont pu gérer le problème en une seule instruction. Les modèles ont été chargés de résoudre 300 bugs logiciels sélectionnés dans l'ensemble de données SWE-bench Lite.

|

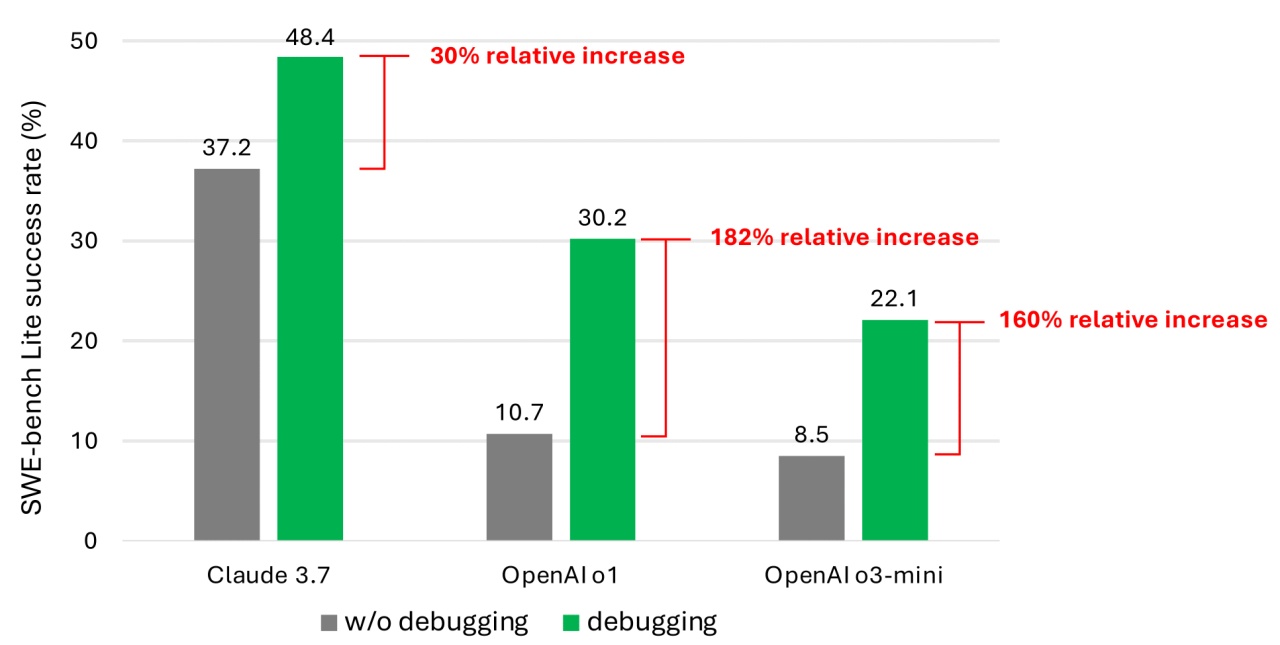

Taux de réussite lors de la résolution de problèmes de programmation à partir de l'ensemble de données SWE-bench Lite. Photo : Microsoft. |

Même lorsqu'ils sont équipés de modèles plus récents et plus puissants, les résultats montrent que les agents d'IA accomplissent rarement avec succès plus de la moitié des tâches de débogage assignées. Parmi les modèles testés, Claude 3.7 Sonnet a obtenu le taux de réussite moyen le plus élevé avec 48,4 %, suivi par o1 d'OpenAI avec 30,2 % et o3-mini avec 22,1 %.

Certaines des raisons de ces faibles performances incluent le fait que certains modèles ne comprennent pas comment appliquer les outils de débogage fournis. En outre, selon les auteurs, le problème le plus important réside dans le manque de données.

Ils soutiennent que le système de formation des modèles manque encore de données qui simulent les étapes de débogage que les humains suivent du début à la fin. En d’autres termes, l’IA n’a pas suffisamment appris sur la façon dont les humains pensent et agissent étape par étape lorsqu’ils sont confrontés à un véritable bug logiciel.

La formation et le perfectionnement des modèles leur permettront de mieux déboguer les logiciels. « Cependant, cela nécessiterait des ensembles de données spécialisés pour la formation », ont déclaré les auteurs.

De nombreuses études ont mis en évidence des vulnérabilités de sécurité et des erreurs dans l’IA lors de la génération de code, en raison de faiblesses telles qu’une capacité limitée à comprendre la logique de programmation. Une étude récente de Devin, un outil de programmation d’IA, a révélé qu’il n’avait réussi que 3 tests de programmation sur 20.

La programmabilité de l’IA reste controversée. Auparavant, M. Kevin Weil, directeur produit d'OpenAI, avait déclaré que d'ici la fin de cette année, l'IA dépasserait les programmeurs humains.

D’un autre côté, Bill Gates, cofondateur de Microsoft, estime que la programmation restera une carrière viable à l’avenir. D’autres dirigeants comme Amjad Masad (PDG de Replit), Todd McKinnon (PDG d’Okta) et Arvind Krishna (PDG d’IBM) ont également exprimé leur soutien à ce point de vue.

Les recherches de Microsoft, bien que pas nouvelles, rappellent également aux programmeurs, y compris aux managers, de réfléchir plus attentivement avant de donner le contrôle total du codage à l'IA.

Source : https://znews.vn/diem-yeu-chi-mang-cua-ai-post1545220.html

![[Photo] Ouverture de la Conférence nationale pour diffuser et mettre en œuvre la résolution de la 11e Conférence centrale](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/16/e19da044c71d4330b6a03f49adcdb4f7)

![[Photo] Les deux Premiers ministres ont assisté à la cérémonie de signature de documents de coopération entre le Vietnam et l'Éthiopie.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/16e350289aec4a6ea74b93ee396ada21)

![[Photo] Le Premier ministre Pham Minh Chinh s'entretient avec le Premier ministre éthiopien Abiy Ahmed Ali](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/15/4f7ba52301694c32aac39eab11cf70a4)

![[Photo] La capitale de la province de Binh Phuoc entre dans la saison politique](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/16/c91c1540a5744f1a80970655929f4596)

Comment (0)