Selon Android Authority , le document de recherche d'Apple détaille une solution permettant d'exécuter de grands modèles de langage (LLM) sur des appareils dotés d'une RAM limitée. L'article révèle comment l'entreprise peut stocker des « paramètres de modèle » et charger des parties de ceux-ci dans la RAM de l'appareil lorsque cela est nécessaire au lieu de charger l'intégralité du modèle dans la RAM.

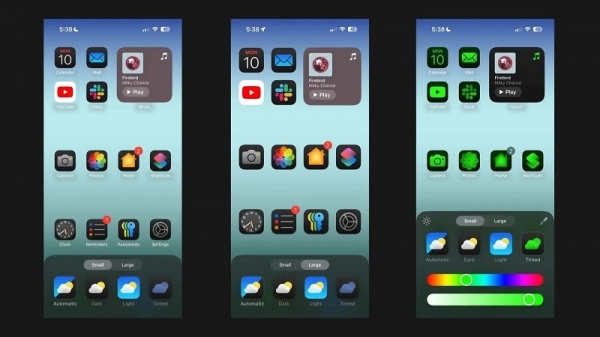

Apple cherche à aider les anciens iPhones avec moins de RAM à exécuter l'IA générale

L'article affirme que cette méthode permet d'exécuter des modèles qui nécessitent deux fois plus de RAM qu'un iPhone peut avoir tout en garantissant des vitesses d'inférence 4 à 5 fois et 20 à 25 fois supérieures par rapport aux méthodes de chargement simples sur le CPU et le GPU respectivement.

Le déploiement de l’IA synthétique sur des appareils dotés de plus de RAM sera bénéfique car il offre des vitesses de lecture/écriture plus rapides. La vitesse est importante pour l'IA sur l'appareil, permettant des temps d'inférence beaucoup plus rapides car les utilisateurs n'ont pas nécessairement besoin d'attendre des dizaines de secondes (ou plus) pour obtenir une réponse ou un résultat final. Tout cela signifie un assistant IA sur l’appareil qui peut fonctionner à des vitesses conversationnelles, générer des images/textes beaucoup plus rapidement, résumer des articles plus rapidement… Mais la solution d’Apple signifie que les utilisateurs n’ont pas nécessairement besoin de beaucoup de RAM pour accélérer la réactivité des tâches d’IA sur l’appareil.

L'approche d'Apple pourrait permettre aux iPhones, anciens et nouveaux, d'offrir des fonctionnalités d'IA synthétiques directement sur leurs appareils. C'est important car les iPhones d'Apple offrent généralement moins de RAM que les téléphones Android haut de gamme. Par exemple, la série iPhone 11 n'offre que 4 Go de RAM, tandis que même l'iPhone 15 standard n'a que 6 Go de RAM.

Apple n’est pas la seule entreprise de téléphonie mobile à tenter de réduire le nombre de LLM. Les puces phares récentes de Qualcomm et MediaTek prennent toutes deux en charge la précision INT4 pour réduire ces modèles. Quoi qu’il en soit, les entreprises tentent de trouver de nouvelles solutions pour réduire les exigences système pour l’IA sur l’appareil, permettant même aux téléphones bas de gamme d’offrir cette fonctionnalité.

Lien source

![[Photo] Résumé des exercices de défilé en préparation de la célébration du 30 avril](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/78cfee0f2cc045b387ff1a4362b5950f)

![[Photo] Retour sur les moments impressionnants de l'équipe de sauvetage vietnamienne au Myanmar](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/5623ca902a934e19b604c718265249d0)

![[Photo] Les « Beautés » participent à la répétition du défilé à l'aéroport de Bien Hoa](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

Comment (0)