Los peligros de perder el control de la IA

La humanidad parece estar ignorando un espectro en el horizonte. Es el espectro de una guerra nuclear global causada por la inteligencia artificial (IA). El Secretario General de la ONU, Antonio Guterres, ha advertido sobre este asunto. Pero hasta ahora, las naciones con armas nucleares no han logrado unirse para negociar esta amenaza catastrófica.

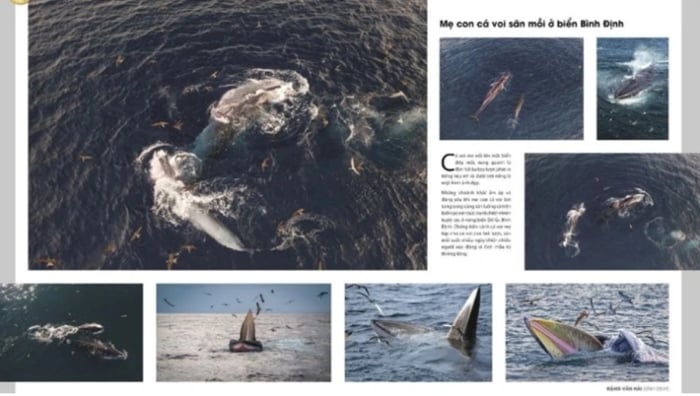

El rápido desarrollo de la inteligencia artificial (IA) aumenta el riesgo de que ésta pueda intervenir en el proceso de lanzamiento de armas nucleares. Ilustración

Desde hace tiempo existe un consenso informal entre las cinco mayores potencias nucleares (Estados Unidos, Rusia, China, el Reino Unido y Francia) sobre el principio de "humanos en el circuito", lo que significa que cada país tiene un sistema para garantizar que los humanos participen en la decisión de lanzar armas nucleares.

Ninguna de las cinco potencias afirma que implementa IA en sus sistemas de comando de lanzamiento nuclear. Según el Dr. Sundeep Waslekar, presidente de Strategic Foresight Group, una organización de investigación internacional con sede en Mumbai (India), esto es cierto pero engañoso.

La IA ya se está utilizando para la detección de amenazas y la selección de objetivos. Los sistemas impulsados por IA analizan cantidades masivas de datos de sensores, satélites y radares en tiempo real, analizan los ataques con misiles entrantes y sugieren opciones de respuesta.

Luego, el operador verifica la amenaza de diferentes fuentes y decide si interceptar los misiles enemigos o lanzar ataques de represalia.

“Actualmente, el tiempo de respuesta de los operadores es de 10 a 15 minutos. Para 2030, este tiempo se reducirá a entre 5 y 7 minutos”, afirmó Sundeep Waslekar. Si bien los humanos tomarán las decisiones finales, se verán influenciados por el análisis predictivo y prescriptivo de la IA. La IA podría ser el motor de las decisiones de lanzamiento ya en la década de 2030.

El problema es que la IA puede cometer errores. Los algoritmos de detección de amenazas pueden indicar un ataque con misiles cuando no existe ninguno. Podría deberse a errores de la computadora, intrusiones en la red o factores ambientales que oscurecen las señales. A menos que los operadores confirmen las falsas alarmas de otras fuentes dentro de 2 a 3 minutos, podrían desencadenar ataques de represalia.

Un error muy pequeño, un desastre enorme

Se sabe que el uso de IA en muchas funciones civiles, como la predicción de delitos, el reconocimiento facial y el pronóstico del cáncer, tiene un margen de error del 10%. Según el Sr. Sundeep Waslekar, en los sistemas de alerta temprana nuclear, el margen de error puede ser de alrededor del 5%.

A medida que la precisión de los algoritmos de reconocimiento de imágenes mejore durante la próxima década, este margen de error podría caer al 1-2%. Pero incluso un margen de error del 1% podría iniciar una guerra nuclear global.

Las decisiones sobre ataques nucleares o represalias podrían ser provocadas por errores de la IA. Fotografía: Instituto de Guerra Moderna

El riesgo podría aumentar en los próximos dos o tres años a medida que surja nuevo malware capaz de eludir los sistemas de detección de amenazas. El malware se adaptará para evitar ser detectado, identificando automáticamente los objetivos y atacándolos automáticamente.

Durante la Guerra Fría hubo varias situaciones de “políticas arriesgadas”. En 1983, un satélite soviético detectó por error cinco misiles lanzados por Estados Unidos. Stanislaw Petrov, un oficial del centro de comando ruso Sepukhov-15, concluyó que fue una falsa alarma y no alertó a sus superiores para que pudieran lanzar un contraataque.

En 1995, la estación de radar de Olenegorsk detectó un ataque con misiles frente a la costa de Noruega. Las fuerzas estratégicas de Rusia fueron puestas en alerta máxima y el entonces presidente ruso, Boris Yeltsin, recibió el maletín nuclear. Sospechó que fue un error y no presionó el botón. Resultó que era un cohete científico. Si se utiliza IA para determinar las respuestas en ambas situaciones, los resultados podrían ser catastróficos.

Actualmente, los misiles hipersónicos utilizan automatización convencional en lugar de IA. Pueden viajar a velocidades de Mach 5 a Mach 25, evitando la detección del radar y controlando su trayectoria de vuelo. Las superpotencias están planeando mejorar los misiles hipersónicos con IA para localizar y destruir instantáneamente objetivos en movimiento, trasladando la decisión de matar de los humanos a las máquinas.

También existe una carrera para desarrollar inteligencia artificial general, que podría conducir a modelos de IA que operen más allá del control humano. Cuando esto suceda, los sistemas de IA aprenderán a mejorar y replicarse, tomando el control de los procesos de toma de decisiones. Cuando dicha IA se integre en sistemas de apoyo a la toma de decisiones sobre armas nucleares, las máquinas podrán iniciar guerras devastadoras.

Es hora de actuar

Ante los riesgos citados, muchos expertos consideran que la humanidad necesita un acuerdo global entre las grandes potencias para minimizar el riesgo de una guerra nuclear, yendo más allá de repetir el lema “humanos en el circuito”.

Este acuerdo debe incluir medidas de transparencia, rendición de cuentas y cooperación; Normas internacionales de pruebas y evaluación; canales de comunicación de crisis; comisiones nacionales de supervisión; y reglas para prohibir modelos de IA agresivos que sean capaces de eludir a los operadores humanos.

El Secretario General António Guterres asiste a una ceremonia conmemorativa de la paz en Hiroshima, ciudad que fue alcanzada por una bomba atómica en 1945. Foto: ONU

Los cambios geopolíticos están creando una oportunidad para un tratado de este tipo. Por ejemplo, los principales expertos en IA de China y Estados Unidos han participado en una serie de diálogos de segunda vía sobre los riesgos de la IA, que llevaron a una declaración conjunta del expresidente estadounidense Joe Biden y el presidente chino Xi Jinping en noviembre pasado.

Según el Dr. Sundeep Waslekar, el multimillonario Elon Musk es un firme defensor de la necesidad de salvar a la humanidad de los riesgos existenciales que plantea la IA. Musk podría instar al actual presidente de Estados Unidos, Donald Trump, a convertir la declaración conjunta entre Joe Biden y Xi Jinping en un tratado.

El desafío de la inteligencia artificial nuclear también requiere la participación de Rusia, según el Dr. Sundeep Waslekar. Hasta enero de este año, Rusia se negó a discutir cualquier medida de reducción del riesgo nuclear, incluida la convergencia con IA, a menos que se planteara el tema de Ucrania.

Ahora que el presidente Donald Trump está dialogando con el presidente ruso Vladimir Putin para mejorar las relaciones bilaterales y poner fin a la guerra en Ucrania, Rusia podría estar abierta a las conversaciones.

En febrero de este año, tras el discurso del vicepresidente estadounidense J.D. Vance en la Cumbre de Acción sobre IA de París, el Centro para una Nueva Seguridad Estadounidense (CNAS) también publicó un informe titulado "Cómo prevenir el fin del mundo de la IA: la competencia entre Estados Unidos, China y Rusia en el nexo de las armas nucleares y la inteligencia artificial".

El informe identifica los riesgos más significativos del nexo entre la IA y la energía nuclear e insta a la administración estadounidense a establecer un conjunto integral de mecanismos de mitigación de riesgos y gestión de crisis con China y Rusia.

Anteriormente, en septiembre del año pasado, alrededor de 60 países, incluido Estados Unidos, adoptaron un "plan de acción" para gestionar el uso responsable de la IA en el ejército en la Cumbre de IA Responsable en el Ejército (REAIM) celebrada en Seúl, Corea del Sur. Esta es la segunda conferencia de este tipo, después de la celebrada en La Haya el año pasado. Estos movimientos demuestran que el riesgo de una guerra nuclear iniciada por la IA no es ciencia ficción.

El mundo se enfrenta claramente a un problema existencial cada vez más urgente que requiere acciones reales por parte de las potencias nucleares para garantizar que “toda decisión sobre el uso de armas nucleares sea tomada por personas, no por máquinas o algoritmos”, como ha pedido el Secretario General de las Naciones Unidas, Antonio Guterres.

Nguyen Khanh

![[Foto] Primer plano de un antiguo edificio de apartamentos a la espera de ser renovado.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/bb2001a1b6fe478a8085a5fa20ef4761)

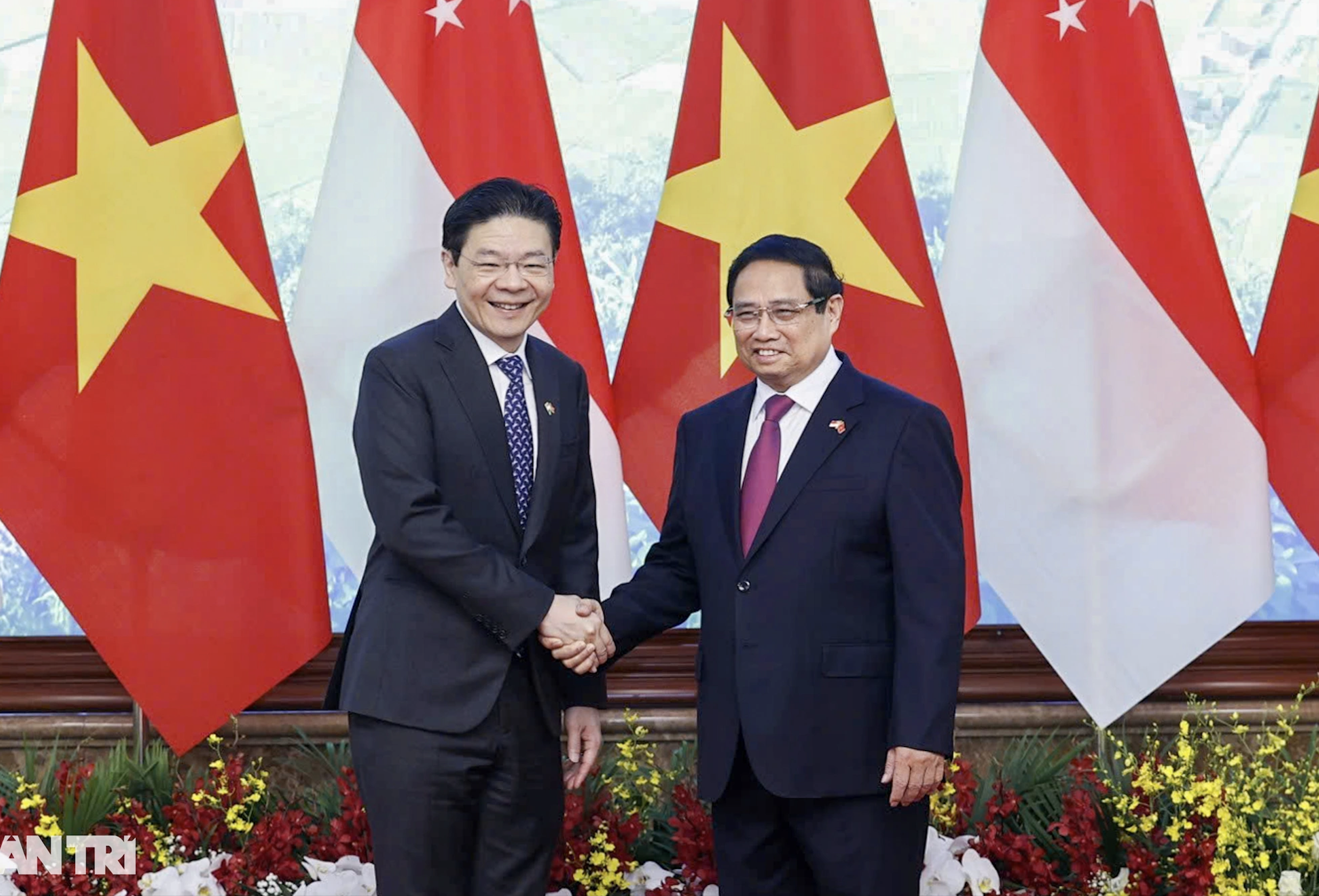

![[Foto] Ceremonia de bienvenida del Primer Ministro de la República de Singapur, Lawrence Wong, en visita oficial a Vietnam.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/445d2e45d70047e6a32add912a5fde62)

![[Foto] El jefe de la Comisión Central de Propaganda y Movilización de Masas, Nguyen Trong Nghia, trabaja con importantes agencias de prensa política.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/3020480dccf043828964e896c43fbc72)

Kommentar (0)