Die Gefahren des Kontrollverlusts über KI

Die Menschheit scheint ein Gespenst am Horizont zu ignorieren. Es ist das Schreckgespenst eines globalen Atomkriegs, der durch künstliche Intelligenz (KI) verursacht wird. UN-Generalsekretär Antonio Guterres hat davor gewarnt. Doch bislang ist es den Atommächten nicht gelungen, gemeinsam über diese katastrophale Bedrohung zu verhandeln.

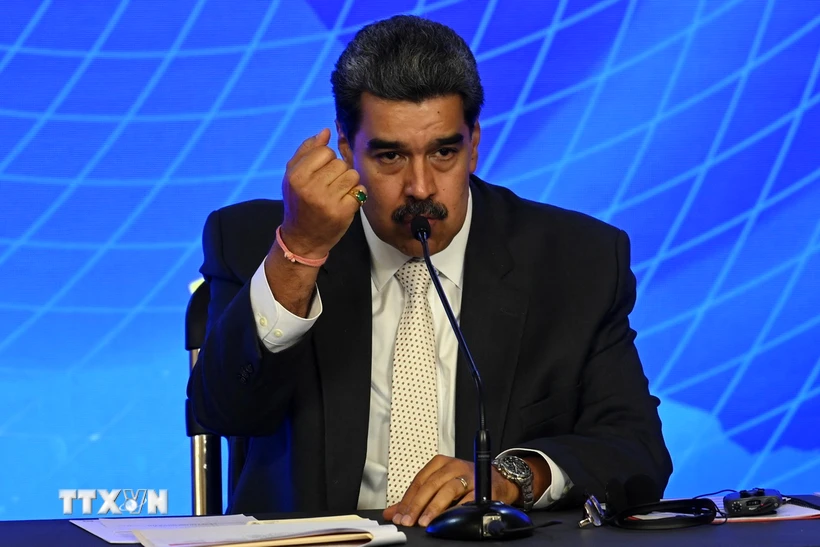

Die rasante Entwicklung der künstlichen Intelligenz (KI) birgt das Risiko, dass KI in den Prozess des Abschusses von Atomwaffen eingreifen könnte. Illustration

Unter den fünf größten Atommächten – den USA, Russland, China, Großbritannien und Frankreich – besteht seit langem ein informeller Konsens über das Prinzip der „Humans in the Loop“. Das bedeutet, dass jedes Land über ein System verfügt, das sicherstellt, dass Menschen an der Entscheidung über den Einsatz von Atomwaffen beteiligt sind.

Keine der fünf Mächte gibt an, dass sie in ihren Kommandosystemen für den Start von Atomwaffen KI einsetzen. Laut Dr. Sundeep Waslekar, Vorsitzender der Strategic Foresight Group, einer internationalen Forschungsorganisation in Mumbai (Indien), ist dies zwar wahr, aber irreführend.

KI wird bereits zur Bedrohungserkennung und Zielauswahl eingesetzt. KI-gestützte Systeme analysieren in Echtzeit riesige Datenmengen von Sensoren, Satelliten und Radaren, analysieren eingehende Raketenangriffe und schlagen Reaktionsmöglichkeiten vor.

Anschließend prüft der Bediener die Bedrohung aus verschiedenen Quellen und entscheidet, ob feindliche Raketen abgefangen oder Vergeltungsschläge durchgeführt werden sollen.

„Derzeit beträgt die den Betreibern zur Verfügung stehende Reaktionszeit 10 bis 15 Minuten. Bis 2030 wird sie auf 5 bis 7 Minuten reduziert“, sagte Sundeep Waslekar. „Während Menschen die endgültigen Entscheidungen treffen, werden sie von der prädiktiven und präskriptiven Analytik der KI beeinflusst. KI könnte bereits in den 2030er Jahren die treibende Kraft hinter Startentscheidungen sein.“

Das Problem ist, dass KI Fehler machen kann. Algorithmen zur Bedrohungserkennung können einen Raketenangriff anzeigen, wenn keiner vorliegt. Die Ursache könnten Computerfehler, Netzwerkangriffe oder Umweltfaktoren sein, die die Signale beeinträchtigen. Sofern die Betreiber Fehlalarme aus anderen Quellen nicht innerhalb von zwei bis drei Minuten bestätigen, können sie Vergeltungsangriffe auslösen.

Sehr kleiner Fehler, große Katastrophe

Beim Einsatz von KI in vielen zivilen Bereichen wie der Kriminalitätsvorhersage, Gesichtserkennung und Krebsprognose ist eine Fehlerquote von 10 % bekannt. Laut Herrn Sundeep Waslekar kann die Fehlerquote bei nuklearen Frühwarnsystemen etwa 5 % betragen.

Da sich die Genauigkeit der Bilderkennungsalgorithmen im Laufe des nächsten Jahrzehnts verbessert, könnte diese Fehlerspanne auf 1–2 % sinken. Aber selbst eine Fehlerquote von 1 % könnte einen globalen Atomkrieg auslösen.

Entscheidungen über einen Atomschlag oder Vergeltungsschläge könnten durch KI-Fehler ausgelöst werden. Foto: Modern War Institute

Das Risiko könnte in den nächsten zwei bis drei Jahren zunehmen, da neue Schadsoftware auftaucht, die in der Lage ist, Bedrohungserkennungssysteme zu umgehen. Um einer Erkennung zu entgehen, passt sich die Schadsoftware an, indem sie Ziele automatisch identifiziert und automatisch angreift.

Während des Kalten Krieges kam es zu mehreren Situationen, in denen es um „Konfrontation“ ging. Im Jahr 1983 registrierte ein sowjetischer Satellit fälschlicherweise fünf von den USA abgefeuerte Raketen. Stanislaw Petrow, ein Offizier im russischen Kommandozentrum Sepukhov-15, kam zu dem Schluss, dass es sich um einen Fehlalarm handelte, und alarmierte seine Vorgesetzten nicht, damit diese einen Gegenangriff starten konnten.

1995 registrierte die Radarstation Olenegorsk einen Raketenangriff vor der Küste Norwegens. Die strategischen Streitkräfte Russlands wurden in höchste Alarmbereitschaft versetzt und dem damaligen russischen Präsidenten Boris Jelzin wurde der Atomkoffer übergeben. Er vermutete einen Fehler und drückte den Knopf nicht. Es stellte sich heraus, dass es eine wissenschaftliche Rakete war. Wenn in beiden Situationen KI zur Bestimmung der Reaktionen eingesetzt wird, könnten die Folgen katastrophal sein.

Derzeit nutzen Hyperschallraketen konventionelle Automatisierung statt KI. Sie können Geschwindigkeiten von Mach 5 bis Mach 25 erreichen, wobei sie Radarerkennung vermeiden und ihre Flugroute kontrollieren können. Supermächte planen, Hyperschallraketen mit künstlicher Intelligenz auszustatten, um bewegliche Ziele sofort zu orten und zu zerstören und so die Entscheidung über das Töten vom Menschen auf die Maschine zu verlagern.

Darüber hinaus findet ein Wettlauf um die Entwicklung allgemeiner künstlicher Intelligenz statt, der zu KI-Modellen führen könnte, die außerhalb der menschlichen Kontrolle operieren. Wenn dies geschieht, werden KI-Systeme lernen, sich selbst zu verbessern und zu replizieren und Entscheidungsprozesse zu übernehmen. Wenn eine solche KI in Entscheidungsunterstützungssysteme für Atomwaffen integriert wird, können Maschinen verheerende Kriege auslösen.

Zeit zu handeln

Angesichts der oben genannten Risiken sind viele Experten der Ansicht, dass die Menschheit zur Minimierung des Risikos eines Atomkriegs eine umfassende Vereinbarung zwischen den Großmächten braucht, die über die bloße Wiederholung des Slogans „Menschen in der Schleife“ hinausgeht.

Diese Vereinbarung muss Maßnahmen zur Transparenz, Rechenschaftspflicht und Zusammenarbeit enthalten. internationale Standards für Tests und Bewertungen; Krisenkommunikationskanäle; nationale Aufsichtskommissionen; und Regeln zum Verbot aggressiver KI-Modelle, die menschliche Bediener umgehen können.

Generalsekretär António Guterres nimmt an einer Gedenkzeremonie für den Frieden in Hiroshima teil, das 1945 von einer Atombombe getroffen wurde. Foto: UN

Geopolitische Veränderungen bieten die Möglichkeit für einen solchen Vertrag. So führten beispielsweise führende KI-Experten aus China und den USA eine Reihe von Dialogen im Rahmen der zweiten Reihe über KI-Risiken durch, die im vergangenen November zu einer gemeinsamen Erklärung des ehemaligen US-Präsidenten Joe Biden und des chinesischen Präsidenten Xi Jinping führten.

Laut Dr. Sundeep Waslekar ist der Milliardär Elon Musk ein überzeugter Verfechter der Notwendigkeit, die Menschheit vor den existenziellen Risiken der KI zu retten. Herr Musk könnte den derzeitigen US-Präsidenten Donald Trump dazu drängen, die gemeinsame Erklärung von Joe Biden und Xi Jinping in einen Vertrag umzuwandeln.

Laut Dr. Sundeep Waslekar erfordert die Herausforderung der nuklearen KI auch die Beteiligung Russlands. Bis Januar dieses Jahres weigerte sich Russland, über Maßnahmen zur Reduzierung des nuklearen Risikos, einschließlich einer Konvergenz mit AI, zu diskutieren, sofern die Ukraine-Frage nicht zur Sprache gebracht wurde.

Da Präsident Donald Trump einen Dialog mit dem russischen Präsidenten Wladimir Putin zur Verbesserung der bilateralen Beziehungen und zur Beendigung des Krieges in der Ukraine führt, ist Russland nun möglicherweise für Gespräche offen.

Im Februar dieses Jahres veröffentlichte das Center for a New American Security (CNAS) im Anschluss an die Rede des US-Vizepräsidenten JD Vance auf dem Pariser AI Action Summit außerdem einen Bericht mit dem Titel „Preventing the AI Doomsday: US-China-Russia Competition at the Nexus of Nuclear Weapons and Artificial Intelligence“.

Der Bericht identifiziert die größten Risiken des Zusammenhangs zwischen KI und Atomkraft und fordert die US-Regierung nachdrücklich auf, mit China und Russland umfassende Mechanismen zur Risikominderung und Krisenbewältigung zu entwickeln.

Zuvor hatten im September letzten Jahres rund 60 Länder, darunter die USA, auf dem Responsible AI in Military (REAIM)-Gipfel in Seoul, Südkorea, einen „Aktionsplan“ zur verantwortungsvollen Nutzung von KI im Militär verabschiedet. Dies ist die zweite Konferenz dieser Art, nachdem sie letztes Jahr in Den Haag stattfand. Diese Bewegungen zeigen, dass das Risiko eines durch KI ausgelösten Atomkriegs keine Science-Fiction ist.

Die Welt steht eindeutig vor einem immer dringlicheren existenziellen Problem, das echtes Handeln seitens der Atommächte erfordert, um sicherzustellen, dass „jede Entscheidung über den Einsatz von Atomwaffen von Menschen und nicht von Maschinen oder Algorithmen getroffen wird“ – wie UN-Generalsekretär Antonio Guterres gefordert hat.

Nguyen Khanh

![[Foto] Generalsekretär To Lam leitet die Ständige Sitzung des Zentralen Lenkungsausschusses zur Verhütung und Bekämpfung von Korruption, Verschwendung und Negativität](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/839ea9ed0cd8400a8ba1c1ce0728b2be)

![[Foto] Die Zeitung Nhan Dan feiert den 94. Jahrestag der Gründung der Kommunistischen Jugendunion Ho Chi Minh](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/5571705682934ac5be5014ce171facb4)

![[Foto] Verteidigungsminister leitet Inspektion der Parade- und Marschübung](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/35c2dd58a3e840d3a8cd615e70e89039)

Kommentar (0)