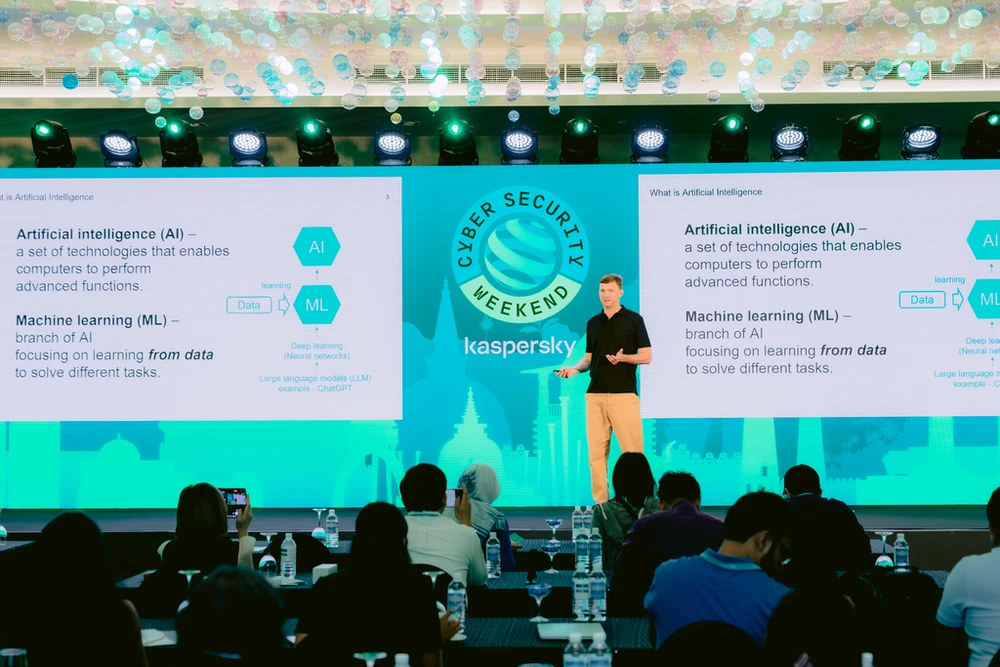

По мере того, как ИИ становится все более доступным, все больше людей и предприятий используют ИИ с помощью общих инструментов, хакеры также могут автоматизировать атаки, ускорять операции и развертывать более сложные кампании для достижения своих незаконных целей.

Вот типы атак, которые обнаружила компания «Лаборатория Касперского»: ChatGPT может использоваться для разработки вредоносного ПО и автоматического развертывания атак на несколько жертв; Программа ИИ проникает в данные пользователей на смартфонах и посредством анализа конфиденциальных данных злоумышленники могут полностью «читать» сообщения, пароли и банковские коды жертвы; Алгоритмы роевого интеллекта помогают автоматизированным компьютерным сетям (бонетам) восстанавливать вредоносные сети, которые были устранены с помощью решений по обеспечению безопасности.

Исследования «Лаборатории Касперского» по использованию ИИ для взлома паролей показывают, что большинство паролей шифруются с использованием алгоритмов хеширования, таких как MD5 и SHA. Соответственно, для преобразования пароля в строку зашифрованного текста требуется всего лишь простая операция, но обратный процесс представляет собой сложную задачу.

С помощью искусственного интеллекта злоумышленники могут использовать мошеннический контент, включая текст, изображения, аудио и видео, для проведения атак с использованием социальной инженерии. Большие языковые модели, такие как ChatGPT-4o, используются для создания сложнейших скриптов и сообщений. Преодолевая языковые барьеры, ИИ может написать настоящее электронное письмо, просто основываясь на информации в социальных сетях. ИИ может даже имитировать стиль письма жертвы. Это еще больше затрудняет обнаружение мошеннических действий.

В то же время Deepfake существует как «проблема» в кибербезопасности, хотя ранее он считался продуктом научных исследований. Наиболее распространенным методом является выдача себя за знаменитостей с целью получения финансовой выгоды. Далее мошенники также используют Deepfake для кражи аккаунтов, совершения поддельных звонков друзьям и родственникам жертв с целью присвоения имущества.

Помимо использования технологий ИИ в противозаконных целях, злоумышленники также могут атаковать алгоритмы ИИ. Такие как атаки «быстрого внедрения» путем ввода вредоносных команд в большие языковые модели, даже нарушающие ранее ограниченные правила; Сопернические атаки подразумевают добавление скрытых информационных полей к изображениям или аудиоданным с целью повлиять на способность системы машинного обучения классифицировать изображения.

ИИ постепенно интегрируется во все аспекты жизни человека: от Apple Intelligence, Google Gemini до Microsoft Copilot. Поэтому устранение уязвимостей ИИ должно стать главным приоритетом. «Лаборатория Касперского» уже много лет использует технологию искусственного интеллекта для защиты клиентов и партнеров, постоянно ищет уязвимости в системах искусственного интеллекта, чтобы повысить их устойчивость, а также активно исследует методы кибератак для предоставления надежных решений по защите от атак искусственного интеллекта.

КИМ ТХАНЬ

Источник: https://www.sggp.org.vn/nhieu-thach-thuc-cua-ai-trong-thoi-dai-moi-post754401.html

![[Фото] Сезон шелковицы Фук Тхо – сладкие фрукты из экологически чистого сельского хозяйства](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/1710a51d63c84a5a92de1b9b4caaf3e5)

![[Фото] Премьер-министр Фам Минь Чинь председательствует на совещании, на котором обсуждаются налоговые решения для импортируемых и экспортируемых товаров Вьетнама](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/19b9ed81ca2940b79fb8a0b9ccef539a)

![[Фото] Уникальные народные игры на фестивале в деревне Чуонг](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/cff805a06fdd443b9474c017f98075a4)

Комментарий (0)