딥페이크 영상을 제작하기 위한 인공 도구에 대한 접근성이 매우 제한적이었던 이전 시기와 대조적으로, Grok, ChatGPT, Meta AI, Gemeni, DeepSeek 등 많은 AI 도구가 널리 출시되어 이미지 생성을 포함한 기본 기능을 무료로 사용할 수 있습니다. 사용자는 전문적인 처리 기술을 이해할 필요 없이 원하는 모양을 만들거나 자르고 편집할 수도 있습니다. 이로 인해 엔터테인먼트부터 인터넷 상의 위협에 이르기까지 다양한 목적으로 얼굴을 만드는 데 AI를 사용하는 경우가 증가했습니다.

YN 씨(호치민시 1군)는 한때 사람들을 위협하기 위해 AI 기반 이미지 조작의 희생자가 되었으며, 모든 데이터가 인공지능 도구로 생성되었음에도 불구하고 "민감한" 데이터를 회수하려면 많은 돈을 지불해야 했다고 말했습니다. 구체적으로 범죄자들은 그녀의 개인 사진을 수집하고 얼굴을 편집하여 나쁜 내용으로 만들고, 민감한 채팅을 만든 뒤 YN 씨를 찾아가 그녀를 협박했습니다.

범죄자들은 AI를 이용해 피해자를 편집하고, 자르고, 협박합니다.

"그들은 그들이 만든 가짜 채팅, 이미지, 비디오의 스크린샷을 보여주며 콘텐츠를 삭제하기 위해 1억 VND를 요구했습니다. 합성 이미지가 진짜인지 가짜인지 알아볼 수 없다는 것을 인정해야 합니다." 피해자는 공유하며 위의 행동을 당국에 신고했다고 덧붙였습니다.

YN 씨의 사례는 악의적인 목적으로 AI와 이미지 편집 도구를 남용하는 최근의 많은 사건 중 하나에 불과합니다. 현재 베트남의 소셜 네트워크 사용자들은 정보 보안 분야 전문가들이 이 문제에 대해 경고했음에도 불구하고 여전히 개인 이미지, 친구 및 가족을 온라인과 공개적으로 공유하는 데 매우 "걱정하지 않는" 태도를 보이고 있습니다.

최근 공안부는 인터넷에 공개적으로 게재된 사람들의 사진과 영상을 이용해 편집, 편집하고, 합성해 민감한 내용을 만든 뒤 위협과 협박 목적으로 이용하는 범죄자들이 등장했다며 휴대전화 사용자들에게 경고했다. "사람들은 위와 같은 내용이 담긴 메시지나 전화를 받을 때 경계하고, 위협을 받을 때는 돈을 송금하지 않도록 권고합니다. 사기나 재산 강탈의 징후를 발견하면 가장 가까운 경찰서에 신속히 신고하고 VNeID 애플리케이션을 통해 신고해야 합니다."라고 공지문에 나와 있습니다.

협박의 목적 외에도 범죄자는 피해자의 공개된 개인 사진과 영상을 다수 이용해 가짜 콘텐츠를 만들어 직장 내 평판을 훼손하고, 개인적인 복수를 감행하고, 정신과 명예를 훼손할 수도 있습니다. 주목할 점은 이러한 위조 문서가 점점 더 정교해지고 일반인과 인공지능 분야에 관심이 있는 사람 모두가 구별하기 어려워지고 있다는 것입니다.

판매를 지원하는 AI 챗봇 개발을 전문으로 하는 폴란드 회사인 티디오가 작년 말에 실시한 연구에 따르면, 대부분의 인터넷 사용자는 AI가 만든 이미지를 구별하는 데 점점 더 어려움을 겪고 있는 것으로 나타났습니다. 이 회사는 참가자 중 최대 87%가 AI 사진을 실제 사람 사진과 혼동했다고 주장합니다. 또한 응답자의 62%는 AI와 머신러닝에 관심을 표명했지만, 이 그룹 중 절반은 인공지능이 생성한 이미지를 올바르게 식별하지 못했습니다.

현재 사이버 범죄에 AI를 활용하는 것에 대한 구체적인 규정은 없지만, 다른 사람의 이미지를 사용하여 위협하거나, 협박하거나, 허위 정보를 퍼뜨리는 것은 다른 사람을 모욕하는 범죄, 재물 갈취 범죄, 음란 문화 산물 퍼뜨리는 범죄와 관련된 조항에 따라 여전히 처리될 수 있습니다.

이러한 상황에 직면하여 전문가들은 사용자가 소셜 네트워크에 개인 이미지를 공유할 때 주의해야 하며, 보안 도구를 사용하여 개인 정보를 관리해야 한다고 권고합니다.

[광고2]

출처: https://thanhnien.vn/canh-giac-ke-xau-loi-dung-ai-ghep-mat-nan-nhan-de-de-doa-tong-tien-185241107153341681.htm

![[사진] “베트남 경제에서 민간경제의 역할을 촉진하기 위한 정책적 단점 제거” 워크숍 개요](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/d1c58c1df227467b8b33d9230d4a7342)

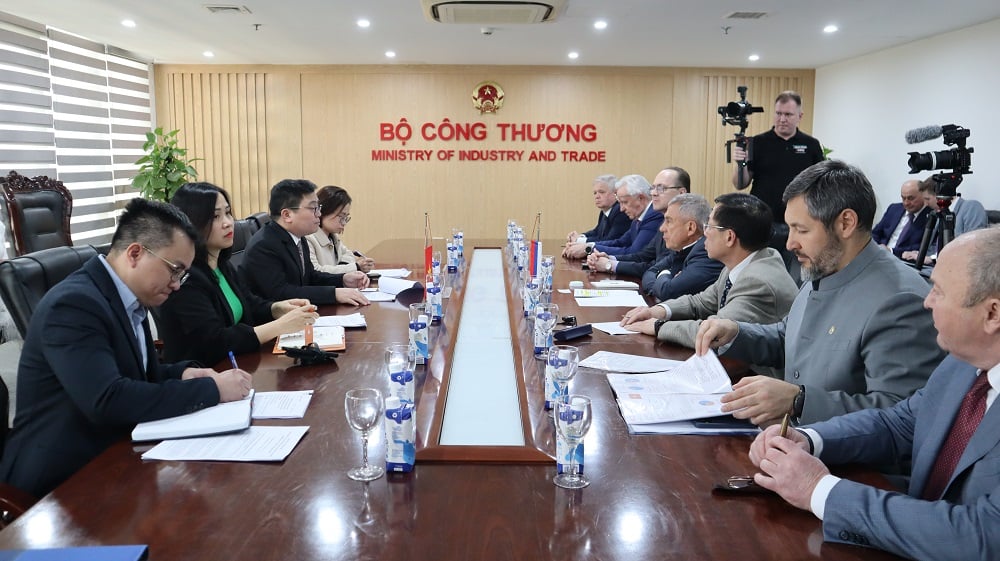

![[사진] 팜민친 총리, 러시아 연방 타타르스탄 공화국 수반 접견](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/21/7877cb55fc794acdb7925c4cf893c5a1)

댓글 (0)