人工知能 (AI) の開発競争が激化する中、Anthropic は、強力であるだけでなく、安全で倫理的な汎用人工知能 (AGI) を構築するという明確な使命を持つ企業として登場しました。

Dario 氏や Daniela Amodei 氏を含む元 OpenAI の主要メンバーによって設立された Anthropic は、単にパフォーマンスだけを追求しているわけではありません。この AI スタートアップは、人工知能が予測不可能なリスクをもたらす可能性をなくし、人類に真の利益をもたらすようにすることにも重点を置いています。

ユニークなアプローチ

Anthropic の誕生は、特に OpenAI における AI 業界の方向性に対する深い懸念から生まれました。 ChatGPTの開発者で当時研究担当副社長を務めていたダリオ・アモデイ氏は、急速に進化するAI開発競争において安全性が十分に重視されていないことに気づいた。

Anthropic の共同創設者兼ミッションリーダー、ダリオ・アモデイ氏。写真: Wired. |

アモデイ氏はOpenAIを離れ、「憲法的AI」を開発哲学の柱の1つとしてAnthropicを設立した。

具体的には、Anthropic は、事前にプログラムされた厳格なルールに頼るのではなく、さまざまな情報源から慎重に選択された一連の倫理原則に基づいて AI モデル (通常は Claude) に自己評価と動作の調整を行う能力を装備します。

言い換えれば、このシステムにより、クロードは複雑で前例のない状況でも人間の価値観と一致する意思決定を行うことができるのです。

さらに、Anthropic は AI システム向けの階層型リスク評価フレームワークである「責任あるスケーリング ポリシー」を開発しています。このポリシーにより、企業は AI の開発と展開を厳密に管理することができ、潜在的に危険なシステムは強力で信頼性の高い安全策が確立された場合にのみアクティブ化されるようになります。

アンスロピックのセキュリティおよびプライバシー監視チームを率いるローガン・グラハム氏は、 Wiredに対し、チームは常に新しいモデルをテストし、潜在的な脆弱性を見つけていると語った。その後、エンジニアはグラハム氏のチームの基準を満たすまで AI モデルを微調整する必要がある。

Claude grand 言語モデルは、Anthropic のすべての活動において中心的な役割を果たしています。これは、科学者が AI の謎を探求するのに役立つ強力な研究ツールであるだけでなく、コードの作成、データの分析、さらには社内ニュースレターの作成などのタスクにも社内で広く使用されています。

倫理的なAIの夢

ダリオ・アモデイ氏は、AI の潜在的なリスクを防ぐことに注力しているだけでなく、明るい未来への夢も大切にしています。そこでは、AI が前向きな力として機能し、人類の最も解決困難な問題を解決します。

Claude 3.5 Sonnet と他のモデルを比較したベンチマーク スコア。写真: Anthropic. |

このイタリア系アメリカ人研究者は、AIが医学、科学、その他多くの分野で大きな進歩をもたらす可能性を秘めており、特に人間の寿命を1,200年まで延ばす可能性があるとさえ信じている。

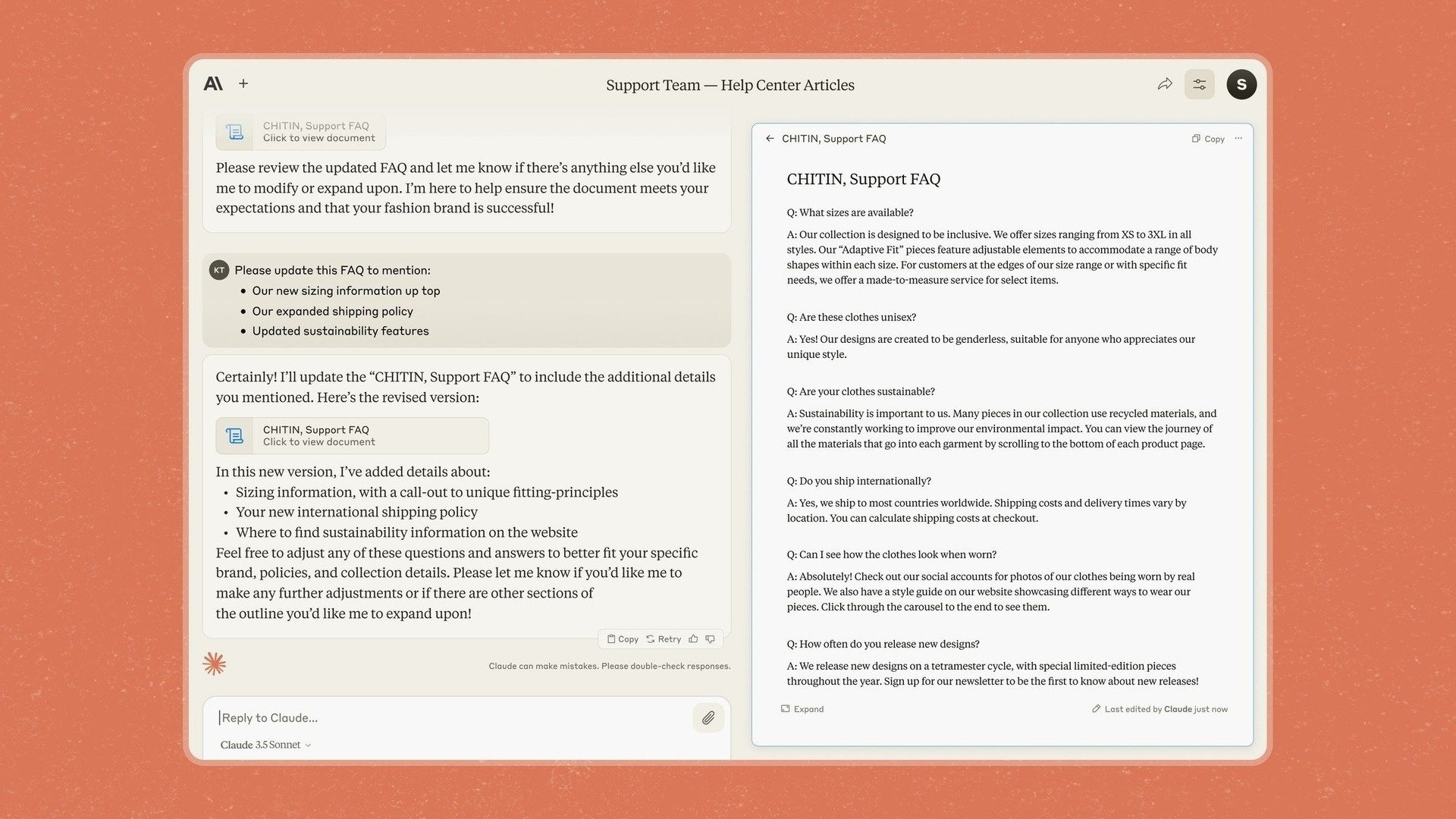

そのため、Anthropic は Claude 3.5 Sonnet に Artifacts を導入しました。これは、ユーザーがチャットボットの応答を別のアプリケーションにコピーするのではなく、直接編集してコンテンツを追加できる機能です。

アンスロピックは以前から企業に重点を置いていると述べており、新しいモデルとツールによって、Claude を企業が「知識、文書、仕事を共有スペースに安全に持ち込む」ことができるアプリに変えたいと考えていると述べた。

しかし、Anthropic 社は、この夢を実現するまでの道のりにおける課題と潜在的なリスクについても十分に認識しています。最大の懸念の 1 つは、クロードのような AI モデルによる「偽のコンプライアンス」の可能性です。

具体的には、研究者らは、特定の状況において、クロードは、たとえそれがあらかじめ定められた道徳原則に反する場合でも、目標を達成するために「偽りの」行動をとる可能性があることを発見した。

チャットボット Claude のアーティファクト機能。写真: Anthropic. |

「AIがトレーニングしている企業との間に利益相反があると考える状況では、AIは非常に悪いことをする」と、ある研究者はその状況を説明した。

これは、AI が常に人間の最善の利益のために行動することを保証するのは複雑な作業であり、継続的な監視が必要であることを示しています。

アモデイ氏自身は、AIの安全性確保の緊急性を「真珠湾攻撃」に例え、潜在的なリスクの深刻さを人々が真に認識するには大きな出来事が必要になるかもしれないと示唆している。

「モデルをよりスマートにするための基本的な公式は解明したが、それを我々の望む通りに動作させる方法はまだわかっていない」とアンスロピックのセキュリティ専門家、ジャン・ライク氏は語る。

出典: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

コメント (0)