Selon le ministère des Sciences et de la Technologie, suivant la tendance générale dans le monde, les systèmes d'intelligence artificielle devraient apporter de grands avantages aux personnes, à la société et à l'économie vietnamienne en soutenant et en résolvant les problèmes difficiles auxquels les personnes et la communauté sont confrontées. Parallèlement à ce processus, il est nécessaire de rechercher et de prendre des mesures pour minimiser les risques dans le processus de développement et d’utilisation de l’intelligence artificielle et d’équilibrer les facteurs économiques, éthiques et juridiques qui y sont liés. Les agences professionnelles doivent donc rechercher et développer des normes et des lignes directrices pour les guider, même s’il s’agit de réglementations souples et non contraignantes.

Dans ces lignes directrices, le ministère de la Science et de la Technologie définit neuf principes pour une recherche et un développement responsables des systèmes d’intelligence artificielle.

Premièrement, il y a l’esprit de coopération, qui favorise l’innovation : les développeurs doivent tenir compte de la connectivité et de l’interopérabilité entre leurs systèmes d’intelligence artificielle et d’autres systèmes d’intelligence artificielle en considérant la diversité des systèmes pour améliorer les avantages du système, tout en améliorant la coordination pour contrôler les risques.

Deuxièmement, la transparence : les systèmes d’intelligence artificielle qui suivent ce principe sont souvent des systèmes qui peuvent affecter la vie, le corps, la vie privée ou la propriété des utilisateurs ou des tiers concernés. Les développeurs doivent ensuite prêter attention à la capacité d’identifier clairement les entrées et les sorties du système ainsi que l’explicabilité associée en fonction des caractéristiques de la technologie appliquée et de la manière dont elles sont utilisées pour garantir la confiance de la société, y compris des utilisateurs.

Troisièmement, la contrôlabilité : pour évaluer les risques associés à la contrôlabilité du système, les développeurs doivent procéder à une évaluation préalable pour déterminer si le système répond aux exigences techniques et aux normes pertinentes. Une méthode d’évaluation des risques consiste à effectuer des tests dans un espace séparé avec des mesures de sécurité en place avant de les mettre en pratique.

Quatrièmement, le principe de sécurité : les développeurs doivent s’assurer que le système d’intelligence artificielle ne causera pas de dommages à la vie, au corps ou aux biens des utilisateurs ou de tiers, y compris par l’intermédiaire d’intermédiaires.

5. Principes de sécurité : En plus de se conformer aux documents, aux instructions et de mettre en œuvre les mesures de sécurité de l'information prescrites, les développeurs doivent prêter attention à des points tels que : La fiabilité et la résistance aux attaques physiques ou aux accidents du système ; sécurité; intégrité; et la disponibilité des informations nécessaires liées à la sécurité de l’information du système…

6. Confidentialité : les développeurs doivent s’assurer que les systèmes d’intelligence artificielle ne violent pas la vie privée des utilisateurs ou des tiers. La confidentialité comprend la confidentialité spatiale (tranquilité d’esprit dans la vie personnelle), la confidentialité des informations (données personnelles) et la confidentialité des communications. Les développeurs doivent appliquer les réglementations et les directives en vigueur ; Les normes et directives internationales en matière de confidentialité peuvent être consultées.

Les développeurs doivent procéder à une pré-évaluation des risques liés à la confidentialité et à une pré-évaluation des impacts sur la confidentialité. Dans la mesure du possible, prendre des mesures adaptées aux caractéristiques de la technologie appliquée lors du développement du système pour éviter toute atteinte à la vie privée lors de sa mise en service.

Septièmement, le respect des droits de l’homme et de la dignité : lors du développement de systèmes d’intelligence artificielle impliquant des humains, les développeurs doivent veiller particulièrement à respecter les droits de l’homme et la dignité des personnes concernées. Dans la mesure du possible, en fonction des caractéristiques de la technologie appliquée, les développeurs doivent prendre des mesures pour garantir qu’ils ne provoquent pas de discrimination ou d’injustice en raison de biais dans les données lors de la formation du système.

Les développeurs doivent prendre des précautions pour garantir que le système ne viole pas les valeurs humaines et l'éthique sociale selon les principes fondamentaux du Vietnam (par exemple, les valeurs telles que le patriotisme, la solidarité, l'autonomie, la loyauté, l'honnêteté, la responsabilité, la discipline, la créativité, etc.).

8ème, support utilisateur : Pour soutenir les utilisateurs, les développeurs de systèmes doivent prêter attention à des points tels que : Créer des interfaces prêtes à l'emploi pour fournir des informations opportunes et pertinentes pour aider les utilisateurs à prendre des décisions et à les utiliser de manière pratique ; prendre des mesures pour rendre le système plus facile à utiliser pour les membres vulnérables de la société (personnes âgées, handicapées)….

9. Responsabilité : les développeurs doivent assumer la responsabilité des systèmes qu’ils développent pour garantir la confiance des utilisateurs. Il est notamment nécessaire de fournir aux utilisateurs des informations pour les aider à sélectionner et à utiliser le système. De plus, pour accroître l’acceptation sociale des systèmes, les développeurs devraient faire davantage : fournir aux utilisateurs des informations et des descriptions des caractéristiques techniques des systèmes qu’ils développent, des algorithmes, des mécanismes de sécurité, etc. écouter les points de vue et dialoguer avec les parties prenantes.

Source : https://nhandan.vn/nghien-cuu-phat-trien-cac-he-thong-tri-tue-nhan-tao-co-trach-nhiem-post814609.html

![[Photo] Gros plan d'un vieil immeuble d'appartements en attente de rénovation](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/bb2001a1b6fe478a8085a5fa20ef4761)

![[Photo] Le chef de la Commission centrale de propagande et de mobilisation de masse, Nguyen Trong Nghia, travaille avec les principales agences de presse politiques](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/3020480dccf043828964e896c43fbc72)

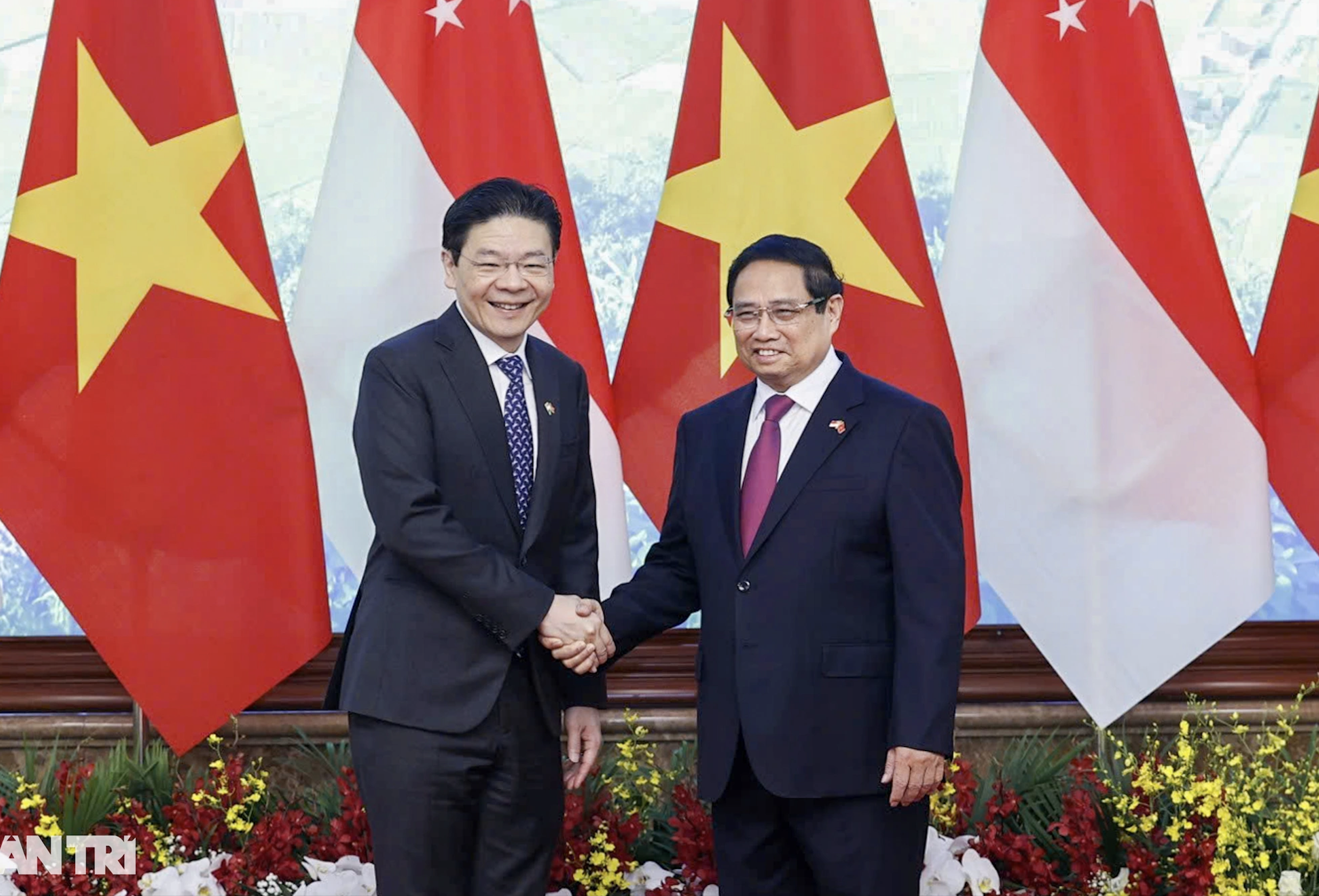

![[Photo] Cérémonie d'accueil du Premier ministre de la République de Singapour, Lawrence Wong, en visite officielle au Vietnam](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/445d2e45d70047e6a32add912a5fde62)

![[Infographie] La formation continue vise à créer un écosystème éducatif flexible et durable](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/2b0424e11a334548a8cbddc53dc39cf8)

Comment (0)