Генеральный директор Truepic Джеффри МакГрегор заявил, что инцидент — лишь вершина айсберга. Г-н Макгрегор заявил, что в социальных сетях будет много контента, создаваемого искусственным интеллектом, и мы к этому не готовы.

По данным CNN, Truepic хочет решить эту проблему, предоставив технологию, которая, как утверждается, проверяет подлинность медиафайлов на момент их создания с помощью Truepic Lens. Приложение для сбора данных сообщит пользователям дату, время, место и устройство, использованное для создания изображения, а также применит цифровую подпись, чтобы проверить, является ли изображение естественным или создано с помощью искусственного интеллекта.

Поддельное фото взрыва в Пентагоне стало вирусным в Twitter

Truepic, компания, основанная в 2015 году и поддерживаемая Microsoft, заявила, что видит интерес со стороны неправительственных организаций, медиакомпаний и даже страховщиков, желающих подтвердить законность претензий.

Макгрегор заявил, что когда все можно будет подделать, когда искусственный интеллект достигнет пика качества и доступности, мы больше не будем знать, какая реальность существует в сети.

Такие технологические компании, как Truepic, уже много лет борются с дезинформацией в Интернете. Однако появление нового поколения инструментов искусственного интеллекта, способных генерировать изображения и текстовые материалы по командам пользователя, сделало эту задачу еще более актуальной. Ранее в этом году широко распространились фейковые фотографии Папы Франциска в пуховике Balenciaga и бывшего президента США Дональда Трампа во время ареста. Оба инцидента оставили миллионы людей в недоумении относительно потенциальных опасностей ИИ.

Некоторые законодатели теперь призывают технологические компании решить эту проблему путем маркировки контента, созданного с помощью ИИ. Вице-президент Европейской комиссии (ЕК) Вера Юрова заявила, что такие компании, как Google, Meta, Microsoft и TikTok, присоединились к добровольному кодексу правил Европейского союза (ЕС) по борьбе с дезинформацией.

Все большее число стартапов и технологических гигантов, включая те, которые внедряют генеративный ИИ в свои продукты, пытаются внедрить стандарты и решения, которые помогут людям определить, было ли изображение или видео создано с помощью ИИ.

Однако поскольку технологии искусственного интеллекта развиваются быстрее, чем люди могут за ними угнаться, неясно, смогут ли эти решения полностью решить проблему. Даже компания OpenAI, стоящая за Dall-E и ChatGPT, признала, что ее собственные усилия по обнаружению текстов, созданных ИИ, несовершенны.

Компании, занимающиеся разработкой решений, используют два подхода к решению этой проблемы. Первый вариант предполагает разработку программ для идентификации изображений, созданных с помощью ИИ, после их создания и публикации в Интернете. Другой метод фокусируется на маркировке изображения как реального или сгенерированного искусственным интеллектом с помощью некой цифровой подписи.

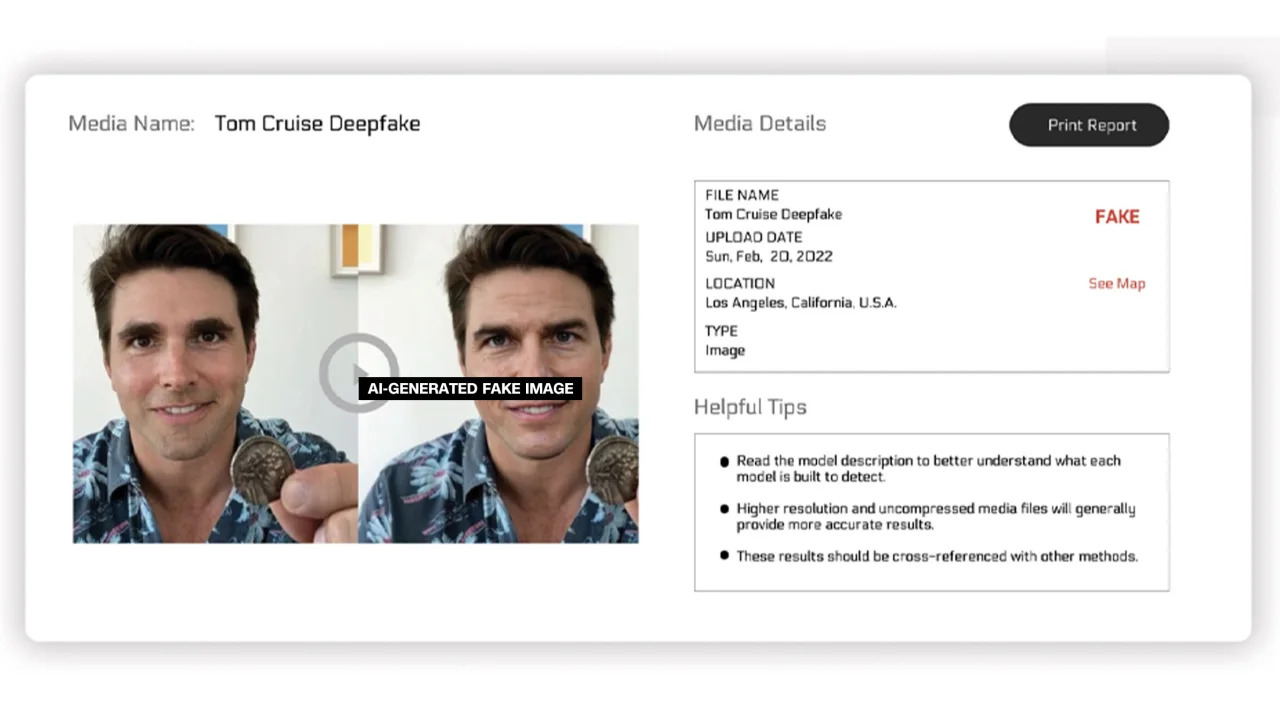

Reality Defender и Hive Moderation работают над первым подходом. С помощью их платформы пользователи могут загружать изображения для сканирования, а затем получать анализ, показывающий процентное соотношение, указывающее, является ли фотография реальной или сгенерированной искусственным интеллектом.

Reality Defender утверждает, что компания использует запатентованную технологию deepfake и генеративного контента для обнаружения видео, аудио и изображений, созданных с помощью ИИ. В примере, предоставленном компанией, Reality Defender показала фейковое изображение Тома Круза, которое на 53% было оценено как «подозрительное», поскольку у человека на изображении было искаженное лицо, что часто встречается на отредактированных фотографиях.

Генерируемые искусственным интеллектом маркированные изображения

Эти сервисы предлагают бесплатные и платные версии. По данным Hive Moderation, за 1000 изображений взимается плата в размере 1,50 доллара. В Realty Defender утверждают, что цены на их продукцию могут варьироваться в зависимости от различных факторов, в случае если клиенту потребуется экспертиза и поддержка компании. Генеральный директор Reality Defender Бен Колман говорит, что риск удваивается с каждым месяцем, поскольку любой может создавать поддельные фотографии, используя инструменты искусственного интеллекта.

Несколько других компаний работают над интеграцией в изображения особого типа меток, которые будут подтверждать, являются ли они реальными или созданы с помощью искусственного интеллекта. До сих пор эти усилия в значительной степени направлялись Альянсом по подлинности и происхождению контента (C2PA).

Ассоциация C2PA была основана в 2021 году с целью создания технического стандарта для сертификации происхождения и истории цифровых медиа, объединяющего инициативу Adobe Content Authentication Initiative (CAI) и проект Origin, возглавляемый Microsoft и BBC, с упором на борьбу с дезинформацией в цифровых новостях. В C2PA также участвуют такие компании, как Truepic, Intel и Sony.

Основываясь на принципах C2PA, CAI предоставит компаниям инструменты с открытым исходным кодом для создания учетных данных контента или метаданных, содержащих информацию об изображениях. По данным сайта CAI, это позволяет создателям открыто делиться подробностями о том, как они создали изображение. Таким образом, конечные пользователи могут получить доступ к контексту того, кто, что и как изменил изображение, а затем самостоятельно оценить, насколько оно подлинное.

Многие компании интегрировали стандарт C2PA и инструменты CAI в свои приложения. Firefly от Adobe — новый инструмент обработки изображений на базе искусственного интеллекта, добавленный в Photoshop, соответствует стандарту C2PA благодаря функции «Учетные данные контента». Компания Microsoft также объявила, что в ближайшие месяцы изображения и видео, созданные с помощью Bing Image Creator и Microsoft Designer, будут содержать криптографические подписи.

В мае Google анонсировала функцию «Об этом изображении», которая позволяет пользователям узнать, когда изображение впервые появилось в Google и где его можно увидеть. Поисковый гигант также объявил, что каждое изображение, сгенерированное искусственным интеллектом Google, будет содержать разметку в исходном файле для «добавления контекста», если изображение будет найдено на другом веб-сайте или платформе.

В то время как технологические компании пытаются решить проблемы, связанные с изображениями, созданными с помощью искусственного интеллекта, и целостностью цифровых медиа, эксперты в этой области подчеркивают, что для решения этой проблемы компаниям необходимо будет работать сообща и совместно с правительствами. Тем не менее, технологические компании спешат разрабатывать ИИ, несмотря на риски.

Ссылка на источник

Комментарий (0)