Ученые из Университета Илона провели масштабное исследование, опросив сотни экспертов в области технологий, чтобы понять потенциальное влияние ИИ на человечество. Ответ сопровождается мрачным предупреждением: многие технические эксперты опасаются, что ИИ ухудшит такие базовые навыки, как эмпатия и глубокое мышление.

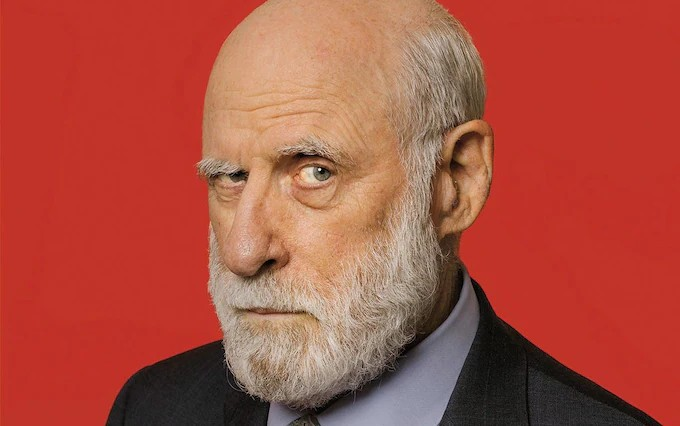

Отчет под названием «Будущее человечества» объемом около 300 страниц был опубликован 4 апреля. В нем представлен анализ от 301 лидера в области технологий, включая Винта Серфа, одного из «отцов Интернета» и в настоящее время вице-президента Google.

В своем эссе для Университета Илона футуролог Джон Смарт выражает обеспокоенность тем, что, хотя небольшая группа людей будет получать все большую выгоду от инструментов ИИ, большинство людей откажутся от самостоятельности, креативности, принятия решений и других важных навыков в пользу несовершенного ИИ.

Гонка за развитие ИИ в настоящее время привлекает миллиарды долларов инвестиций от крупных корпораций, таких как Google, Microsoft и Meta, с целью создания «агентов ИИ», способных заменить людей во многих задачах. Однако в докладе Университета Илона ставится под сомнение, сбудутся ли на самом деле обещания о том, что ИИ освободит людей от рутинных задач, позволив им сосредоточиться на творчестве. Недавние исследования Microsoft и Университета Карнеги — Меллона также показывают, что использование инструментов генеративного ИИ может ухудшить навыки критического мышления человека.

Более 60% опрошенных экспертов прогнозируют, что в течение следующего десятилетия ИИ изменит возможности человека «глубоко и значимо» или «фундаментально, революционно». Однако только 16% полагают, что изменения будут в основном положительными, тогда как 23% прогнозируют, что негативные последствия будут преобладать, а остальные видят равные преимущества и недостатки.

Участники опроса также предсказали, что 12 качеств, таких как эмоциональный интеллект, эмпатия, моральное суждение и психическое здоровье, к 2035 году существенно ухудшатся, если люди будут все больше полагаться на ИИ для решения личных и социальных проблем.

В интервью CNN Винт Серт сказал, что вскоре люди будут полагаться на «агентов ИИ» во всем: от ведения заметок на совещаниях до заказа ужина, заключения контрактов или программирования. Однако он опасается, что помимо экономии времени и энергии люди станут зависимыми от ИИ, даже несмотря на то, что системы вполне могут совершать ошибки. Он также призвал к прозрачности в разработке ИИ, включая создание «контрольных журналов» для выявления и исправления ошибок ИИ.

Тем временем Трейси Фоллоуз, генеральный директор Futuremade, прогнозирует, что ИИ не ограничится только чат-ботами на экранах, но и интегрируется в повседневную жизнь через носимые устройства и жилые помещения.

Однако она опасается, что люди могут передать даже гуманистические действия, такие как сочувствие или эмоциональная поддержка, ИИ. «Люди могут формировать эмоциональную привязанность к персонажам ИИ, что вызывает опасения относительно того, не будут ли реальные отношения заменены более контролируемыми цифровыми связями», — пишет Фоллоуз.

Однако в отчете отмечены и некоторые позитивные перспективы. Эксперты ожидают, что ИИ будет способствовать развитию любопытства и способности учиться, принимать решения и мыслить творчески. Современные инструменты ИИ продемонстрировали потенциал в создании произведений искусства или решении задач программирования, открывая новые типы профессий в будущем.

Учитывая изменения, которые несет с собой ИИ, эксперты подчеркивают, что еще есть время направить эту технологию в позитивном направлении посредством регулирования, цифровой «неграмотности» и, проще говоря, приоритизации человеческих отношений.

(По данным CNN)

Источник: https://vietnamnet.vn/cha-de-internet-lo-ngai-con-nguoi-qua-phu-thuoc-ai-2387979.html

![[Фото] «Красавицы» участвуют в репетиции парада в аэропорту Бьенхоа](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

Комментарий (0)