កាលពីពេលថ្មីៗនេះ នាយកដ្ឋានសន្តិសុខព័ត៌មានបានចេញការព្រមានមួយ ទាក់ទងនឹងការបន្តកើតមានឡើងវិញនៃការលួចបន្លំវីដេអូ និងរូបភាពបច្ចេកវិទ្យាខ្ពស់។

អាស្រ័យហេតុនេះ ស្ថានភាពនៃឧក្រិដ្ឋជនតាមប្រព័ន្ធអ៊ីនធឺណេត ឆ្លៀតយករូបភាព និងវីដេអូសាធារណៈរបស់ប្រជាពលរដ្ឋ ដើម្បីកែសម្រួល កាត់ត និងគំរាមកំហែង បំប្លែងសារជាវីដេអូក្លែងក្លាយ ត្រូវបានអាជ្ញាធរព្រមានយ៉ាងទូលំទូលាយដល់សាធារណជន។

ដោយប្រើបច្ចេកវិទ្យា Deepfake ដែលអនុញ្ញាតឱ្យបង្កើតឡើងវិញនូវសំឡេង និងរូបភាពរបស់មនុស្សជាមួយនឹងភាពត្រឹមត្រូវខ្ពស់ ឧក្រិដ្ឋជនអាចក្លែងខ្លួនជាអ្នកដឹកនាំនៅក្នុងការប្រជុំតាមអ៊ីនធឺណិត ឬបង្កើតវីដេអូ និងការហៅទូរស័ព្ទដើម្បីប្រព្រឹត្តការក្លែងបន្លំផ្នែកហិរញ្ញវត្ថុ។

ជាងនេះទៅទៀត ការបោកប្រាស់ទាំងនេះតែងតែកេងប្រវ័ញ្ចលើកត្តាផ្លូវចិត្តដូចជា ភាពបន្ទាន់ ការភ័យខ្លាច ឬអំណាច ដែលបណ្តាលឱ្យជនរងគ្រោះធ្វើសកម្មភាពយ៉ាងប្រញាប់ប្រញាល់ ដោយមិនពិនិត្យដោយប្រុងប្រយ័ត្ននូវភាពត្រឹមត្រូវ។

Deepfakes មិនត្រូវបានកំណត់ចំពោះការបោកប្រាស់វិនិយោគហិរញ្ញវត្ថុទេ។ ឧទាហរណ៍មួយទៀតគឺការបោកប្រាស់ស្នេហា ដែល Deepfakes ត្រូវបានប្រើដើម្បីបង្កើតតួអង្គប្រឌិតដែលមានទំនាក់ទំនងជាមួយជនរងគ្រោះតាមរយៈការហៅជាវីដេអូ។ បន្ទាប់ពីទទួលបានការទុកចិត្តពីជនរងគ្រោះ អ្នកបោកប្រាស់នឹងស្នើសុំការផ្ទេរប្រាក់ដើម្បីរ៉ាប់រងការសង្គ្រោះបន្ទាន់ ការចំណាយលើការធ្វើដំណើរ ឬប្រាក់កម្ចី។

ជុំវិញស្ថានភាពខាងលើនេះ នាយកដ្ឋានសន្តិសុខព័ត៌មាន ណែនាំឲ្យប្រជាពលរដ្ឋប្រុងប្រយ័ត្នចំពោះដំបូន្មានវិនិយោគពីតារាល្បីៗលើបណ្ដាញសង្គម។ ប្រយ័ត្នចំពោះអត្ថបទ អ៊ីមែល ឬការហៅទូរសព្ទដែលមិនស្គាល់។ មើលឱ្យជិតសម្រាប់ការបញ្ចេញទឹកមុខខុសពីធម្មជាតិនៅក្នុងវីដេអូ។

មនុស្សក៏ត្រូវកំណត់ការបង្ហោះខ្លឹមសារទាក់ទងនឹងព័ត៌មានផ្ទាល់ខ្លួននៅលើបណ្តាញសង្គមផងដែរ ដើម្បីជៀសវាងករណីជនខិលខូចលួចព័ត៌មានដូចជារូបភាព វីដេអូ ឬសំឡេង។ ដូចគ្នានេះផងដែរ កំណត់គណនីរបស់អ្នកទៅជាឯកជនដើម្បីការពារព័ត៌មានផ្ទាល់ខ្លួនរបស់អ្នក។

ពិភាក្សាជាមួយ PV នៃកាសែត Dai Doan Ket អ្នកជំនាញសន្តិសុខអ៊ីនធឺណិត លោក Ngo Minh Hieu សហស្ថាបនិកនៃគម្រោងទប់ស្កាត់ការក្លែងបន្លំតាមអ៊ីនធឺណិតវៀតណាម (Chongluadao.vn) បាននិយាយថា ការប្រើប្រាស់បច្ចេកវិទ្យា Deepfake (ក្លែងធ្វើយ៉ាងស៊ីជម្រៅ) ក្នុង AI ដើម្បីក្លែងបន្លំការហៅជាវីដេអូសម្រាប់គោលបំណងនៃការក្លែងបន្លំនៅតែមានភាពស្មុគស្មាញ។ មុខវិជ្ជាប្រើប្រាស់បច្ចេកវិទ្យានេះ ដើម្បីបង្កើនភាពជឿជាក់នៃ "សត្វព្រៃ" របស់ពួកគេ។

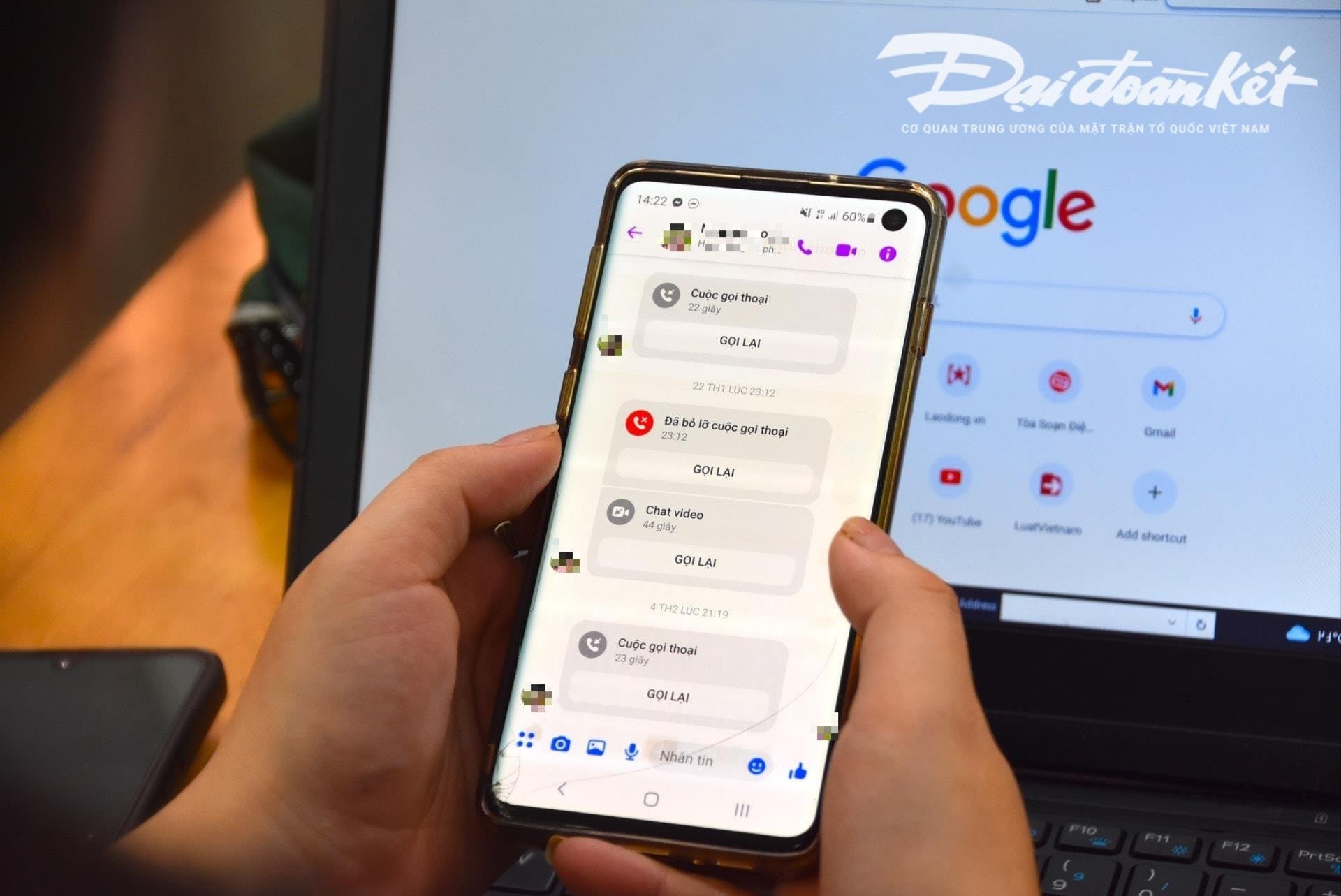

ជាពិសេស ប្រធានបទនឹងធ្វើការហៅជាវីដេអូយ៉ាងសកម្មទៅកាន់ជនរងគ្រោះពីរូបភាព និងវីដេអូដែលបាន "លួច" ពីមុន ហើយដំណើរការវាតាមបច្ចេកទេស បង្ខូចទ្រង់ទ្រាយសំឡេង ឬបញ្ហារូបភាពក្លែងក្លាយ ដើម្បីទទួលបានការជឿទុកចិត្តពីជនរងគ្រោះ។

ជាធម្មតា ការហៅទូរសព្ទទាំងនេះមានរយៈពេលខ្លីណាស់ មានរយៈពេលតែប៉ុន្មានវិនាទីប៉ុណ្ណោះ បន្ទាប់មកអ្នកបោកប្រាស់ប្រើលេសនៃបណ្តាញមិនស្ថិតស្ថេរ ការនៅតាមផ្លូវជាដើម ដើម្បីសុំឱ្យជនរងគ្រោះបំពេញតាមសំណើរបស់អ្នកបោកប្រាស់។

អ្នកជំនាញព្រមានថាការប្រើប្រាស់ AI សម្រាប់ការក្លែងបន្លំតាមអ៊ីនធឺណិតទំនងជានឹងកើនឡើងយ៉ាងខ្លាំងនាពេលអនាគតដ៏ខ្លីខាងមុខនេះ។ ដូច្នេះ ប្រជាពលរដ្ឋត្រូវបង្កើនការប្រុងប្រយ័ត្ន។ ជាពិសេសនៅពេលទទួលបានសារចម្លែក ការហៅជាវីដេអូ តំណភ្ជាប់។

យោងតាមការវិភាគរបស់អ្នកជំនាញនេះ ក្បួនដោះស្រាយ Deepfake Artificial Intelligence (AI) បច្ចុប្បន្នក្នុងអំឡុងពេលហៅទូរសព្ទតាមពេលវេលាជាក់ស្តែងនឹងមិនអាចគ្រប់គ្រងវាបាន ប្រសិនបើអ្នកហៅទូរសព្ទបត់ឆ្វេង បត់ស្តាំ ឬក្រោកឈរឡើង...

ចំណុចខ្សោយពិសេសមួយដែលមនុស្សត្រូវដឹងនៅពេលទទួលការហៅទូរសព្ទទាំងនេះគឺធ្មេញរបស់ពួកគេ។ អាស្រ័យហេតុនេះ ក្បួនដោះស្រាយ AI បច្ចុប្បន្នមិនអាចបង្កើតធ្មេញរបស់បុគ្គលដែលត្រូវបានក្លែងបន្លំបានទេ។

ប្រសិនបើប្រើ Deepfake រូបភាពនៃមាត់បើកចំហរបស់មនុស្សអាចមិនមានធ្មេញ មនុស្សខ្លះអាចមានថ្គាម 3 សូម្បីតែ 4 ថ្គាម។ ដូច្នេះលក្ខណៈពិសេសរបស់ធ្មេញគឺជាធាតុដែលអាចស្គាល់បានបំផុតនៃការហៅក្លែងក្លាយដោយប្រើ Deepfake ។

“ការបន្ថយល្បឿន” និងការមិនអនុវត្តតាមសំណើភ្លាមៗ គឺជាតម្រូវការជាមុន ដើម្បីជៀសវាងការធ្លាក់ចូលទៅក្នុងអន្ទាក់បោកប្រាស់។ នៅពេលទទួលសារ ឬការហៅទូរសព្ទណាមួយតាមរយៈបណ្តាញសង្គម មនុស្សត្រូវទូរស័ព្ទទៅសាច់ញាតិរបស់ពួកគេដោយផ្ទាល់ ដើម្បីផ្ទៀងផ្ទាត់ថាអ្នកណាកំពុងទាក់ទងពួកគេក្នុងរយៈពេលយ៉ាងតិច 30 វិនាទី ឬជួបដោយផ្ទាល់។

ក្នុងករណីមានការសង្ស័យថា ក្លែងបន្លំសាច់ញាតិតាមបណ្តាញសង្គម ដើម្បីបោកប្រាស់ ឬទ្រព្យសម្បត្តិសមស្រប ចាំបាច់ត្រូវរាយការណ៍ជាបន្ទាន់ទៅកាន់ភ្នាក់ងារនគរបាលដែលនៅជិតបំផុត ដើម្បីទទួលបានការគាំទ្រ និងដោះស្រាយទាន់ពេលវេលា។

ប្រភព៖ https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[រូបថត] ជំនះរាល់ការលំបាក ពន្លឿនដំណើរការសាងសង់គម្រោងពង្រីករោងចក្រវារីអគ្គិសនី Hoa Binh](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/12/bff04b551e98484c84d74c8faa3526e0)

![[រូបថត] បិទសន្និបាតលើកទី១១ នៃគណៈកម្មាធិការមជ្ឈិមបក្សកុម្មុយនិស្តវៀតណាមលើកទី១៣](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/12/114b57fe6e9b4814a5ddfacf6dfe5b7f)

Kommentar (0)