En un evento para desarrolladores celebrado el 18 de marzo, Nvidia anunció una serie de nuevos productos para fortalecer su posición en el mercado de la inteligencia artificial (IA). El precio de las acciones del fabricante de chips se ha multiplicado por 54 y los ingresos se han más que triplicado desde que ChatGPT inició la carrera global de la IA a fines de 2022. Las GPU de servidor de alta gama de Nvidia son fundamentales para entrenar e implementar modelos de lenguaje grandes. Empresas como Microsoft y Meta han gastado miles de millones de dólares comprando chips.

Nvidia llama Blackwell a su nueva generación de chips de inteligencia artificial. El primer chip Blackwell, el GB200, estará disponible a finales de este año. Nvidia está ofreciendo a sus clientes chips más potentes para estimular nuevos pedidos. Actualmente, los clientes todavía están luchando por conseguir el chip H100 Hopper.

“Hopper es genial, pero necesitamos GPU más grandes”, dijo el CEO de Nvidia, Jensen Huang, en el evento.

Junto con el chip Blackwell, Nvidia también presentó el software NIM que facilita la implementación de IA. Según los funcionarios de Nvidia, la compañía se está convirtiendo cada vez más en un proveedor de plataformas como Apple y Microsoft en lugar de un proveedor de chips.

“Blackwell no es un chip, es el nombre de una plataforma”, dijo el Sr. Huang. El vicepresidente de Nvidia, Manuvir Das, promete un software NIM que ayudará a los programadores a ejecutar programas en cualquier GPU de Nvidia, antigua o nueva, para llegar a más personas.

Blackwell, el "sucesor" de Hopper

Cada dos años, Nvidia actualiza su arquitectura de GPU, desbloqueando nuevas mejoras de rendimiento. Muchos modelos de IA lanzados el año pasado fueron entrenados en la arquitectura Hopper que aparecerá en 2022.

Nvidia afirma que los chips basados en Blackwell, como el GB200, ofrecen una mejora significativa en el rendimiento de la IA para las empresas de IA: 20 petaflops en comparación con los 4 petaflops del H100. Este poder de procesamiento permite a las empresas de IA entrenar modelos más grandes y complejos.

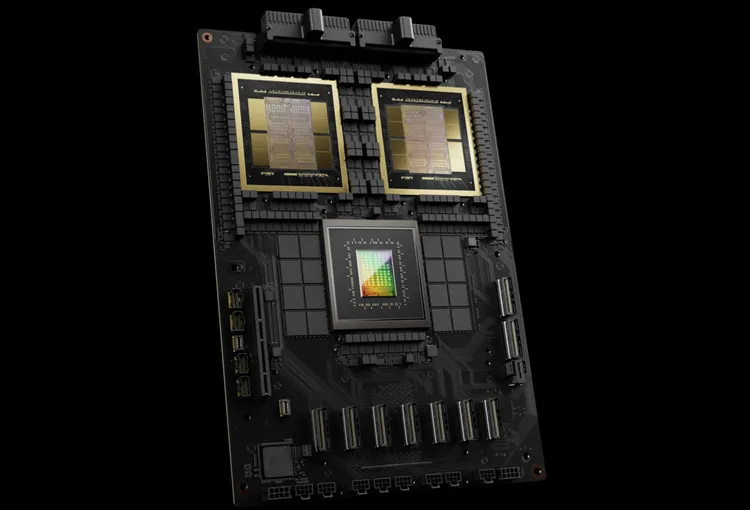

La GPU Blackwell es grande y combina dos matrices fabricadas por separado en un solo chip. También está disponible como un servidor completo llamado GB200 NVLink 2, que combina 72 GPU Blackwell y otras partes de Nvidia diseñadas para entrenar modelos de IA.

Amazon, Google, Microsoft y Oracle venderán acceso a GB200 a través de servicios en la nube. El GB200 combina dos GPU Blackwell B200 con una CPU Grace. Nvidia dijo que Amazon Web Services (AWS) construirá un clúster de servidores con 20.000 chips GB200.

El sistema puede implementar un modelo de 27 billones de parámetros, mucho más grande que los modelos actuales más grandes, como GPT-4 (1,7 billones de parámetros). Muchos investigadores de IA creen que modelos más grandes con más parámetros y datos pueden desbloquear nuevas capacidades.

Nvidia no ha anunciado los precios del nuevo GB200 ni de los sistemas que lo contienen. El H100 de Nvidia basado en Hopper cuesta entre 25.000 y 40.000 dólares por unidad, y el sistema completo cuesta hasta 200.000 dólares, según estimaciones de los analistas.

(Según CNBC)

[anuncio_2]

Fuente

![[Foto] El Primer Ministro Pham Minh Chinh y el Primer Ministro etíope visitan la Pagoda Tran Quoc](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/18ba6e1e73f94a618f5b5e9c1bd364a8)

![[Foto] El presidente Luong Cuong recibe al ministro de Defensa de Kenia, Soipan Tuya.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/0e7a5185e8144d73af91e67e03567f41)

![[Foto] Promover la amistad, la solidaridad y la cooperación entre los ejércitos y los pueblos de ambos países.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/0c4d087864f14092aed77252590b6bae)

![[Foto] Cálido encuentro entre las dos Primeras Damas de los Primeros Ministros de Vietnam y Etiopía con estudiantes con discapacidad visual de la Escuela Nguyen Dinh Chieu](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/b1a43ba73eb94fea89034e458154f7ae)

![[Foto] El Secretario General To Lam recibe al Embajador de Francia en Vietnam, Olivier Brochet](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/49224f0f12e84b66a73b17eb251f7278)

![[Foto] Ceremonia de bienvenida al Ministro de Defensa chino y a la delegación para el intercambio de amistad.](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/fadd533046594e5cacbb28de4c4d5655)

![[Foto] Pinos centenarios: un destino atractivo para los turistas en Gia Lai](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/25a0b7b629294f3f89350e263863d6a3)

![[Vídeo] Viettel pone oficialmente en funcionamiento la línea de cable óptico submarino más grande de Vietnam](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/f19008c6010c4a538cc422cb791ca0a1)

Kommentar (0)