Опасности потери контроля над ИИ

Человечество, похоже, игнорирует призрак на горизонте. Это призрак глобальной ядерной войны, вызванной искусственным интеллектом (ИИ). Об этом предупреждал Генеральный секретарь ООН Антониу Гутерриш. Однако до сих пор ядерные державы не смогли объединить усилия для переговоров по этой катастрофической угрозе.

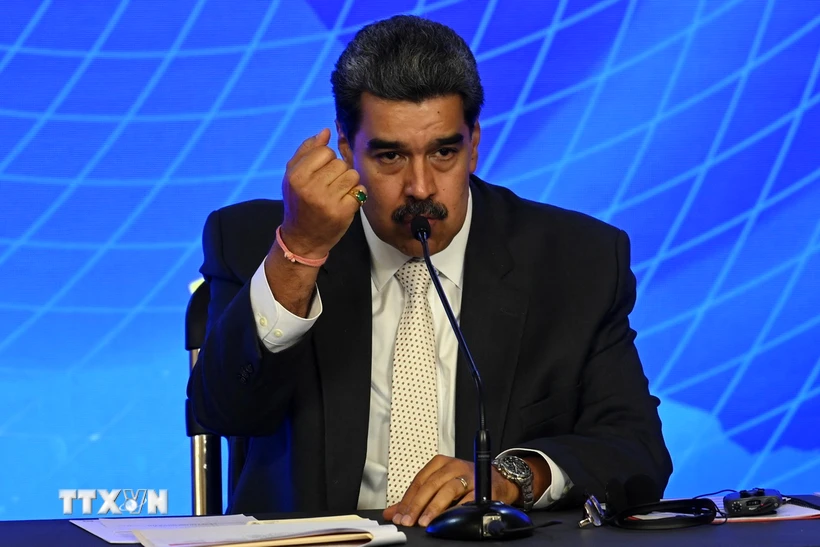

Стремительное развитие искусственного интеллекта (ИИ) повышает риск вмешательства ИИ в процесс запуска ядерного оружия. Иллюстрация

Среди пяти крупнейших ядерных держав — США, России, Китая, Великобритании и Франции — уже давно существует неформальный консенсус относительно принципа «участия людей в управлении», что означает, что в каждой стране имеется система, обеспечивающая участие людей в принятии решения о запуске ядерного оружия.

Ни одна из пяти держав не заявляет, что использует ИИ в своих системах управления запуском ядерных ракет. По словам доктора Сандипа Васлекара, председателя Strategic Foresight Group, международной исследовательской организации в Мумбаи (Индия), это правда, но вводит в заблуждение.

ИИ уже используется для обнаружения угроз и выбора целей. Системы на базе искусственного интеллекта анализируют огромные объемы данных с датчиков, спутников и радаров в режиме реального времени, анализируют входящие ракетные атаки и предлагают варианты реагирования.

Затем оператор перепроверяет угрозу из разных источников и решает, перехватывать ли ракеты противника или наносить ответные удары.

«В настоящее время время реагирования, доступное операторам, составляет 10–15 минут. К 2030 году это время сократится до 5–7 минут», — сказал Сандип Васлекар. «Хотя окончательные решения будут принимать люди, на них будет влиять предиктивная и предписывающая аналитика ИИ. ИИ может стать движущей силой решений о запуске уже в 2030-х годах».

Проблема в том, что ИИ может совершать ошибки. Алгоритмы обнаружения угроз могут указывать на ракетную атаку, когда ее нет. Это может быть связано с ошибками компьютера, сетевыми вторжениями или факторами окружающей среды, которые мешают прохождению сигналов. Если операторы не подтвердят ложные сигналы тревоги из других источников в течение 2–3 минут, они могут спровоцировать ответные атаки.

Очень маленькая ошибка, огромная катастрофа

Известно, что использование ИИ во многих гражданских функциях, таких как прогнозирование преступлений, распознавание лиц и прогнозирование онкологических заболеваний, имеет погрешность в 10%. По словам г-на Сандипа Васлекара, в системах раннего предупреждения о ядерной опасности погрешность может составлять около 5%.

По мере повышения точности алгоритмов распознавания изображений в течение следующего десятилетия эта погрешность может снизиться до 1–2%. Но даже погрешность в 1% может привести к глобальной ядерной войне.

Решения о нанесении ядерного удара или ответном ударе могут быть вызваны ошибками ИИ. Фото: Институт современной войны

Риск может возрасти в течение следующих двух-трех лет по мере появления новых вредоносных программ, способных обходить системы обнаружения угроз. Вредоносное ПО будет адаптироваться, чтобы избежать обнаружения, автоматически определяя цели и автоматически атакуя их.

Во время Холодной войны было несколько ситуаций «балансирования на грани войны». В 1983 году советский спутник по ошибке обнаружил пять ракет, запущенных Соединенными Штатами. Станислав Петров, офицер российского командного центра Сепухов-15, пришел к выводу, что тревога была ложной, и не предупредил об этом начальство, чтобы оно могло начать контратаку.

В 1995 году Оленегорская радиолокационная станция зафиксировала ракетную атаку у берегов Норвегии. Стратегические силы России были приведены в состояние повышенной готовности, а тогдашнему президенту России Борису Ельцину был передан ядерный чемоданчик. Он заподозрил, что это ошибка, и не нажал кнопку. Оказалось, это была научная ракета. Если ИИ будет использоваться для определения ответов в обеих ситуациях, результаты могут оказаться катастрофическими.

В настоящее время гиперзвуковые ракеты используют традиционную автоматику вместо искусственного интеллекта. Они могут летать со скоростью от 5 до 25 Махов, избегая обнаружения радаров и контролируя траекторию полета. Сверхдержавы планируют усовершенствовать гиперзвуковые ракеты с помощью искусственного интеллекта, чтобы мгновенно обнаруживать и уничтожать движущиеся цели, переложив принятие решений об убийстве с людей на машины.

Также ведется гонка за разработку общего искусственного интеллекта, которая может привести к появлению моделей ИИ, работающих вне контроля человека. Когда это произойдет, системы ИИ научатся совершенствоваться и воспроизводить себя, взяв на себя процессы принятия решений. Когда такой ИИ будет интегрирован в системы поддержки принятия решений по ядерному оружию, машины смогут инициировать разрушительные войны.

Время действовать

Столкнувшись с вышеперечисленными рисками, многие эксперты полагают, что человечеству необходимо всеобъемлющее соглашение между крупнейшими державами, чтобы минимизировать риск ядерной войны, выходящее за рамки повторения лозунга «люди в курсе событий».

Это соглашение должно включать меры по обеспечению прозрачности, подотчетности и сотрудничества; международные стандарты тестирования и оценки; каналы кризисной коммуникации; национальные надзорные комиссии; и правила, запрещающие агрессивные модели ИИ, способные обходить людей-операторов.

Генеральный секретарь Антониу Гутерриш принимает участие в церемонии памяти мира в Хиросиме, которая подверглась атомной бомбардировке в 1945 году. Фото: ООН

Геополитические изменения создают возможность для заключения такого договора. Например, ведущие эксперты в области искусственного интеллекта из Китая и США провели ряд двусторонних диалогов по рискам, связанным с ИИ, что привело к совместному заявлению бывшего президента США Джо Байдена и председателя КНР Си Цзиньпина в ноябре прошлого года.

По словам доктора Сандипа Васлекара, миллиардер Илон Маск является убежденным сторонником необходимости спасения человечества от экзистенциальных рисков, создаваемых ИИ. Г-н Маск может призвать действующего президента США Дональда Трампа превратить совместное заявление г-на Джо Байдена и г-на Си Цзиньпина в договор.

По словам доктора Сандипа Васлекара, проблема ядерного ИИ также требует участия России. До января этого года Россия отказывалась обсуждать какие-либо меры по снижению ядерных рисков, включая конвергенцию с ИИ, если только на обсуждение не был вынесен вопрос Украины.

Поскольку президент Дональд Трамп вступил в диалог с президентом России Владимиром Путиным с целью улучшения двусторонних отношений и прекращения войны на Украине, Россия теперь может быть открыта для переговоров.

В феврале этого года, после выступления вице-президента США Дж. Д. Вэнса на Парижском саммите по вопросам искусственного интеллекта, Центр новой американской безопасности (CNAS) также опубликовал доклад под названием «Предотвращение конца света в сфере искусственного интеллекта: конкуренция США, Китая и России на стыке ядерного оружия и искусственного интеллекта».

В отчете определены наиболее существенные риски, связанные с взаимосвязью ИИ и ядерной энергетики, и содержится призыв к администрации США разработать комплексный набор механизмов снижения рисков и управления кризисами совместно с Китаем и Россией.

Ранее, в сентябре прошлого года, около 60 стран, включая США, приняли «план действий» по управлению ответственным использованием ИИ в армии на саммите по ответственному использованию ИИ в армии (REAIM), который состоялся в Сеуле, Южная Корея. Это вторая конференция подобного рода после состоявшейся в Гааге в прошлом году. Эти движения показывают, что риск ядерной войны, инициированной ИИ, не является научной фантастикой.

Мир явно сталкивается со все более острой экзистенциальной проблемой, которая требует реальных действий со стороны ядерных держав для обеспечения того, чтобы «каждое решение об использовании ядерного оружия принималось людьми, а не машинами или алгоритмами», как призвал Генеральный секретарь ООН Антониу Гутерриш.

Нгуен Кхань

![[Фото] Генеральный секретарь То Лам председательствует на постоянном заседании Центрального руководящего комитета по предупреждению и борьбе с коррупцией, расточительством и негативом](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/839ea9ed0cd8400a8ba1c1ce0728b2be)

![[Фото] Министр обороны руководит проверкой парада и маршевой подготовки](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/35c2dd58a3e840d3a8cd615e70e89039)

![[Фото] Газета Nhan Dan отмечает 94-ю годовщину основания Союза коммунистической молодежи имени Хо Ши Мина](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/25/5571705682934ac5be5014ce171facb4)

Комментарий (0)