BGR 에 따르면, 새로운 연구 보고서에서 '펀 튜닝'이라는 놀라운 기술을 공개했습니다. 이 기술은 AI(인공 지능) 자체를 사용하여 Google의 Gemini를 포함한 다른 고급 AI 모델을 표적으로 삼아 매우 효과적인 즉각 주입 공격을 자동으로 생성합니다.

이 방법은 AI를 그 어느 때보다 더 빠르고, 저렴하고, 쉽게 '해킹'할 수 있게 만들어, AI를 둘러싼 사이버 보안 전쟁이 새로운 국면을 맞이하게 되었습니다.

악당이 AI를 이용해 AI를 파괴할 때의 위험

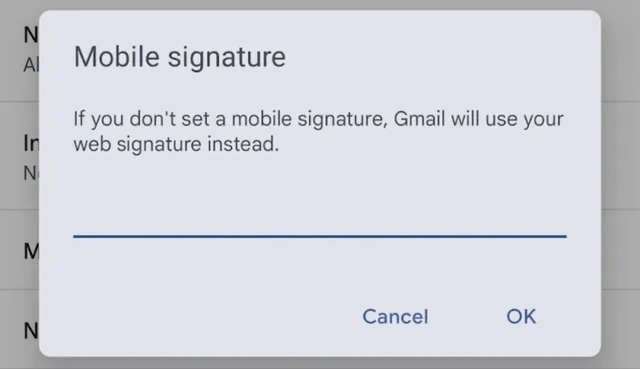

즉각적인 주입은 공격자가 AI 모델의 입력 데이터에 악성 명령을 은밀하게 삽입하는 기술입니다(예: 소스 코드의 주석, 웹의 숨겨진 텍스트). 목표는 AI를 '속여' 사전 프로그래밍된 안전 규칙을 우회하도록 강제하는 것입니다. 이로 인해 민감한 데이터가 유출되거나, 허위 정보가 제공되거나, 기타 위험한 행동을 하는 등 심각한 결과가 초래될 수 있습니다.

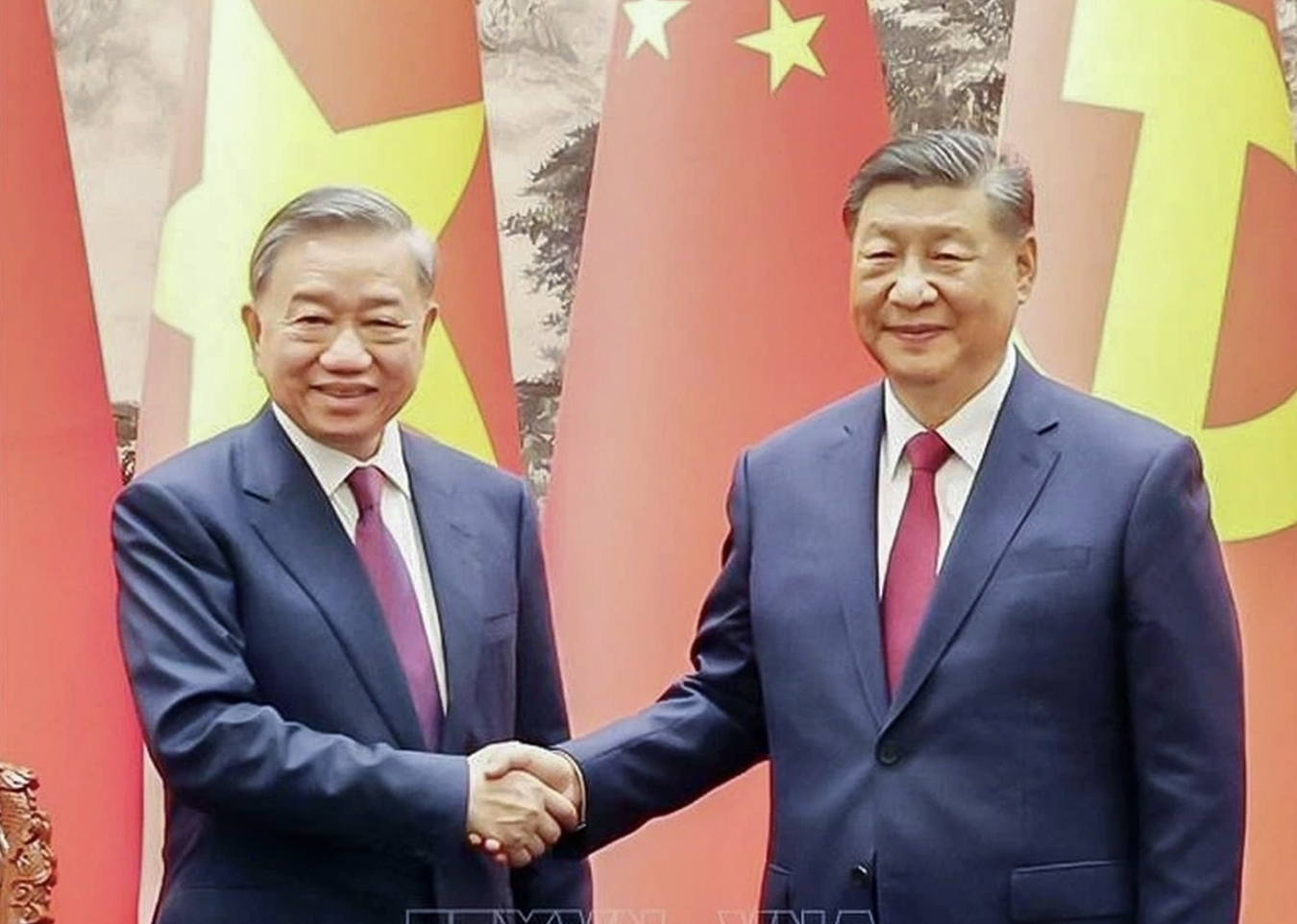

해커들은 AI를 이용해 AI를 공격하고 있다

사진: 링크드인 스크린샷

이전에는 이러한 공격을 성공적으로 실행하려면, 특히 Gemini나 GPT-4와 같은 '폐쇄형' 모델에서 많은 복잡하고 시간이 많이 소요되는 수동 테스트가 필요했습니다.

하지만 Fun-Tuning은 게임의 판도를 완전히 바꿔놓았습니다. 여러 대학의 연구진으로 구성된 팀이 개발한 이 방법은 Google이 Gemini 사용자에게 무료로 제공하는 정밀하게 조정된 애플리케이션 프로그래밍 인터페이스(API)를 그대로 활용합니다.

튜닝하는 동안 제미니 모델의 미묘한 반응(예: 데이터 오류에 대한 대응 방식)을 분석함으로써 Fun-Tuning은 악의적인 진술을 숨기는 데 가장 효과적인 '접두사'와 '접미사'를 자동으로 결정할 수 있습니다. 이로 인해 AI가 공격자의 악의적인 의도를 따를 가능성이 크게 높아집니다.

테스트 결과에 따르면 Fun-Tuning은 일부 버전의 Gemini에서 최대 82%의 성공률을 달성하는데, 이는 기존 공격 방법의 30% 미만을 능가하는 수치입니다.

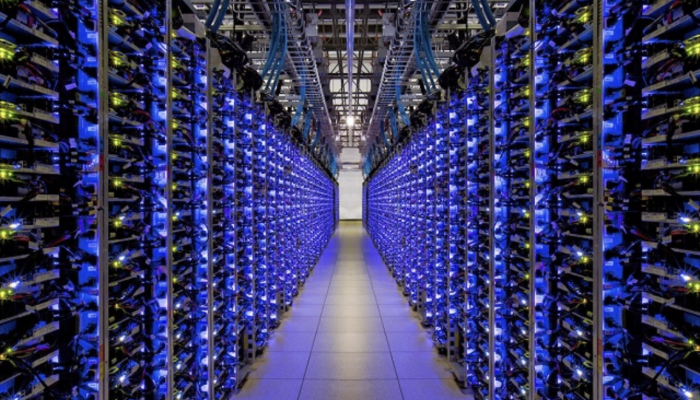

Fun-Tuning의 위험성을 더하는 것은 구현 비용이 매우 낮다는 점입니다. Google의 조정 API는 무료로 제공되므로 효과적인 공격을 만드는 데 드는 컴퓨팅 비용은 10달러 정도로 저렴할 수 있습니다. 게다가 연구원들은 제미니의 한 버전을 위해 설계된 공격이 다른 버전에도 쉽게 적용될 수 있다는 사실을 발견했는데, 이는 광범위한 공격의 위험을 높였습니다.

Google은 Fun-Tuning 기술이 제기하는 위협을 알고 있다는 사실을 확인했지만, 이 기술이 트위킹 API의 작동 방식을 변경할지 여부에 대해서는 아직 언급하지 않았습니다. 또한 이 팀은 Fun-Tuning이 이용하는 정보가 튜닝 과정에서 제거되면 API가 실제 개발자에게 덜 유용해진다는 방어적 어려움을 지적합니다. 오히려, 지금 상태로 유지한다면, 계속해서 나쁜 놈들이 악용할 수 있는 발판이 될 것입니다.

펀튜닝의 등장은 사이버공간의 대립이 새로운, 보다 복잡한 단계로 접어들었다는 분명한 경고입니다. AI는 이제 단순히 표적이 아니라 악의적인 행위자의 손에 있는 도구이자 무기이기도 합니다.

[광고_2]

출처: https://thanhnien.vn/hacker-dung-ai-de-tan-cong-gemini-cua-google-18525033010473121.htm

![[사진] 비엔호아 공항 퍼레이드 리허설에 참여한 '미녀들'](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

![[사진] 미얀마 베트남 구조대, 감동의 순간들을 돌아보다](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/5623ca902a934e19b604c718265249d0)

![[사진] 4월 30일 기념 퍼레이드 연습 요약](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/78cfee0f2cc045b387ff1a4362b5950f)

댓글 (0)