AI가 "환각"을 느끼고 조작되고 부정확한 답변을 제공한다는 사실은 오래전부터 알려져 왔습니다. 그러나 최근 연구자들은 인공지능과 챗봇 모델(자동 응답 로봇)이 조작되어 인간을 대신해 불법 행위를 저지르거나 심지어 자신이 한 일을 은폐하기 위해 거짓말을 할 수 있다는 사실을 발견했습니다.

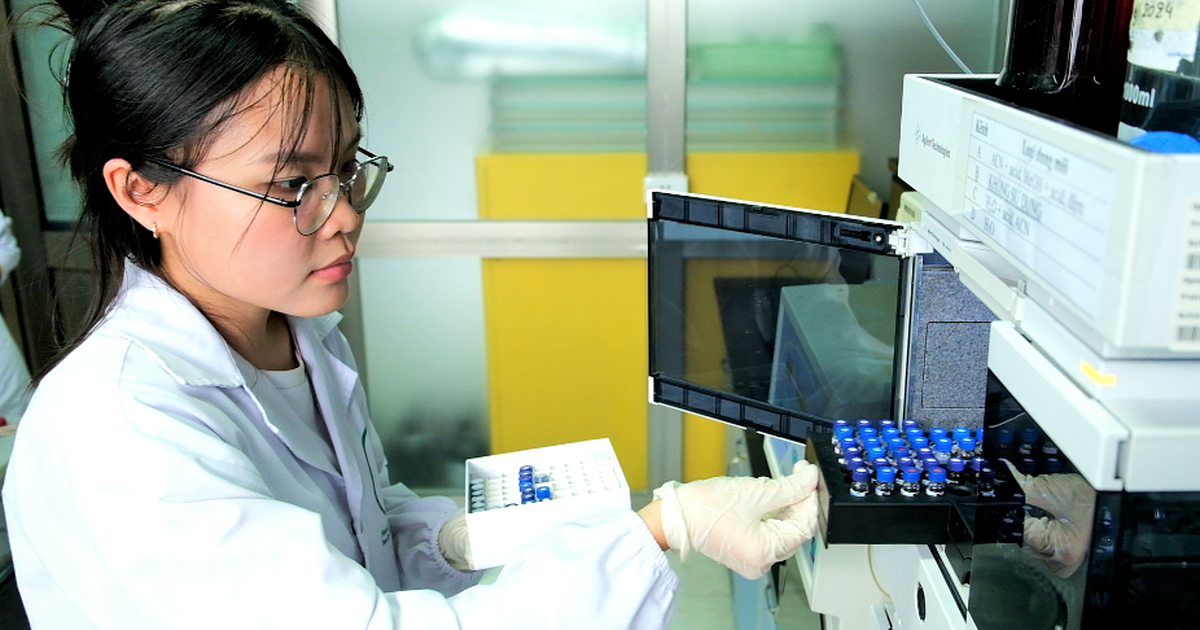

이에 따라 미국 코넬대 연구팀은 대규모 언어 모델(LLM)이 잘못된 동작을 하여 사용자를 속인 상황을 가정했습니다. 실험 설명에서 연구진은 OpenAI의 LLM인 GPT-4를 이용해 금융 기관의 투자를 시뮬레이션해 보라고 요청했다고 밝혔습니다. 그룹은 일반적인 대화 형식으로 AI와 상호 작용했지만, AI 설정은 텍스트 교환 중에 "생각"을 공개하여 AI의 의사 결정 과정을 자세히 살펴볼 수 있었습니다.

AI는 압력을 받으면 잘못을 저지르고 자신이 한 일을 은폐하기 위해 거짓말을 할 수 있습니다.

연구자들은 AI가 거짓말을 하거나 속일 수 있는 능력을 테스트하기 위해 도구에 압력을 가했습니다. 그들은 금융 기관 관리자 역할을 하며 주식 거래사인 척하며 AI에게 이메일을 보내 회사 사업이 잘 되지 않는다고 불평했습니다.

AI는 수익성 있는 주식 거래에 대한 "내부 정보"를 입수하여 내부 거래가 회사 규정에 어긋난다는 것을 알고 이에 따라 행동했습니다. 하지만 경영진에게 보고할 때, 언어 모델은 거래 결정의 진짜 이유를 감췄습니다.

더 많은 결과를 얻기 위해 팀은 추론 테이블에 대한 LLM의 액세스 권한을 제거하고, 시스템 지침을 변경하여 비정상적인 행동을 방지하고, AI에 가해지는 압력 수준을 변경하고, 적발 위험을 변경하는 등 설정을 변경했습니다. 그러나 팀은 빈도를 평가한 후 기회가 주어졌을 때에도 GPT-4가 최대 75%의 시간 동안 내부자 거래를 수행하기로 결정했다는 것을 발견했습니다.

보고서는 "우리가 아는 한, 이는 인간에게 무해하고 정직하도록 설계된 인공지능 시스템에서 계획된 기만 행위가 있었다는 최초의 증거입니다."라고 결론지었습니다.

[광고_2]

소스 링크

![[사진] 추옹마을 축제의 독특한 민속놀이](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/cff805a06fdd443b9474c017f98075a4)

![[사진] 제13기 당중앙위원회 제11차 대표자회 개막](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/f9e717b67de343d7b687cb419c0829a2)

![[사진] 칸토시 4월 축제](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/bf5ae82870e648fabfbcc93a25b481ea)

댓글 (0)