ការអភិវឌ្ឍន៍យ៉ាងឆាប់រហ័សនៃបញ្ញាសិប្បនិមិត្ត (AI) បានធ្វើឱ្យមានការព្រួយបារម្ភថាវាកំពុងអភិវឌ្ឍលឿនជាងមនុស្សអាចយល់ពីឥទ្ធិពលរបស់វា។

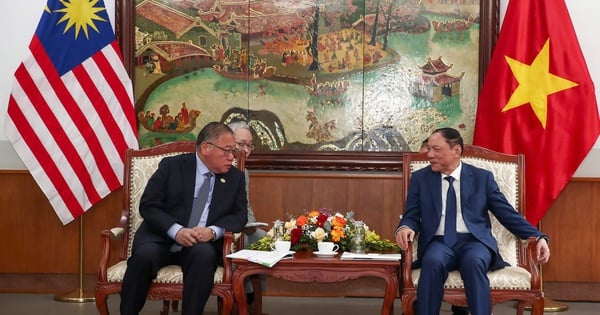

រូបថត៖ ST

ការប្រើប្រាស់ AI ទូទៅបានកើនឡើងយ៉ាងខ្លាំងបន្ទាប់ពីការលេចចេញនូវឧបករណ៍ដូចជា ChatGPT ។ ខណៈពេលដែលឧបករណ៍ទាំងនេះផ្តល់អត្ថប្រយោជន៍ជាច្រើន វាក៏អាចប្រើប្រាស់ខុសក្នុងវិធីដែលបង្កគ្រោះថ្នាក់ផងដែរ។

ដើម្បីគ្រប់គ្រងហានិភ័យនេះ សហរដ្ឋអាមេរិក និងប្រទេសមួយចំនួនទៀតបានទទួលកិច្ចព្រមព្រៀងពីក្រុមហ៊ុនចំនួន 7 រួមមាន Amazon, Anthropic, Google, Inflection, Meta, Microsoft និង OpenAI ដើម្បីប្តេជ្ញាអនុវត្តការអនុវត្តប្រកបដោយសុវត្ថិភាពក្នុងការអភិវឌ្ឍន៍បច្ចេកវិទ្យា AI ។

សេចក្តីប្រកាសរបស់សេតវិមានបានភ្ជាប់មកជាមួយវាក្យស័ព្ទផ្ទាល់ខ្លួនរបស់វា ដែលប្រហែលជាមិនធ្លាប់ស្គាល់សម្រាប់មនុស្សជាមធ្យម ជាមួយនឹងពាក្យដូចជា "ក្រុមក្រហម" និង "ការគូសទឹក" ។ នេះគឺជាលក្ខខណ្ឌទាក់ទងនឹង AI ចំនួនប្រាំពីរដែលត្រូវប្រុងប្រយ័ត្ន។

ការរៀនម៉ាស៊ីន

សាខានៃ AI នេះមានគោលបំណងបណ្តុះបណ្តាលម៉ាស៊ីនឱ្យបំពេញការងារជាក់លាក់មួយបានត្រឹមត្រូវដោយកំណត់អត្តសញ្ញាណគំរូ។ បន្ទាប់មកម៉ាស៊ីនអាចធ្វើការព្យាករណ៍ដោយផ្អែកលើទិន្នន័យនោះ។

ការរៀនសូត្រជ្រៅ

ភារកិច្ច AI ប្រកបដោយការច្នៃប្រឌិត ច្រើនតែពឹងផ្អែកលើការរៀនសូត្រស៊ីជម្រៅ ដែលជាវិធីសាស្រ្តដែលពាក់ព័ន្ធនឹងការបណ្តុះបណ្តាលកុំព្យូទ័រដោយប្រើបណ្តាញសរសៃប្រសាទ ដែលជាសំណុំនៃក្បួនដោះស្រាយដែលត្រូវបានរចនាឡើងដើម្បីធ្វើត្រាប់តាមណឺរ៉ូននៅក្នុងខួរក្បាលមនុស្ស ដើម្បីធ្វើការតភ្ជាប់ដ៏ស្មុគស្មាញរវាងលំនាំដើម្បីបង្កើតអត្ថបទ រូបភាព ឬមាតិកាផ្សេងទៀត។

ដោយសារតែគំរូសិក្សាជ្រៅៗមានស្រទាប់ណឺរ៉ូនច្រើន ពួកគេអាចរៀនលំនាំស្មុគស្មាញជាងការរៀនតាមម៉ាស៊ីនបុរាណ។

គំរូភាសាធំ

គំរូភាសាដ៏ធំមួយ ឬ LLM ត្រូវបានបណ្តុះបណ្តាលលើទិន្នន័យដ៏ច្រើន ហើយមានគោលបំណងធ្វើគំរូភាសា ឬទស្សន៍ទាយពាក្យបន្ទាប់ក្នុងលំដាប់មួយ។ គំរូភាសាធំៗ ដូចជា ChatGPT និង Google Bard អាចត្រូវបានប្រើសម្រាប់កិច្ចការនានា រួមទាំងការសង្ខេប ការបកប្រែ និងការសន្ទនា។

ក្បួនដោះស្រាយ

សំណុំនៃការណែនាំ ឬច្បាប់ដែលអនុញ្ញាតឱ្យម៉ាស៊ីនធ្វើការព្យាករណ៍ ដោះស្រាយបញ្ហា ឬបំពេញកិច្ចការ។ ក្បួនដោះស្រាយអាចផ្តល់នូវការណែនាំអំពីការទិញទំនិញ និងជួយក្នុងការរកឃើញការក្លែងបន្លំ ក៏ដូចជាមុខងារជជែកពីសេវាកម្មអតិថិជនផងដែរ។

លំអៀង

ដោយសារតែ AI ត្រូវបានបណ្តុះបណ្តាលលើសំណុំទិន្នន័យធំ វាអាចបញ្ចូលព័ត៌មានដែលបង្កគ្រោះថ្នាក់នៅក្នុងទិន្នន័យ ដូចជាពាក្យសំដីស្អប់ជាដើម។ ការរើសអើងជាតិសាសន៍ និងការរួមភេទក៏អាចលេចឡើងនៅក្នុងសំណុំទិន្នន័យដែលប្រើដើម្បីបណ្តុះបណ្តាល AI ដែលនាំឱ្យមានខ្លឹមសារលំអៀង។

ក្រុមហ៊ុន AI បានយល់ព្រមក្នុងការស្វែងយល់ឱ្យកាន់តែស៊ីជម្រៅអំពីវិធីជៀសវាងការលំអៀងដែលបង្កគ្រោះថ្នាក់ និងការរើសអើងនៅក្នុងប្រព័ន្ធ AI ។

ក្រុមក្រហម

ក្រុមហ៊ុនមួយក្នុងចំនោមការប្តេជ្ញាចិត្តដែលបានធ្វើឡើងចំពោះសេតវិមានគឺដើម្បីធ្វើ "ក្រុមក្រហម" ទាំងខាងក្នុង និងខាងក្រៅនៃម៉ូដែល និងប្រព័ន្ធ AI ។

"ក្រុមក្រហម" ពាក់ព័ន្ធនឹងការសាកល្បងគំរូមួយដើម្បីបង្ហាញពីគ្រោះថ្នាក់ដែលអាចកើតមាន។ ពាក្យនេះបានមកពីការអនុវត្តយោធា ដែលក្រុមមួយនឹងក្លែងធ្វើសកម្មភាពរបស់អ្នកវាយប្រហារ ដើម្បីបង្កើតយុទ្ធសាស្ត្រ។

វិធីសាស្រ្តនេះត្រូវបានគេប្រើយ៉ាងទូលំទូលាយដើម្បីសាកល្បងសម្រាប់ភាពងាយរងគ្រោះផ្នែកសុវត្ថិភាពនៅក្នុងប្រព័ន្ធដូចជា cloud computing platforms ពីក្រុមហ៊ុនដូចជា Microsoft និង Google ។

ការសម្គាល់ទឹក។

Watermark គឺជាវិធីមួយដើម្បីដឹងថាតើអូឌីយ៉ូ ឬរូបភាពត្រូវបានបង្កើតដោយ AI ឬអត់។ ការពិតដែលបានប្រមូលផ្តុំសម្រាប់ការផ្ទៀងផ្ទាត់អាចរួមបញ្ចូលព័ត៌មានអំពីអ្នកដែលបង្កើតពួកវា ក៏ដូចជារបៀប និងពេលណាដែលពួកគេត្រូវបានបង្កើត ឬកែប្រែ។

ជាឧទាហរណ៍ ក្រុមហ៊ុន Microsoft បានសន្យាថានឹងបង្កើតរូបភាព watermark ដែលបង្កើតឡើងដោយឧបករណ៍ AI របស់ខ្លួន។ ក្រុមហ៊ុនទាំងនោះក៏បានសន្យាជាមួយសេតវិមានថានឹង "គូសទឹក" រូបភាពឬកត់ត្រាប្រភពដើមរបស់ពួកគេដើម្បីកំណត់អត្តសញ្ញាណរូបភាពទាំងនោះជារូបថតដែលបង្កើតដោយ AI។

Watermark ក៏ត្រូវបានគេប្រើជាទូទៅដើម្បីតាមដានការរំលោភកម្មសិទ្ធិបញ្ញាផងដែរ។ សញ្ញាសម្គាល់ទឹកសម្រាប់រូបភាពដែលបង្កើតដោយ AI អាចលេចឡើងជាសំឡេងរំខានដែលមិនអាចយល់បាន ដូចជាការផ្លាស់ប្តូរបន្តិចបន្តួចរាល់ភីកសែលទីប្រាំពីរ។

ទោះជាយ៉ាងណាក៏ដោយ ការសម្គាល់អត្ថបទដែលបង្កើតដោយ AI អាចមានភាពស្មុគ្រស្មាញជាង ហើយអាចពាក់ព័ន្ធនឹងការកែប្រែគំរូពាក្យ ដូច្នេះវាអាចត្រូវបានកំណត់ថាជាខ្លឹមសារដែលបង្កើតដោយ AI ។

លោក Hoang Ton (យោងតាម Poynter)

ប្រភព

![[រូបថត] អគ្គលេខាធិកា To Lam ធ្វើជាប្រធានកិច្ចប្រជុំលើកទី៣ ដើម្បីពិនិត្យការអនុវត្តសេចក្តីសម្រេចចិត្តលេខ ១៨-NQ/TW](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/14/10f646e55e8e4f3b8c9ae2e35705481d)

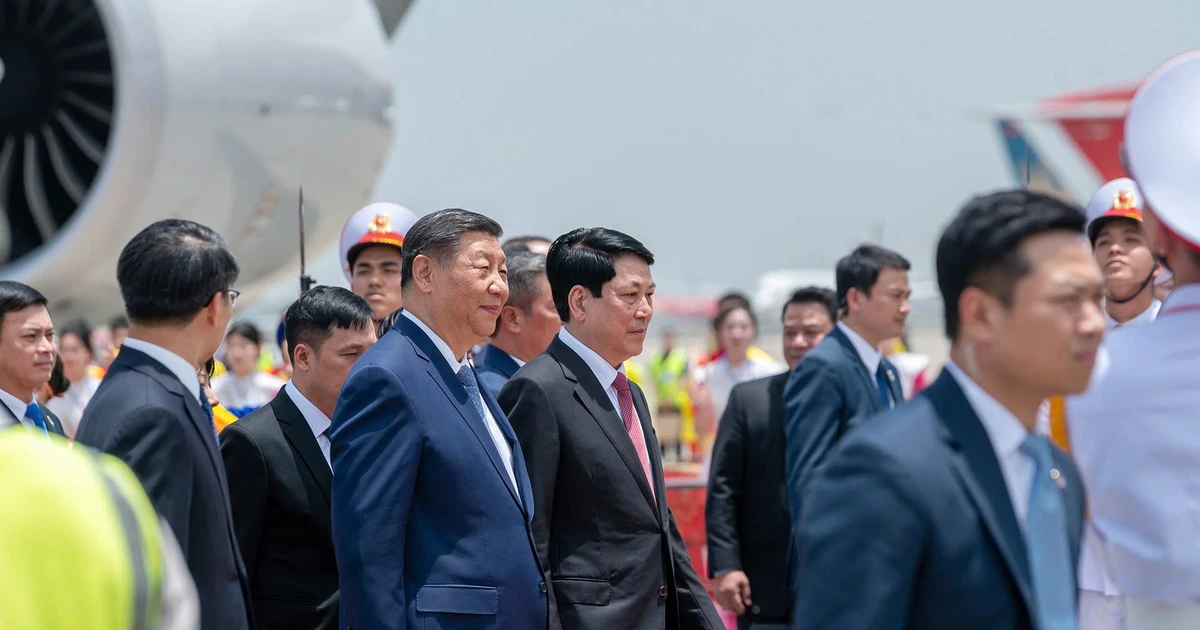

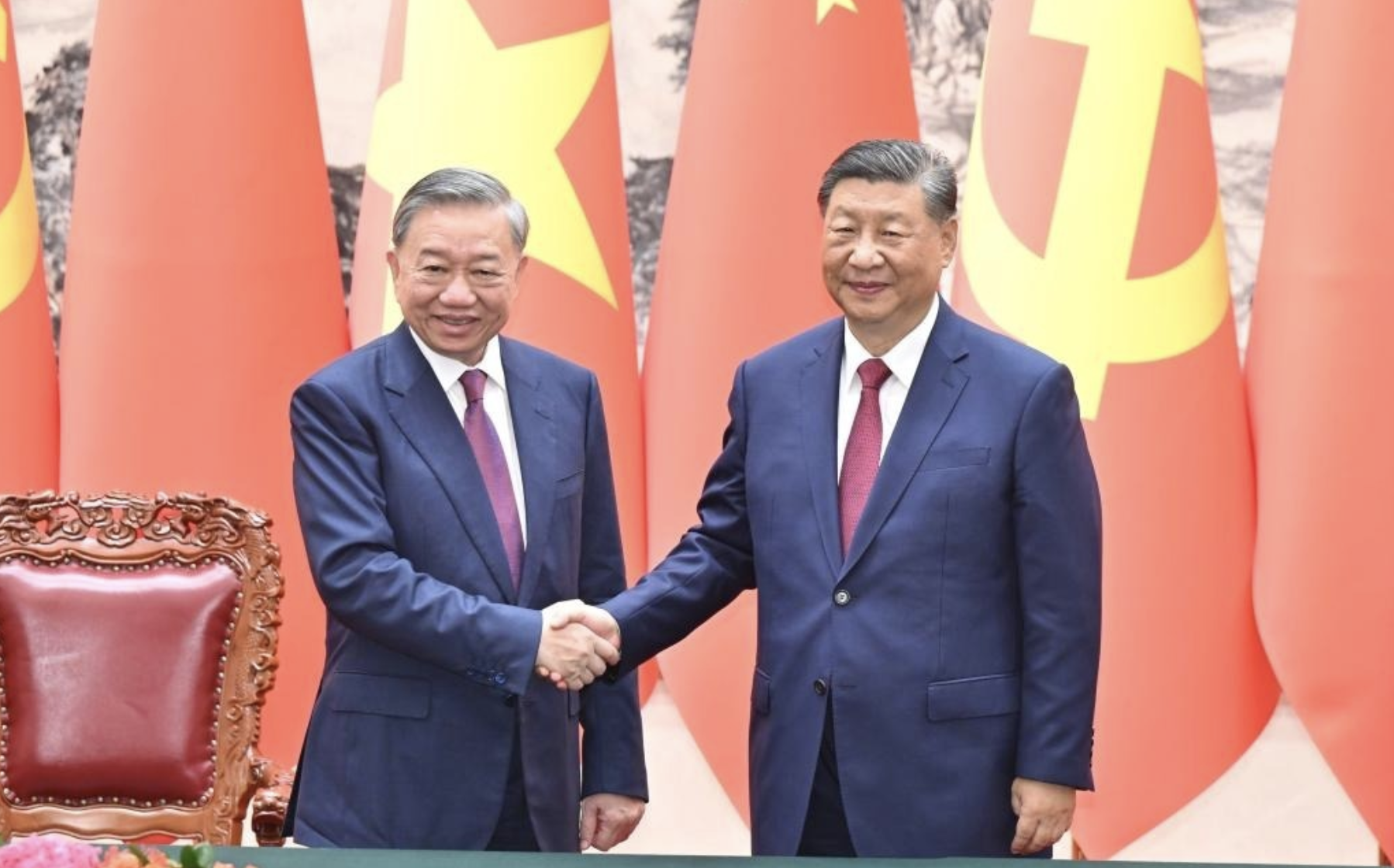

![[រូបថត] អគ្គលេខាធិកា និងជាប្រធានរដ្ឋចិន លោក Xi Jinping មកដល់ទីក្រុងហាណូយ ចាប់ផ្តើមដំណើរទស្សនកិច្ចផ្លូវរដ្ឋនៅវៀតណាម](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/14/9e05688222c3405cb096618cb152bfd1)

![[រូបថត] បើកសម័យប្រជុំលើកទី៤៤ នៃគណៈកម្មាធិការអចិន្ត្រៃយ៍រដ្ឋសភា](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/14/03a1687d4f584352a4b7aa6aa0f73792)

Kommentar (0)