El director ejecutivo de Truepic, Jeffrey McGregor, dijo que el incidente fue solo la punta del iceberg. Habrá mucho contenido generado por IA en las redes sociales y no estamos preparados para ello, dijo McGregor.

Según CNN, Truepic quiere resolver este problema proporcionando una tecnología que pretende autenticar los medios en el momento de su creación a través de Truepic Lens. La aplicación de recopilación de datos informará a los usuarios la fecha, la hora, la ubicación y el dispositivo utilizado para crear la imagen, y aplicará una firma digital para verificar si la imagen es natural o generada por IA.

Una foto falsa de la explosión del Pentágono se vuelve viral en Twitter

Truepic, una empresa respaldada por Microsoft y fundada en 2015, dijo que está viendo interés por parte de ONG y empresas de medios, e incluso aseguradoras que buscan confirmar que las reclamaciones son legítimas.

McGregor dijo que cuando todo se pueda falsificar, cuando la inteligencia artificial haya alcanzado su pico de calidad y accesibilidad, ya no sabremos cuál es la realidad en línea.

Empresas tecnológicas como Truepic han estado trabajando para combatir la desinformación en línea durante años. Pero el surgimiento de una nueva generación de herramientas de inteligencia artificial que pueden generar imágenes y trabajos escritos a partir de comandos del usuario ha agregado urgencia. A principios de este año, se compartieron ampliamente imágenes falsas del Papa Francisco con una chaqueta de plumas de Balenciaga y del expresidente estadounidense Donald Trump siendo arrestado. Ambos incidentes han dejado a millones de personas confundidas sobre los peligros potenciales de la IA.

Algunos legisladores ahora piden a las empresas tecnológicas que aborden el problema etiquetando el contenido generado por IA. La vicepresidenta de la Comisión Europea (CE), Vera Jourova, dijo que empresas como Google, Meta, Microsoft y TikTok se han unido al código de prácticas voluntario de la Unión Europea (UE) para combatir la desinformación.

Un número cada vez mayor de empresas emergentes y gigantes tecnológicos, incluidos algunos que están implementando IA generativa en sus productos, están tratando de implementar estándares y soluciones para ayudar a las personas a determinar si una imagen o un video fue creado con IA.

Pero como la tecnología de IA avanza más rápido de lo que los humanos pueden seguir el ritmo, no está claro si estas soluciones pueden resolver el problema por completo. Incluso OpenAI, la empresa detrás de Dall-E y ChatGPT, ha admitido que sus propios esfuerzos para ayudar a detectar la escritura generada por IA son imperfectos.

Las empresas de desarrollo de soluciones están adoptando dos enfoques para resolver el problema. El primero se basa en el desarrollo de programas para identificar imágenes generadas por IA después de que se producen y comparten en línea. El otro se centra en marcar una imagen como real o generada por IA con algún tipo de firma digital.

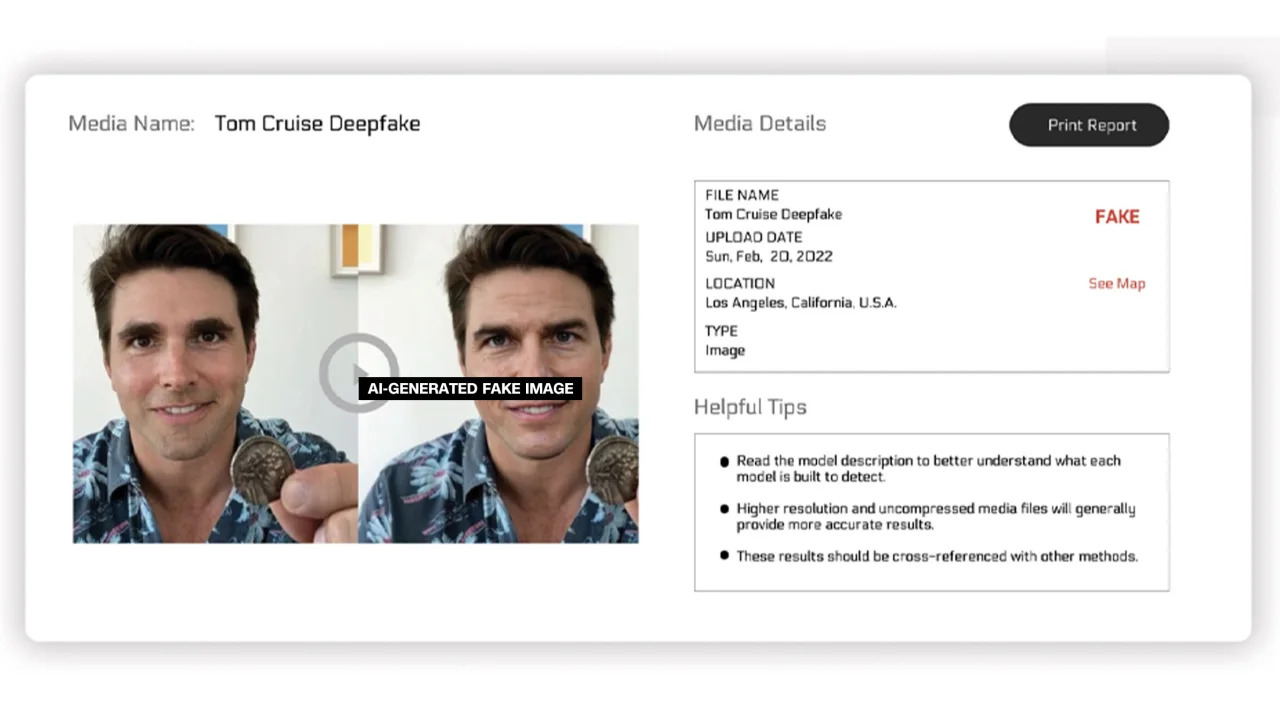

Reality Defender y Hive Moderation están trabajando en el primer enfoque. Con su plataforma, los usuarios pueden cargar imágenes para escanearlas y luego recibir un análisis que muestra un porcentaje que indica si la foto es real o generada por IA.

Reality Defender dice que la compañía utiliza tecnología patentada de deepfake y de huellas dactilares de contenido generativo para detectar videos, audios e imágenes generados por IA. En un ejemplo proporcionado por la empresa, Reality Defender mostró una imagen deepfake de Tom Cruise, que fue calificada con un 53% de “sospechosa” porque la persona en la imagen tenía una cara distorsionada que se ve comúnmente en fotos editadas.

Imágenes etiquetadas generadas por IA

Estos servicios ofrecen versiones gratuitas y de pago. Hive Moderation dice que cobra $1,50 por cada 1.000 imágenes. Realty Defender dice que los precios de sus productos pueden variar en función de una variedad de factores, en caso de que el cliente requiera la experiencia y el apoyo de la empresa. Ben Colman, director ejecutivo de Reality Defender, dice que el riesgo se duplica cada mes porque cualquiera puede crear fotos falsas utilizando herramientas de inteligencia artificial.

Varias otras empresas están trabajando en la integración de un tipo de etiqueta en las imágenes para certificar si son reales o generadas por IA. Hasta ahora, este esfuerzo ha sido impulsado en gran medida por la Content Authenticity and Provenance Alliance (C2PA).

C2PA se fundó en 2021 para crear un estándar técnico para certificar el origen y la historia de los medios digitales, combinando la Iniciativa de Autenticación de Contenido (CAI) de Adobe y el Proyecto Origin, liderado por Microsoft y la BBC, con un enfoque en la lucha contra la desinformación en las noticias digitales. Otras empresas que participan en C2PA incluyen Truepic, Intel y Sony.

Basándose en los principios de C2PA, CAI proporcionará herramientas de código abierto para que las empresas creen credenciales de contenido o metadatos que contengan información sobre imágenes. Según el sitio web de CAI, esto permite a los creadores compartir de forma transparente detalles sobre cómo crearon una imagen. De esta manera, los usuarios finales pueden acceder al contexto de quién, qué y cómo se alteró la imagen, y luego juzgar por sí mismos cuán auténtica es la imagen.

Muchas empresas han integrado el estándar C2PA y las herramientas CAI en sus aplicaciones. Firefly de Adobe, la nueva herramienta de imágenes con inteligencia artificial agregada a Photoshop, cumple con el estándar C2PA a través de la función Credenciales de contenido. Microsoft también anunció que las imágenes y vídeos creados con Bing Image Creator y Microsoft Designer llevarán firmas criptográficas en los próximos meses.

En mayo, Google anunció la función “Acerca de esta imagen”, que permite a los usuarios ver cuándo apareció una imagen por primera vez en Google y dónde se puede ver. El gigante de las búsquedas también anunció que cada imagen generada por Google AI llevará un marcado en el archivo original para “agregar contexto” si la imagen se encuentra en otro sitio web o plataforma.

Mientras las empresas tecnológicas intentan abordar las preocupaciones sobre las imágenes generadas por IA y la integridad de los medios digitales, los expertos en el campo enfatizan que las empresas deberán trabajar juntas entre sí y con los gobiernos para abordar el problema. Sin embargo, las empresas tecnológicas están compitiendo para desarrollar IA a pesar de los riesgos.

Enlace de origen

Kommentar (0)