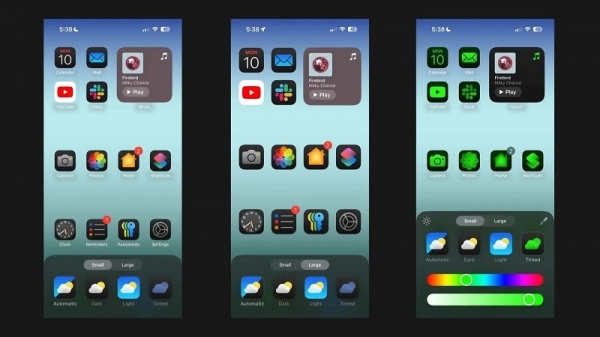

Android Authority 에 따르면, Apple의 연구 논문에서는 RAM이 제한된 기기에서 대규모 언어 모델(LLM)을 실행하기 위한 솔루션을 자세히 설명하고 있습니다. 이 논문에서는 회사가 전체 모델을 RAM에 로드하는 대신, 필요할 때 "모델 매개변수"를 저장하고 그 일부를 장치의 RAM에 로드하는 방법을 보여줍니다.

Apple은 RAM이 적은 구형 iPhone에서 일반 AI를 실행할 수 있도록 지원하려고 합니다.

이 논문에서는 이 방법을 사용하면 CPU와 GPU에서 각각 간단한 로딩 방법에 비해 4~5배와 20~25배의 추론 속도를 보장하면서도 iPhone이 가질 수 있는 RAM의 두 배에 해당하는 모델을 실행할 수 있다고 주장합니다.

RAM이 더 많은 기기에 합성 AI를 배포하면 읽기/쓰기 속도가 더 빨라져 유익할 것입니다. 온디바이스 AI에 있어서 속도는 중요합니다. 사용자가 응답이나 최종 결과를 받기 위해 반드시 수십 초(또는 그 이상)를 기다릴 필요가 없기 때문에 추론 시간이 훨씬 빨라집니다. 이 모든 것은 대화 속도로 실행되고, 훨씬 더 빠르게 이미지/텍스트를 생성하고, 더 빠르게 기사를 요약할 수 있는 온디바이스 AI 어시스턴트를 의미합니다. 하지만 Apple의 솔루션은 사용자가 온디바이스 AI 작업 응답 속도를 높이기 위해 반드시 많은 RAM이 필요하지 않다는 것을 의미합니다.

Apple의 접근 방식을 사용하면 기존 iPhone과 새 iPhone 모두에서 자체 기기에 합성 AI 기능을 제공할 수 있습니다. 이것이 중요한 이유는 Apple iPhone이 일반적으로 고급 Android 휴대폰보다 RAM이 적기 때문입니다. 예를 들어, iPhone 11 시리즈는 RAM을 4GB만 제공하는 반면, 일반 iPhone 15도 RAM이 6GB에 불과합니다.

LLM을 축소하려는 모바일 회사는 애플뿐만이 아니다. Qualcomm과 MediaTek의 최신 주력 칩은 모두 INT4 정밀도를 지원하여 이러한 모델의 크기를 줄입니다. 어느 쪽이든, 기업들은 기기 내 AI에 대한 시스템 요구 사항을 줄이고 저가형 휴대폰에서도 해당 기능을 제공할 수 있도록 하는 새로운 솔루션을 찾으려고 노력하고 있습니다.

[광고_2]

소스 링크

![[사진] 비엔호아 공항 퍼레이드 리허설에 참여한 '미녀들'](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/155502af3384431e918de0e2e585d13a)

![[사진] 미얀마 베트남 구조대, 감동의 순간들을 돌아보다](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/5623ca902a934e19b604c718265249d0)

![[사진] 4월 30일 기념 퍼레이드 연습 요약](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/11/78cfee0f2cc045b387ff1a4362b5950f)

댓글 (0)