Le PDG de Truepic, Jeffrey McGregor, a déclaré que l'incident n'était que la pointe de l'iceberg. Il y aura beaucoup de contenu généré par l'IA sur les réseaux sociaux et nous ne sommes pas prêts pour cela, a déclaré M. McGregor.

Selon CNN, Truepic souhaite résoudre ce problème en fournissant une technologie qui prétend authentifier les médias au moment de la création via Truepic Lens. L'application de collecte de données indiquera aux utilisateurs la date, l'heure, le lieu et l'appareil utilisé pour créer l'image, et appliquera une signature numérique pour vérifier si l'image est naturelle ou générée par l'IA.

Une fausse photo de l'explosion du Pentagone devient virale sur Twitter

Truepic, une société soutenue par Microsoft fondée en 2015, a déclaré que la société constatait l'intérêt des ONG, des sociétés de médias et même des assureurs cherchant à confirmer la légitimité des réclamations.

McGregor a déclaré que lorsque tout peut être falsifié, lorsque l’intelligence artificielle a atteint son apogée en termes de qualité et d’accessibilité, nous ne savons plus ce qu’est la réalité en ligne.

Les entreprises technologiques comme Truepic luttent depuis des années contre la désinformation en ligne. Mais l’essor d’une nouvelle génération d’outils d’IA capables de générer des images et des travaux écrits à partir de commandes utilisateur a accru l’urgence. Plus tôt cette année, de fausses images du pape François portant une doudoune Balenciaga et de l'ancien président américain Donald Trump en cours d'arrestation ont été largement partagées. Ces deux incidents ont laissé des millions de personnes perplexes quant aux dangers potentiels de l’IA.

Certains législateurs appellent désormais les entreprises technologiques à résoudre le problème en étiquetant le contenu généré par l’IA. La vice-présidente de la Commission européenne (CE), Vera Jourova, a déclaré que des entreprises telles que Google, Meta, Microsoft et TikTok ont adhéré au code de bonnes pratiques volontaire de l'Union européenne (UE) sur la lutte contre la désinformation.

Un nombre croissant de startups et de géants de la technologie, y compris certains qui implémentent l’IA générative dans leurs produits, tentent de mettre en œuvre des normes et des solutions pour aider les gens à déterminer si une image ou une vidéo a été créée avec l’IA.

Mais comme la technologie de l’IA progresse plus vite que ce que les humains peuvent suivre, il n’est pas certain que ces solutions puissent résoudre complètement le problème. Même OpenAI, la société derrière Dall-E et ChatGPT, a admis que ses propres efforts pour aider à détecter l’écriture générée par l’IA sont imparfaits.

Les sociétés de développement de solutions adoptent deux approches pour résoudre le problème. La première repose sur le développement de programmes permettant d’identifier les images générées par l’IA après leur production et leur partage en ligne. L’autre se concentre sur le marquage d’une image comme réelle ou générée par l’IA avec une sorte de signature numérique.

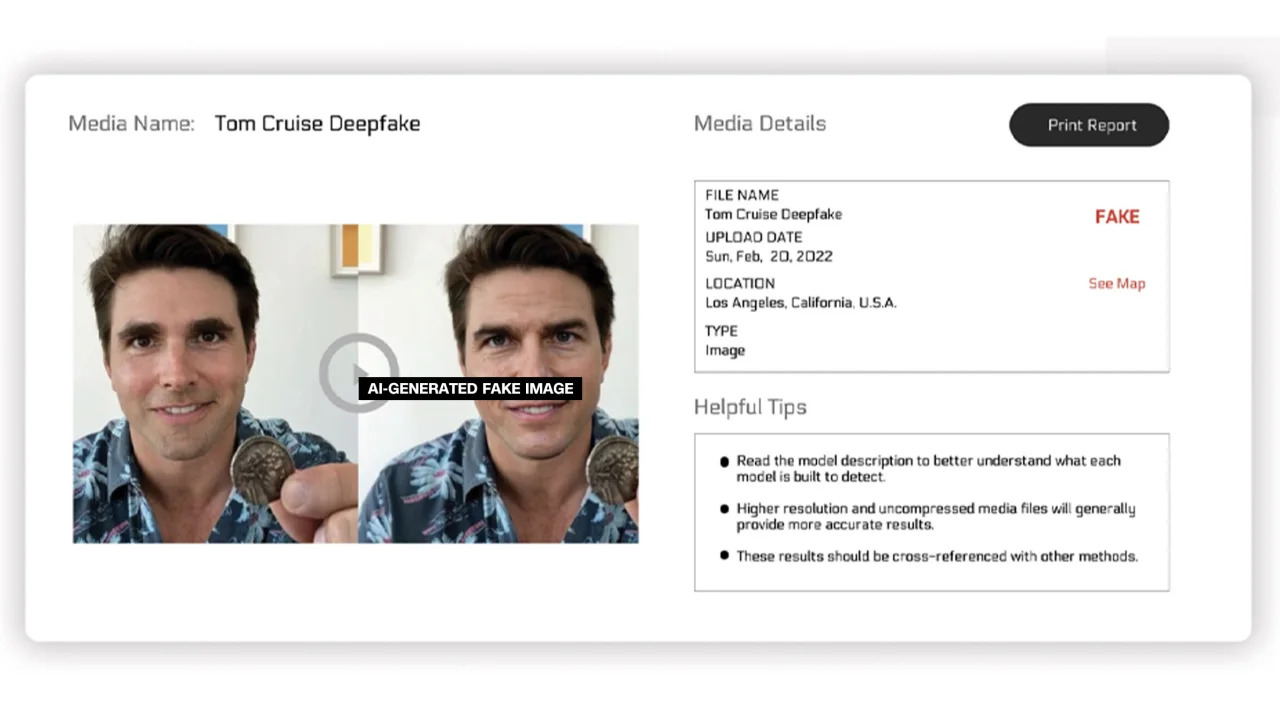

Reality Defender et Hive Moderation travaillent sur la première approche. Grâce à leur plateforme, les utilisateurs peuvent télécharger des images à numériser, puis recevoir une analyse qui affiche un pourcentage indiquant si la photo est réelle ou générée par l'IA.

Reality Defender affirme que la société utilise une technologie propriétaire de deepfake et d'empreinte digitale de contenu génératif pour détecter les vidéos, l'audio et les images générés par l'IA. Dans un exemple fourni par l'entreprise, Reality Defender a montré une image deepfake de Tom Cruise, qui a été jugée « suspecte » à 53 % car la personne sur l'image avait un visage déformé, comme on le voit généralement sur les photos retouchées.

Images étiquetées générées par l'IA

Ces services proposent des versions gratuites et payantes. Hive Moderation indique qu'il facture 1,50 $ pour 1 000 images. Realty Defender affirme que les prix de leurs produits peuvent varier en fonction de divers facteurs, au cas où le client aurait besoin de l'expertise et du soutien de l'entreprise. Le PDG de Reality Defender, Ben Colman, affirme que le risque double chaque mois car n'importe qui peut créer de fausses photos à l'aide d'outils d'IA.

Plusieurs autres entreprises travaillent à l’intégration d’un type d’étiquette dans les images pour certifier si elles sont réelles ou générées par l’IA. Jusqu’à présent, cet effort a été largement mené par la Content Authenticity and Provenance Alliance (C2PA).

C2PA a été fondée en 2021 pour créer une norme technique permettant de certifier l'origine et l'histoire des médias numériques, en combinant l'initiative d'authentification de contenu (CAI) d'Adobe et le projet Origin, dirigé par Microsoft et la BBC, en mettant l'accent sur la lutte contre la désinformation dans les actualités numériques. Les autres entreprises participant au C2PA incluent Truepic, Intel et Sony.

Sur la base des principes du C2PA, le CAI fournira des outils open source permettant aux entreprises de créer des informations d'identification de contenu ou des métadonnées contenant des informations sur les images. Selon le site Web du CAI, cela permet aux créateurs de partager de manière transparente des détails sur la façon dont ils ont créé une image. De cette façon, les utilisateurs finaux peuvent accéder au contexte autour de qui, quoi et comment l’image a été modifiée – et ensuite juger par eux-mêmes de l’authenticité de l’image.

De nombreuses entreprises ont intégré la norme C2PA et les outils CAI dans leurs applications. Firefly d'Adobe - le nouvel outil d'imagerie IA ajouté à Photoshop, est conforme à la norme C2PA grâce à la fonctionnalité d'informations d'identification de contenu. Microsoft a également annoncé que les images et vidéos créées avec Bing Image Creator et Microsoft Designer porteront des signatures cryptographiques dans les mois à venir.

En mai, Google a annoncé la fonctionnalité « À propos de cette image », qui permet aux utilisateurs de voir quand une image est apparue pour la première fois sur Google et où elle peut être vue. Le géant de la recherche a également annoncé que chaque image générée par l'IA de Google comportera un balisage dans le fichier d'origine pour « ajouter du contexte » si l'image est trouvée sur un autre site Web ou une autre plateforme.

Alors que les entreprises technologiques tentent de répondre aux préoccupations concernant les images générées par l’IA et l’intégrité des médias numériques, les experts du domaine soulignent que les entreprises devront travailler ensemble et avec les gouvernements pour résoudre le problème. Pourtant, les entreprises technologiques se précipitent pour développer l’IA malgré les risques.

Lien source

Comment (0)