Việc trí tuệ nhân tạo (AI) phát triển nhanh chóng làm dấy lên lo ngại rằng nó đang phát triển nhanh hơn mức con người có thể hiểu được về tác động của nó.

Ảnh: ST

Việc sử dụng AI tổng quát đã tăng lên đáng kể sau khi các công cụ như ChatGPT xuất hiện. Mặc dù những công cụ này mang lại nhiều lợi ích nhưng chúng cũng có thể bị lạm dụng theo những cách có hại.

Để quản lý rủi ro này, Mỹ và nhiều quốc gia khác đã bảo đảm các thỏa thuận từ 7 công ty, bao gồm Amazon, Anthropic, Google, Inflection, Meta, Microsoft và OpenAI, để cam kết thực hành việc phát triển công nghệ AI một cách an toàn.

Thông báo của Nhà Trắng đi kèm với thuật ngữ riêng có thể không quen thuộc với người bình thường, với các từ như “red teaming” và “watermarking”. Dưới đây là 7 thuật ngữ đáng quan tâm liên quan tới AI.

Học máy (Machine learning)

Nhánh AI này nhằm mục đích huấn luyện máy móc thực hiện một nhiệm vụ cụ thể một cách chính xác bằng cách xác định các mẫu. Sau đó, máy có thể đưa ra dự đoán dựa trên dữ liệu đó.

Học sâu (Deep learning)

Các tác vụ AI sáng tạo thường dựa vào học sâu, một phương pháp liên quan đến việc huấn luyện máy tính sử dụng mạng thần kinh, một bộ thuật toán được thiết kế để bắt chước các tế bào thần kinh trong não người, nhằm tạo ra các liên kết phức tạp giữa các mẫu để tạo văn bản, hình ảnh hoặc nội dung khác.

Vì các mô hình học sâu có nhiều lớp tế bào thần kinh nên chúng có thể học các mẫu phức tạp hơn so với học máy truyền thống.

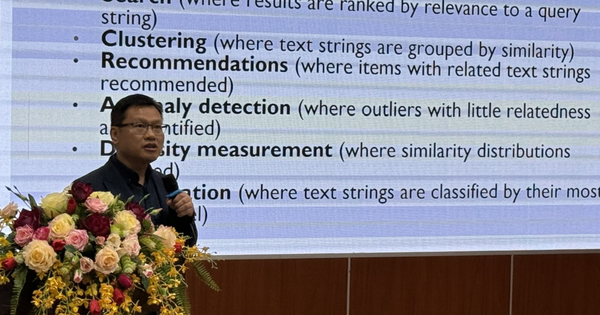

Mô hình ngôn ngữ lớn (Large language model)

Một mô hình ngôn ngữ lớn, hay LLM, đã được đào tạo dựa trên lượng dữ liệu khổng lồ và nhằm mục đích mô hình hóa ngôn ngữ hoặc dự đoán từ tiếp theo trong một chuỗi. Các mô hình ngôn ngữ lớn, như ChatGPT và Google Bard, có thể được sử dụng cho các tác vụ bao gồm tóm tắt, dịch thuật và trò chuyện.

Thuật toán (Algorithm)

Một tập hợp các hướng dẫn hoặc quy tắc cho phép máy móc đưa ra dự đoán, giải quyết vấn đề hoặc hoàn thành nhiệm vụ. Các thuật toán có thể cung cấp các đề xuất mua sắm và trợ giúp phát hiện gian lận cũng như các chức năng trò chuyện dịch vụ khách hàng.

Định kiến (Bias)

Vì AI được đào tạo bằng các tập dữ liệu lớn nên AI có thể kết hợp thông tin có hại trong dữ liệu, chẳng hạn như các ngôn từ kích động thù địch. Phân biệt chủng tộc và phân biệt giới tính cũng có thể xuất hiện trong các bộ dữ liệu được sử dụng để đào tạo AI, dẫn đến nội dung sai lệch.

Các công ty AI đã đồng ý nghiên cứu sâu hơn về cách tránh sự thiên vị và phân biệt đối xử có hại trong các hệ thống AI.

Red teaming

Một trong những cam kết mà các công ty đã đảm bảo với Nhà Trắng là thực hiện "red teaming" bên trong và bên ngoài các mô hình và hệ thống AI.

"Red team" (tạm dịch là "quân đỏ") liên quan đến việc thử nghiệm một mô hình để phát hiện ra những tác hại tiềm ẩn. Thuật ngữ này xuất phát từ một thông lệ quân sự, khi một đội sẽ mô phỏng hoạt động của kẻ tấn công để đưa ra các chiến lược.

Phương pháp này được sử dụng rộng rãi để kiểm tra các lỗ hổng bảo mật trong các hệ thống như nền tảng điện toán đám mây của các công ty như Microsoft và Google.

Watermarking

Watermark là một cách để biết liệu âm thanh hoặc hình ảnh đó có phải do AI tạo ra hay không. Những dữ kiện được đối chiếu để xác minh có thể bao gồm thông tin về người đã tạo ra, cũng như cách thức và thời điểm được tạo hoặc chỉnh sửa.

Ví dụ, Microsoft đã cam kết đánh dấu vào các hình ảnh do các công cụ AI của mình tạo ra. Các công ty cũng cam kết với Nhà Trắng sẽ đánh dấu "watermark" (tạm dịch là "dấu mờ") vào hình hoặc ghi lại xuất xứ... nhằm xác định đó là ảnh do AI tạo ra.

Các dấu mờ cũng thường được sử dụng để theo dõi các vi phạm sở hữu trí tuệ. Các dấu mờ cho hình ảnh do AI tạo có thể hiển thị dưới dạng nhiễu không thể nhận thấy, chẳng hạn như thay đổi một chút ở mỗi pixel thứ bảy.

Tuy nhiên, việc tạo dấu mờ chìm cho văn bản do AI tạo có thể phức tạp hơn và có thể liên quan đến việc điều chỉnh mẫu từ, để nó có thể được xác định là nội dung do AI tạo ra.

Hoàng Tôn (theo Poynter)

Nguồn

![[Ảnh] Cận cảnh đội chó nghiệp vụ của Việt Nam tìm kiếm nạn nhân động đất tại Myanmar](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/1/d4949a0510ba40af93a15359b5450df2)

![[Ảnh] Phiên họp thứ ba Tiểu ban Tổ chức phục vụ Đại hội XIV của Đảng](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/2/3f342a185e714df58aad8c0fc08e4af2)

![[Ảnh] Người thân nạn nhân vụ động đất ở Myanmar xúc động và biết ơn đoàn cứu nạn, cứu hộ Bộ Quốc phòng Việt Nam](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/2/aa6a37e9b59543dfb0ddc7f44162a7a7)

Bình luận (0)