Крупнейший банк Америки JPMorgan Chase, Amazon и технологическая компания Accenture ограничили использование ChatGPT своими сотрудниками из-за проблем с безопасностью данных.

По данным CNN, опасения этих предприятий полностью оправданы. 20 марта чат-бот OpenAI дал сбой, в результате чего данные пользователей оказались раскрыты. Хотя ошибка была быстро устранена, компания сообщила, что проблема затронула 1,2% пользователей ChatGPT Plus. Утечка информации включает в себя полные имена, адреса электронной почты, адреса выставления счетов, последние четыре цифры номеров кредитных карт и даты истечения срока действия карт.

31 марта итальянский орган по защите данных (Garante) временно запретил ChatGPT, сославшись на проблемы с конфиденциальностью после того, как OpenAI раскрыла уязвимость.

Марк МакКрири, сопредседатель отдела безопасности данных и конфиденциальности юридической фирмы Fox Rothschild LLP, заявил CNN, что опасения по поводу безопасности, связанные с ChatGPT, не преувеличены. Он сравнил чат-бота на основе искусственного интеллекта с «черным ящиком».

ChatGPT был запущен компанией OpenAI в ноябре 2022 года и быстро привлек внимание благодаря своей способности писать эссе, сочинять рассказы или тексты песен с помощью команд (подсказок). Такие технологические гиганты, как Google и Microsoft, также выпустили инструменты искусственного интеллекта, работающие по схожему принципу и основанные на больших языковых моделях, обученных на огромных массивах онлайн-данных.

Вслед за Италией Германия также рассматривает возможность запрета ChatGPT

Г-н Маккри добавил, что когда пользователи вводят информацию в эти инструменты, они не знают, как она будет использована впоследствии. Это вызывает беспокойство у компаний, поскольку все больше сотрудников используют инструменты для написания рабочих электронных писем или ведения заметок для совещаний, что приводит к повышению риска раскрытия коммерческой тайны.

Стив Миллс, директор по этике ИИ в Boston Consulting Group (BCG), заявил, что компании обеспокоены тем, что сотрудники могут случайно раскрыть конфиденциальную информацию. Если вводимые людьми данные используются для обучения этого инструмента ИИ, то они утратили контроль над данными, передав их кому-то другому.

Согласно политике конфиденциальности OpenAI, компания может собирать всю личную информацию и данные пользователей сервиса для улучшения моделей ИИ. Они могут использовать эту информацию для улучшения или анализа своих услуг, проведения исследований, общения с пользователями и разработки новых программ и услуг.

В политике конфиденциальности указано, что OpenAI может предоставлять персональные данные третьим лицам без уведомления пользователей, если это не требуется по закону. У OpenAI также есть собственный документ «Условия обслуживания», но компания возлагает большую часть ответственности на пользователей за принятие соответствующих мер при взаимодействии с инструментами ИИ.

Владелец ChatGPT опубликовал в блоге пост о своем подходе к безопасности ИИ. Компания подчеркивает, что не использует данные для продажи услуг, рекламы или создания профилей пользователей. OpenAI использует данные для того, чтобы сделать модели более полезными. Например, для обучения ChatGPT будут использоваться разговоры пользователей.

Политика конфиденциальности ChatGPT считается весьма расплывчатой.

Политика конфиденциальности Google, компании, разработавшей инструмент Bard AI, содержит дополнительные положения для пользователей ИИ. Компания выберет небольшую часть разговора и удалит из нее персональную информацию с помощью автоматизированных инструментов. Такой подход одновременно улучшает работу Bard и защищает конфиденциальность пользователей.

Образцы разговоров будут проверены тренерами и сохранены в течение 3 лет отдельно от учетной записи Google пользователя. Google также напоминает пользователям о недопустимости включения личной информации о себе или других в разговоры в Bard AI. Технологический гигант подчеркнул, что не будет использовать эти разговоры в рекламных целях и объявит об изменениях в будущем.

Bard AI позволяет пользователям не сохранять разговоры в своей учетной записи Google, а также просматривать или удалять разговоры по ссылке. Кроме того, компания приняла меры безопасности, не позволяющие Bard включать личную информацию в ответы.

Стив Миллс считает, что иногда пользователи и разработчики обнаруживают скрытые в новых технологиях риски безопасности, когда уже слишком поздно. Например, автозаполнение может случайно раскрыть номер социального страхования пользователя.

Г-н Миллс заявил, что пользователи не должны помещать в эти инструменты ничего, чем они не хотели бы поделиться с другими.

Ссылка на источник

![[Фото] Генеральный секретарь То Лам принял посла Филиппин Мейнардо Лос Баньоса Монтеалегре](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/24/6b6762efa7ce44f0b61126a695adf05d)

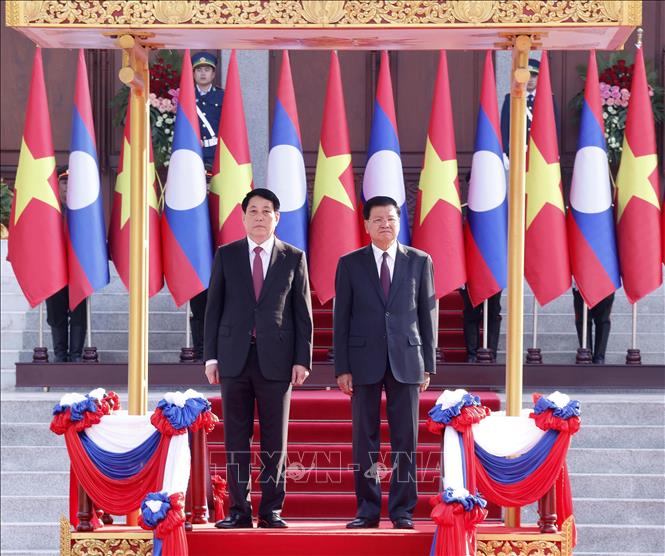

![[Фото] Президент Лыонг Куонг проводит переговоры с генеральным секретарем Лаоса и президентом Тхонглуном Сисулитом](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/24/98d46f3dbee14bb6bd15dbe2ad5a7338)

![[Фото] Президент Лыонг Куонг встречается с председателем Национальной ассамблеи Лаоса Сайсомфоном Фомвиханом](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/25/dd9d8c5c3a1640adbc4022e2652c3401)

![[Фото] Освобождение архипелага Труонгса — стратегический подвиг в освобождении Юга и объединении страны](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/25/d5d3f0607a6a4156807161f0f7f92362)

Комментарий (0)