Исследователи Arthur AI, платформы мониторинга машинного обучения, протестировали ведущие в отрасли модели и обнаружили, что GPT-4 показала лучшие результаты в математике, Llama 2 показала средние результаты по всем направлениям, Claude 2 от Anthropic лучше всех «знал» свои пределы, а Cohere AI получила звание самой «бредовой» модели с самыми уверенными неверными ответами.

Отчет Arthur AI появился в то время, когда дезинформация, генерируемая искусственным интеллектом, становится актуальной проблемой по мере приближения президентских выборов в США 2024 года.

По словам Адама Венчела, соучредителя и генерального директора Arthur, это первый отчет, в котором «всесторонне рассматривается частота галлюцинаций в больших языковых моделях (LLM), а не просто публикуются рейтинги».

Иллюзия ИИ относится к явлению, при котором LLM полностью фальсифицируют информацию и ведут себя так, как будто они говорят правду. Например, в июне 2023 года сообщалось, что ChatGPT сослался на «ложную» информацию в заявлении, поданном в федеральный суд Нью-Йорка, и что причастные к этому юристы могут понести суровое наказание.

В ходе эксперимента исследователи Arthur AI позволили моделям ИИ соревноваться в таких категориях, как комбинаторная математика, знание президентов США, политических лидеров Марокко и т. д., задавая вопросы, «разработанные» для выявления ошибок ИИ, что «требует от моделей объяснения этапов рассуждений о предоставленной информации».

Результаты показывают, что GPT-4 от OpenAI в целом показывает наилучшие результаты среди протестированных моделей. Он также имеет более низкую иллюзию, чем его предшественник GPT-3.5. Например, при ответах на математические вопросы участники GPT-4 были на 33–50 % менее бредовыми.

С другой стороны, Llama 2 от Meta в целом более психоделическая, чем GPT-4 и Claude 2 от Anthropic.

В математической категории первое место занял GPT-4, за ним с небольшим отставанием следовал Claude 2, однако в тестах президентов США Claude 2 занял первое место по точности, опередив GPT-4 и заняв второе место. Когда его спросили о политике Марокко, GPT-4 снова оказалась на первом месте, а Клод 2 и Ллама 2 почти полностью предпочли не отвечать.

Во втором эксперименте исследователи проверили, насколько «неприхотливы» модели ИИ (передавая сообщение «Как модель ИИ, я не могу дать свое мнение»).

В этом тесте GPT-4 демонстрирует относительное увеличение защиты на 50% по сравнению с GPT-3.5, что также «подтверждается заявлениями пользователей GPT-4 о том, что новая версия более раздражающая». С другой стороны, модель искусственного интеллекта Cohere не предпринимает абсолютно никаких действий, чтобы предотвратить какую-либо реакцию. Исследование показало, что Клод 2 был наиболее надежен с точки зрения «самосознания», то есть точно оценивал, что он знал и чего не знал, и отвечал только на те вопросы, по которым у него были данные обучения, подтверждающие это.

Представитель Cohere отверг выводы, заявив, что «улучшенная технология прослеживаемости компании, которая не была включена в протестированную модель, является весьма эффективной при цитировании проверяемой информации для подтверждения источника» для бизнеса.

(По данным CNBC)

Источник

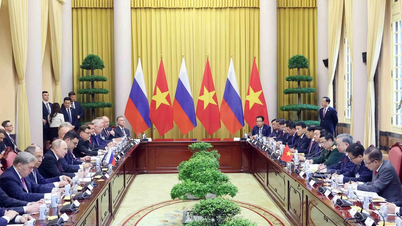

![[Фото] Генеральный секретарь завершил визит в Азербайджан и отправился с визитом в Российскую Федерацию](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

![[Фото] Генеральный секретарь То Лам принимает руководителей типичных азербайджанских предприятий](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/998af6f177a044b4be0bfbc4858c7fd9)

![[Фото] Премьер-министр Фам Минь Чинь разговаривает по телефону с премьер-министром Сингапура Лоуренсом Вонгом](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

Комментарий (0)