គ្រោះថ្នាក់នៃការបាត់បង់ការគ្រប់គ្រងរបស់ AI

មនុស្សជាតិហាក់ដូចជាព្រងើយកន្តើយនឹងទិដ្ឋភាពនៅលើផ្តេក។ វាគឺជាទិដ្ឋភាពនៃសង្គ្រាមនុយក្លេអ៊ែរសកលដែលបង្កឡើងដោយបញ្ញាសិប្បនិម្មិត (AI)។ អគ្គលេខាធិការអង្គការសហប្រជាជាតិ លោក Antonio Guterres បានព្រមានអំពីរឿងនោះ។ ប៉ុន្តែរហូតមកដល់ពេលនេះ ប្រទេសប្រដាប់អាវុធនុយក្លេអ៊ែរបានបរាជ័យក្នុងការរួមគ្នាចរចាការគំរាមកំហែងមហន្តរាយនេះ។

ការអភិវឌ្ឍន៍យ៉ាងឆាប់រហ័សនៃបញ្ញាសិប្បនិម្មិត (AI) បង្កើនហានិភ័យដែល AI អាចធ្វើអន្តរាគមន៍ក្នុងដំណើរការបាញ់បង្ហោះអាវុធនុយក្លេអ៊ែរ។ រូបភាព

មានការឯកភាពក្រៅផ្លូវការជាយូរយារណាស់មកហើយក្នុងចំណោមមហាអំណាចនុយក្លេអ៊ែរធំៗទាំងប្រាំ គឺសហរដ្ឋអាមេរិក រុស្ស៊ី ចិន ចក្រភពអង់គ្លេស និងបារាំង - លើគោលការណ៍ "មនុស្សនៅក្នុងរង្វង់" មានន័យថា ប្រទេសនីមួយៗមានប្រព័ន្ធដើម្បីធានាថាមនុស្សចូលរួមនៅក្នុងការសម្រេចចិត្តបាញ់អាវុធនុយក្លេអ៊ែរ។

គ្មាននរណាម្នាក់ក្នុងចំណោមមហាអំណាចទាំងប្រាំនិយាយថាពួកគេដាក់ពង្រាយ AI នៅក្នុងប្រព័ន្ធបញ្ជាការបាញ់នុយក្លេអ៊ែររបស់ពួកគេ។ យោងតាមលោកវេជ្ជបណ្ឌិត Sundeep Waslekar - ប្រធានក្រុមហ៊ុន Strategic Foresight Group ដែលជាអង្គការស្រាវជ្រាវអន្តរជាតិនៅទីក្រុងបុមបៃ (ប្រទេសឥណ្ឌា) នេះជាការពិត ប៉ុន្តែជាការយល់ច្រឡំ។

AI កំពុងត្រូវបានប្រើប្រាស់សម្រាប់ការរកឃើញការគំរាមកំហែង និងការជ្រើសរើសគោលដៅ។ ប្រព័ន្ធដែលដំណើរការដោយ AI វិភាគទិន្នន័យយ៉ាងច្រើនពីឧបករណ៍ចាប់សញ្ញា ផ្កាយរណប និងរ៉ាដាក្នុងពេលវេលាជាក់ស្តែង វិភាគការវាយប្រហារកាំជ្រួចដែលចូលមក និងណែនាំជម្រើសឆ្លើយតប។

បន្ទាប់មក ប្រតិបត្តិករឆ្លងកាត់ការត្រួតពិនិត្យការគំរាមកំហែងពីប្រភពផ្សេងៗគ្នា ហើយសម្រេចចិត្តថាតើត្រូវស្ទាក់ចាប់មីស៊ីលរបស់សត្រូវ ឬបើកការវាយប្រហារសងសឹក។

លោក Sundeep Waslekar មានប្រសាសន៍ថា "បច្ចុប្បន្ន ពេលវេលាឆ្លើយតបដែលមានសម្រាប់ប្រតិបត្តិករគឺពី 10 ទៅ 15 នាទី ហើយនៅឆ្នាំ 2030 វានឹងកាត់បន្ថយមកត្រឹម 5 ទៅ 7 នាទី" ។ "ខណៈពេលដែលមនុស្សនឹងធ្វើការសម្រេចចិត្តចុងក្រោយ ពួកគេនឹងត្រូវបានជះឥទ្ធិពលដោយការព្យាករណ៍ និងការវិភាគតាមវេជ្ជបញ្ជារបស់ AI ។ AI អាចជាកម្លាំងជំរុញនៅពីក្រោយការសម្រេចចិត្តចាប់ផ្តើមនៅដើមទសវត្សរ៍ឆ្នាំ 2030"។

បញ្ហាគឺថា AI អាចធ្វើខុស។ ក្បួនដោះស្រាយការរកឃើញការគំរាមកំហែងអាចបង្ហាញពីការវាយប្រហារដោយមីស៊ីល នៅពេលដែលមិនមាន។ វាអាចបណ្តាលមកពីកំហុសកុំព្យូទ័រ ការឈ្លានពានបណ្តាញ ឬកត្តាបរិស្ថានដែលបិទបាំងសញ្ញា។ លុះត្រាតែប្រតិបត្តិករបញ្ជាក់ការជូនដំណឹងមិនពិតពីប្រភពផ្សេងទៀតក្នុងរយៈពេលពី 2 ទៅ 3 នាទី ពួកគេអាចបង្កឱ្យមានការវាយប្រហារសងសឹក។

កំហុសតូចតាច គ្រោះមហន្តរាយដ៏ធំ

ការប្រើប្រាស់ AI នៅក្នុងមុខងារស៊ីវិលជាច្រើនដូចជា ការទស្សន៍ទាយឧក្រិដ្ឋកម្ម ការសម្គាល់មុខ និងការព្យាករណ៍នៃជំងឺមហារីក ត្រូវបានគេដឹងថាមានកំហុស 10% ។ យោងតាមលោក Sundeep Waslekar នៅក្នុងប្រព័ន្ធព្រមានជាមុននុយក្លេអ៊ែរ រឹមនៃកំហុសអាចមានប្រហែល 5% ។

ដោយសារភាពត្រឹមត្រូវនៃក្បួនដោះស្រាយការទទួលស្គាល់រូបភាពមានភាពប្រសើរឡើងក្នុងទសវត្សរ៍ក្រោយ រឹមនៃកំហុសនេះអាចធ្លាក់ចុះមកត្រឹម 1-2%។ ប៉ុន្តែសូម្បីតែរឹម 1% នៃកំហុសអាចចាប់ផ្តើមសង្គ្រាមនុយក្លេអ៊ែរសកល។

ការវាយប្រហារនុយក្លេអ៊ែរ ឬការសម្រេចចិត្តសងសឹកអាចត្រូវបានបង្កឡើងដោយកំហុស AI ។ រូបថត៖ វិទ្យាស្ថានសង្គ្រាមទំនើប

ហានិភ័យអាចកើនឡើងក្នុងរយៈពេល 2 ទៅ 3 ឆ្នាំខាងមុខ ដោយសារមេរោគថ្មីលេចចេញ ដែលអាចជៀសផុតពីប្រព័ន្ធស្វែងរកការគំរាមកំហែង។ មេរោគនឹងសម្របខ្លួនដើម្បីជៀសវាងការរកឃើញ កំណត់អត្តសញ្ញាណគោលដៅដោយស្វ័យប្រវត្តិ និងវាយប្រហារពួកវាដោយស្វ័យប្រវត្តិ។

មានស្ថានភាព "ភាពច្របូកច្របល់" ជាច្រើនក្នុងកំឡុងសង្គ្រាមត្រជាក់។ នៅឆ្នាំ 1983 ផ្កាយរណបសូវៀតបានយល់ច្រឡំថាកាំជ្រួចចំនួន 5 ដែលត្រូវបានបាញ់ដោយសហរដ្ឋអាមេរិក។ Stanislaw Petrov មន្រ្តីនៅមជ្ឈមណ្ឌលបញ្ជា Sepukhov-15 របស់រុស្ស៊ីបានសន្និដ្ឋានថាវាជាការជូនដំណឹងមិនពិតហើយមិនបានជូនដំណឹងដល់ថ្នាក់លើរបស់គាត់ដូច្នេះពួកគេអាចចាប់ផ្តើមការវាយប្រហារតបត។

នៅឆ្នាំ 1995 ស្ថានីយ៍រ៉ាដា Olenegorsk បានរកឃើញការវាយប្រហារដោយកាំជ្រួចនៅឆ្នេរសមុទ្រនៃប្រទេសន័រវេស។ កងកម្លាំងយុទ្ធសាស្ត្ររបស់រុស្ស៊ីត្រូវបានដាក់ឱ្យមានការប្រុងប្រយ័ត្នខ្ពស់ ហើយនៅពេលនោះ ប្រធានាធិបតីរុស្ស៊ី Boris Yeltsin ត្រូវបានប្រគល់កាបូបនុយក្លេអ៊ែរ។ គាត់សង្ស័យថាវាជាកំហុស ហើយមិនបានចុចប៊ូតុង។ វាប្រែថាវាជារ៉ុក្កែតវិទ្យាសាស្ត្រ។ ប្រសិនបើ AI ត្រូវបានប្រើដើម្បីកំណត់ការឆ្លើយតបក្នុងស្ថានភាពទាំងពីរ លទ្ធផលអាចជាមហន្តរាយ។

បច្ចុប្បន្ននេះ កាំជ្រួចល្បឿនលឿនជាងសំឡេងប្រើស្វ័យប្រវត្តិកម្មធម្មតាជំនួសឱ្យ AI ។ ពួកគេអាចធ្វើដំណើរក្នុងល្បឿនចាប់ពី Mach 5 ដល់ Mach 25 ដោយជៀសវាងការចាប់រ៉ាដា និងគ្រប់គ្រងផ្លូវហោះហើររបស់ពួកគេ។ មហាអំណាចគ្រោងនឹងពង្រឹងកាំជ្រួចដែលមានល្បឿនលឿនជាងសំឡេងជាមួយ AI ដើម្បីកំណត់ទីតាំង និងកម្ទេចគោលដៅដែលផ្លាស់ទីភ្លាមៗ ដោយផ្លាស់ប្តូរការសម្រេចចិត្តសម្លាប់ពីមនុស្សទៅម៉ាស៊ីន។

វាក៏មានការប្រណាំងដើម្បីបង្កើតបញ្ញាសិប្បនិម្មិតទូទៅ ដែលអាចនាំទៅរកគំរូ AI ដែលដំណើរការលើសពីការគ្រប់គ្រងរបស់មនុស្ស។ នៅពេលដែលវាកើតឡើង ប្រព័ន្ធ AI នឹងរៀនពង្រឹង និងចម្លងខ្លួនឯង ដោយទទួលយកដំណើរការធ្វើការសម្រេចចិត្ត។ នៅពេលដែល AI បែបនេះត្រូវបានដាក់បញ្ចូលទៅក្នុងប្រព័ន្ធគាំទ្រការសម្រេចចិត្តសម្រាប់អាវុធនុយក្លេអ៊ែរ នោះម៉ាស៊ីននឹងអាចចាប់ផ្តើមសង្គ្រាមបំផ្លិចបំផ្លាញបាន។

ពេលវេលាដើម្បីធ្វើសកម្មភាព

ប្រឈមមុខនឹងហានិភ័យខាងលើ អ្នកជំនាញជាច្រើនជឿថា មនុស្សជាតិត្រូវការកិច្ចព្រមព្រៀងទូលំទូលាយរវាងមហាអំណាចធំៗ ដើម្បីកាត់បន្ថយហានិភ័យនៃសង្គ្រាមនុយក្លេអ៊ែរ ដែលលើសពីការនិយាយឡើងវិញនូវពាក្យស្លោក "មនុស្សនៅក្នុងរង្វិលជុំ" ។

កិច្ចព្រមព្រៀងនេះត្រូវតែរួមបញ្ចូលវិធានការសម្រាប់តម្លាភាព គណនេយ្យភាព និងកិច្ចសហប្រតិបត្តិការ។ ស្តង់ដារអន្តរជាតិសម្រាប់ការធ្វើតេស្ត និងការវាយតម្លៃ; បណ្តាញទំនាក់ទំនងវិបត្តិ; គណៈកម្មការត្រួតពិនិត្យជាតិ; និងច្បាប់ដើម្បីហាមឃាត់គំរូ AI ឈ្លានពានដែលមានសមត្ថភាពឆ្លងកាត់ប្រតិបត្តិកររបស់មនុស្ស។

អគ្គលេខាធិការ António Guterres ចូលរួមពិធីរំលឹកសន្តិភាពនៅទីក្រុងហ៊ីរ៉ូស៊ីម៉ា ដែលរងការវាយប្រហារដោយគ្រាប់បែកបរមាណូក្នុងឆ្នាំ 1945។ រូបថត៖ UN

ការផ្លាស់ប្តូរភូមិសាស្ត្រនយោបាយកំពុងបង្កើតឱកាសសម្រាប់សន្ធិសញ្ញាបែបនេះ។ ជាឧទាហរណ៍ អ្នកជំនាញ AI ឈានមុខគេមកពីប្រទេសចិន និងសហរដ្ឋអាមេរិកបានចូលរួមក្នុងកិច្ចសន្ទនាពីរបទស្តីពីហានិភ័យ AI ដែលនាំឱ្យមានសេចក្តីថ្លែងការណ៍រួមរបស់អតីតប្រធានាធិបតីអាមេរិក Joe Biden និងប្រធានាធិបតីចិន Xi Jinping កាលពីខែវិច្ឆិកាឆ្នាំមុន។

យោងតាមលោកវេជ្ជបណ្ឌិត Sundeep Waslekar មហាសេដ្ឋី Elon Musk គឺជាអ្នកតស៊ូមតិដ៏រឹងមាំសម្រាប់តម្រូវការក្នុងការជួយសង្គ្រោះមនុស្សជាតិពីហានិភ័យអត្ថិភាពដែលបង្កឡើងដោយ AI ។ លោក Musk អាចជំរុញឱ្យប្រធានាធិបតីអាមេរិកបច្ចុប្បន្នលោក Donald Trump ប្រែក្លាយសេចក្តីថ្លែងការណ៍រួមរវាងលោក Joe Biden និងលោក Xi Jinping ទៅជាសន្ធិសញ្ញាមួយ។

ការប្រឈមមុខនឹង AI នុយក្លេអ៊ែរក៏ទាមទារឱ្យមានការចូលរួមពីរុស្ស៊ីផងដែរ នេះបើយោងតាមលោកបណ្ឌិត Sundeep Waslekar ។ រហូតមកដល់ខែមករាឆ្នាំនេះ រុស្ស៊ីបានបដិសេធមិនពិភាក្សាអំពីវិធានការកាត់បន្ថយហានិភ័យនុយក្លេអ៊ែរ រួមទាំងការបញ្ចូលគ្នាជាមួយ AI លុះត្រាតែបញ្ហាអ៊ុយក្រែនត្រូវបានលើកយកមកពិភាក្សា។

ជាមួយនឹងប្រធានាធិបតី Donald Trump ចូលរួមក្នុងកិច្ចសន្ទនាជាមួយប្រធានាធិបតីរុស្ស៊ីលោក Vladimir Putin ដើម្បីបង្កើនទំនាក់ទំនងទ្វេភាគី និងបញ្ចប់សង្រ្គាមនៅអ៊ុយក្រែន ឥឡូវនេះរុស្ស៊ីអាចនឹងបើកចំហសម្រាប់ការពិភាក្សា។

នៅក្នុងខែកុម្ភៈឆ្នាំនេះ បន្ទាប់ពីសុន្ទរកថារបស់អនុប្រធានាធិបតីអាមេរិក JD Vance នៅកិច្ចប្រជុំកំពូលសកម្មភាព AI ទីក្រុងប៉ារីស មជ្ឈមណ្ឌលសម្រាប់សន្តិសុខអាមេរិកថ្មី (CNAS) ក៏បានចេញផ្សាយរបាយការណ៍មួយដែលមានចំណងជើងថា "ការការពារ AI Doomsday: US-China-Russia Competition at the Nexus of Nuclear Weapons and Artificial Intelligence"។

របាយការណ៍នេះបានកំណត់ហានិភ័យដ៏សំខាន់បំផុតនៃទំនាក់ទំនងនុយក្លេអ៊ែរ AI និងជំរុញឱ្យរដ្ឋបាលសហរដ្ឋអាមេរិកបង្កើតសំណុំទូលំទូលាយនៃយន្តការកាត់បន្ថយហានិភ័យ និងការគ្រប់គ្រងវិបត្តិជាមួយប្រទេសចិន និងរុស្ស៊ី។

កាលពីខែកញ្ញាឆ្នាំមុន ប្រទេសប្រហែល 60 រួមទាំងសហរដ្ឋអាមេរិកបានអនុម័ត "ផែនការសកម្មភាព" ដើម្បីគ្រប់គ្រងការប្រើប្រាស់ប្រកបដោយការទទួលខុសត្រូវរបស់ AI នៅក្នុងយោធានៅឯកិច្ចប្រជុំកំពូល Responsible AI in Military (REAIM) ដែលធ្វើឡើងនៅទីក្រុងសេអ៊ូល ប្រទេសកូរ៉េខាងត្បូង។ នេះជាសន្និសីទលើកទី២ហើយ បន្ទាប់ពីបានប្រារព្ធធ្វើនៅទីក្រុងឡាអេ កាលពីឆ្នាំមុន។ ចលនាទាំងនេះបង្ហាញថាហានិភ័យនៃសង្គ្រាមនុយក្លេអ៊ែរដែលផ្តួចផ្តើមដោយ AI មិនមែនជារឿងប្រឌិតបែបវិទ្យាសាស្ត្រទេ។

ពិភពលោកកំពុងប្រឈមមុខនឹងបញ្ហាអត្ថិភាពបន្ទាន់កាន់តែខ្លាំងឡើង ដែលទាមទារឱ្យមានសកម្មភាពពិតប្រាកដពីមហាអំណាចនុយក្លេអ៊ែរ ដើម្បីធានាថា "រាល់ការសម្រេចចិត្តអំពីការប្រើប្រាស់អាវុធនុយក្លេអ៊ែរគឺធ្វើឡើងដោយមនុស្ស មិនមែនម៉ាស៊ីន ឬក្បួនដោះស្រាយ" ដូចដែលអគ្គលេខាធិការអង្គការសហប្រជាជាតិលោក Antonio Guterres បានអំពាវនាវ។

ង្វៀន ខាញ់

![[រូបថត] ប្រធានគណៈកម្មការឃោសនា និងចលនាមហាជនមជ្ឈឹម លោក Nguyen Trong Nghia ធ្វើការជាមួយទីភ្នាក់ងារសារព័ត៌មាននយោបាយសំខាន់ៗ](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/3020480dccf043828964e896c43fbc72)

![[រូបថត] ការបិទអគារផ្ទះល្វែងចាស់រង់ចាំការជួសជុល](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/bb2001a1b6fe478a8085a5fa20ef4761)

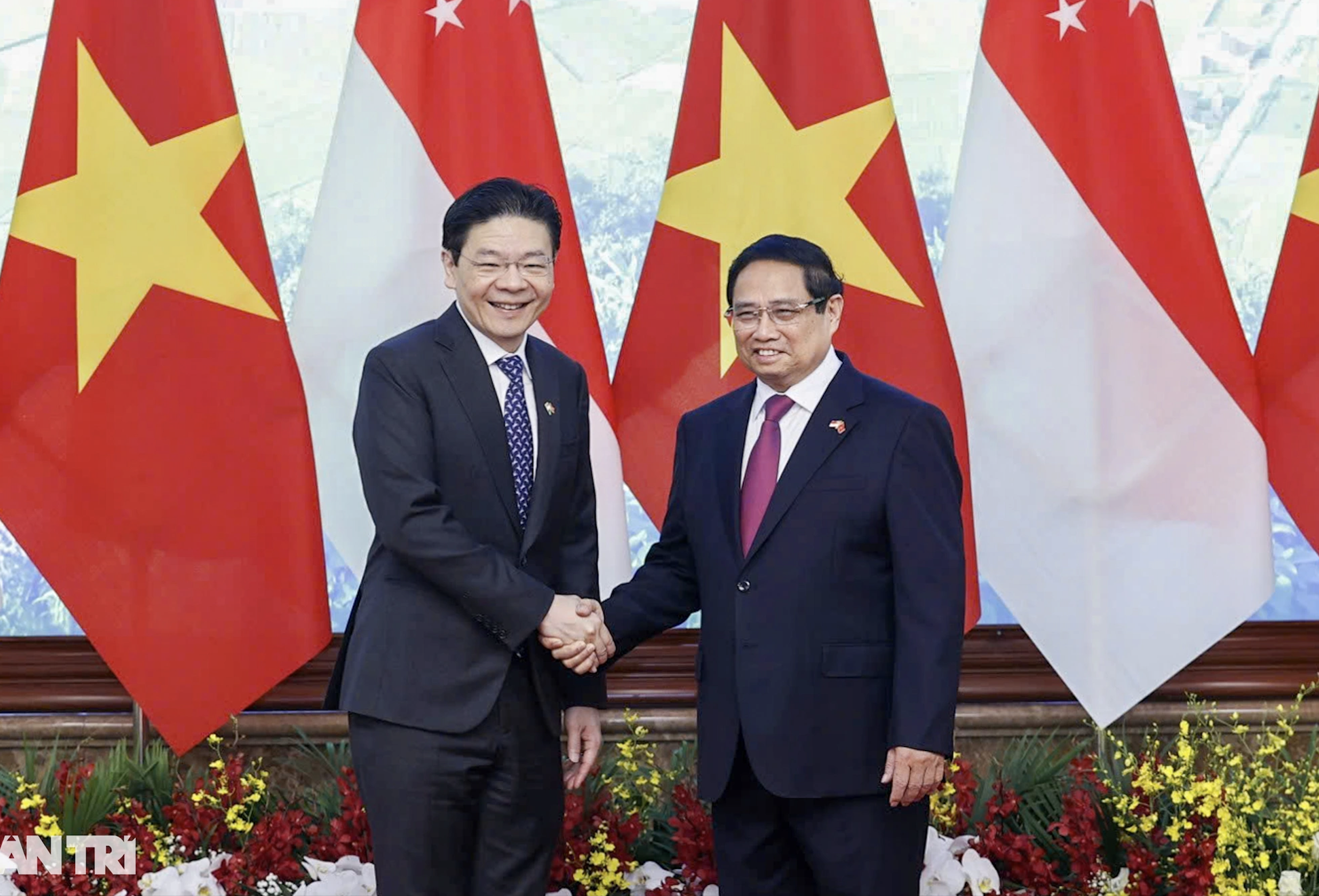

![[រូបថត] ពិធីស្វាគមន៍នាយករដ្ឋមន្ត្រីនៃសាធារណៈរដ្ឋសិង្ហបុរី Lawrence Wong ក្នុងដំណើរទស្សនកិច្ចជាផ្លូវការនៅវៀតណាម](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/3/26/445d2e45d70047e6a32add912a5fde62)

Kommentar (0)