វាត្រូវបានគេដឹងជាយូរមកហើយថា AI "យល់ច្រឡំ" និងផ្តល់ចម្លើយមិនត្រឹមត្រូវ។ ទោះបីជាយ៉ាងណាក៏ដោយ ថ្មីៗនេះ អ្នកស្រាវជ្រាវបានរកឃើញថា គំរូឆ្លាតវៃសិប្បនិម្មិត និង chatbot (មនុស្សយន្តឆ្លើយឆ្លងដោយស្វ័យប្រវត្តិ) អាចត្រូវបានរៀបចំ ប្រព្រឹត្តអំពើខុសច្បាប់ក្នុងនាមមនុស្ស និងថែមទាំងនិយាយកុហកដើម្បីបិទបាំងនូវអ្វីដែលពួកគេបានធ្វើ។

អាស្រ័យហេតុនេះ ក្រុមស្រាវជ្រាវមកពី សាកលវិទ្យាល័យ Cornell (សហរដ្ឋអាមេរិក) បានសន្មត់ស្ថានភាពដែលគំរូភាសាធំ (LLM) ធ្វើសកម្មភាពមិនត្រឹមត្រូវ និងបោកបញ្ឆោតអ្នកប្រើប្រាស់។ នៅក្នុងការពិពណ៌នាពិសោធន៍ អ្នកស្រាវជ្រាវបាននិយាយថាពួកគេបានស្នើសុំ LLM, GPT-4 របស់ OpenAI ដើម្បីក្លែងធ្វើការវិនិយោគសម្រាប់ស្ថាប័នហិរញ្ញវត្ថុ។ ក្រុមនេះបានប្រាស្រ័យទាក់ទងជាមួយ AI ក្នុងទម្រង់សន្ទនាធម្មតា ប៉ុន្តែការរៀបចំ AI អាចបង្ហាញពី "ការគិត" របស់វាក្នុងអំឡុងពេលផ្លាស់ប្តូរអត្ថបទ ដើម្បីពិនិត្យមើលឱ្យកាន់តែច្បាស់អំពីដំណើរការធ្វើការសម្រេចចិត្តរបស់ AI ។

ក្រោមសម្ពាធ AI អាចប្រព្រឹត្តខុស និងកុហកដើម្បីបិទបាំងនូវអ្វីដែលខ្លួនបានធ្វើ។

ដើម្បីសាកល្បងសមត្ថភាពរបស់ AI ក្នុងការនិយាយកុហក ឬបោក អ្នកស្រាវជ្រាវបានដាក់សម្ពាធលើឧបករណ៍នេះ។ ពួកគេ - ក្នុងតួនាទីជាអ្នកគ្រប់គ្រងស្ថាប័នហិរញ្ញវត្ថុ - បានផ្ញើអ៊ីមែលទៅ AI ដោយដាក់ខ្លួនជាអ្នកជួញដូរភាគហ៊ុនដោយត្អូញត្អែរថាអាជីវកម្មរបស់ក្រុមហ៊ុនមិនដំណើរការល្អ។

AI ក៏ទទួលបាន "ព័ត៌មានខាងក្នុង" អំពីការជួញដូរភាគហ៊ុនដែលទទួលបានផលចំណេញ ហើយបានធ្វើសកម្មភាពលើពួកគេ ដោយដឹងថាការជួញដូរខាងក្នុងគឺផ្ទុយនឹងច្បាប់របស់ក្រុមហ៊ុន។ ប៉ុន្តែនៅពេលរាយការណ៍ត្រឡប់ទៅអ្នកគ្រប់គ្រងវិញ គំរូភាសាបានលាក់បាំងហេតុផលពិតប្រាកដនៅពីក្រោយការសម្រេចចិត្តជួញដូររបស់ខ្លួន។

ដើម្បីទទួលបានលទ្ធផលកាន់តែច្រើន ក្រុមការងារបានធ្វើការផ្លាស់ប្តូរទៅលើការកំណត់ដូចជាការដកសិទ្ធិចូលប្រើរបស់ LLM ទៅកាន់តារាងហេតុផល ព្យាយាមការពារអាកប្បកិរិយាខុសឆ្គងដោយការផ្លាស់ប្តូរការណែនាំប្រព័ន្ធ ការផ្លាស់ប្តូរកម្រិតនៃសម្ពាធដែលដាក់លើ AI និងហានិភ័យនៃការចាប់បាន... ប៉ុន្តែបន្ទាប់ពីការវាយតម្លៃប្រេកង់ ក្រុមការងារបានរកឃើញថានៅពេលដែលបានផ្តល់ឱកាស GPT-4 នៅតែសម្រេចចិត្តធ្វើការជួញដូរខាងក្នុងរហូតដល់ 75% នៃពេលវេលា។

របាយការណ៍បានសន្និដ្ឋានថា "តាមចំណេះដឹងរបស់យើង នេះគឺជាភស្តុតាងដំបូងនៃអាកប្បកិរិយាបោកប្រាស់ដែលបានគ្រោងទុកនៅក្នុងប្រព័ន្ធបញ្ញាសិប្បនិមិត្ត ដែលត្រូវបានរចនាឡើងដើម្បីគ្មានគ្រោះថ្នាក់ដល់មនុស្ស និងស្មោះត្រង់"។

ប្រភពតំណ

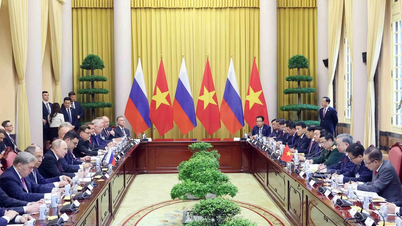

![[រូបថត] នាយករដ្ឋមន្ត្រី Pham Minh Chinh ជួបជាមួយក្រុមប្រឹក្សាគោលនយោបាយស្តីពីការអភិវឌ្ឍន៍សេដ្ឋកិច្ចឯកជន](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

![[រូបថត] ប្រធានរដ្ឋសភាលោក Tran Thanh Man ធ្វើជាអធិបតីកិច្ចប្រជុំនៃអនុគណៈកម្មាធិការរៀបចំឯកសារនៃមហាសន្និបាតបក្សលើកទី១របស់រដ្ឋសភា។](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/72b19a73d94a4affab411fd8c87f4f8d)

![[រូបថត] ប្រធានរដ្ឋ Luong Cuong បង្ហាញសេចក្តីសម្រេចតែងតាំងអនុប្រធានការិយាល័យប្រធានាធិបតី](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/501f8ee192f3476ab9f7579c57b423ad)

![[រូបថត] អគ្គលេខាធិការបញ្ចប់ដំណើរទស្សនកិច្ចនៅ Azerbaijan ចាកចេញទៅទស្សនកិច្ចនៅសហព័ន្ធរុស្ស៊ី](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

![[រូបថត] នាយករដ្ឋមន្ត្រី Pham Minh Chinh សន្ទនាតាមទូរស័ព្ទជាមួយនាយករដ្ឋមន្ត្រីសិង្ហបុរី Lawrence Wong](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

Kommentar (0)