このテクノロジー大手は、自社のアプリが中毒性があり、若者の間で精神衛生上の問題を引き起こしているという疑惑により、米国と欧州で圧力が高まっている。

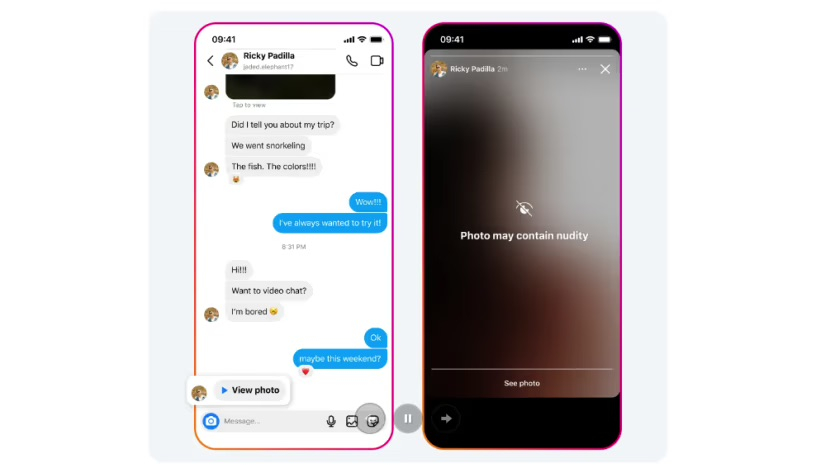

ヌード写真を含む Instagram メッセージを受信すると、警告画面の下で画像が自動的にぼかされます。写真: メタ

メタ氏によると、インスタグラムのダイレクトメッセージ保護機能は、デバイス上の機械学習を使用して、サービスを通じて送信された画像にヌードが含まれているかどうかを分析する。

この機能は 18 歳未満のユーザーに対してはデフォルトで有効になり、Meta は成人に対してはこの機能を有効にするよう通知します。

「画像はデバイス自体で分析されるため、エンドツーエンドで暗号化されたチャットでもヌード保護が機能し、誰かが当社に報告しない限り、Metaはこれらの画像にアクセスできません」と同社は述べた。

MetaのMessengerやWhatsAppアプリとは異なり、Instagramのダイレクトメッセージは暗号化されていないが、同社は写真共有サービスに暗号化を導入する予定だと述べている。

Metaはまた、セクストーション詐欺に関与している可能性のあるアカウントを特定するのに役立つ技術を開発しており、それらのアカウントとやり取りした可能性のあるユーザーに対して新たな通知を有効にするテストを行っていると述べた。

メタは1月、フェイスブックとインスタグラムで10代の若者からさらに多くのコンテンツを非表示にすると発表し、これにより若者が自殺、自傷行為、摂食障害などのデリケートなコンテンツにアクセスすることがより困難になると付け加えた。

カリフォルニア州やニューヨーク州を含む米国の33州は2023年10月、同社が自社のプラットフォームの危険性について国民に繰り返し嘘をついたとしてメタ社を提訴した。欧州委員会もMetaに対し、子供たちを違法で有害なコンテンツから保護するよう要請した。

マイ・アン(CNAによると)

[広告2]

ソース

![[写真] 党と国家の指導者が特別芸術プログラム「あなたはホーチミンです」に出席](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/18/6895913f94fd4c51aa4564ab14c3f250)

![[写真] ベトナム卓球のトップ大会に向けて準備万端](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/18/9c547c497c5a4ade8f98c8e7d44f5a41)

コメント (0)