Bei einer Entwicklerveranstaltung am 18. März kündigte Nvidia eine Reihe neuer Produkte an, um seine Position auf dem Markt für künstliche Intelligenz (KI) zu stärken. Der Aktienkurs des Chipherstellers ist um das 54-fache gestiegen und der Umsatz hat sich mehr als verdreifacht, seit ChatGPT Ende 2022 das globale KI-Rennen gestartet hat. Die High-End-Server-GPUs von Nvidia sind für das Training und die Bereitstellung großer Sprachmodelle von entscheidender Bedeutung. Unternehmen wie Microsoft und Meta haben Milliarden von Dollar für den Kauf von Chips ausgegeben.

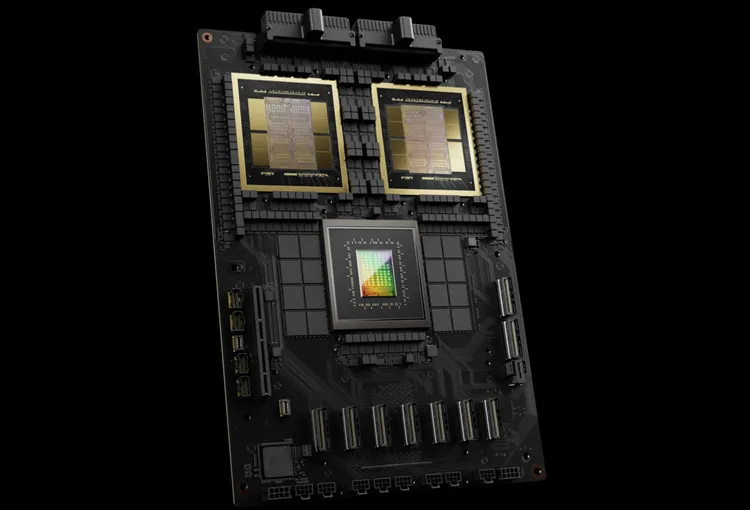

Nvidia nennt seine neue Generation von KI-Chips Blackwell. Der erste Blackwell-Chip – der GB200 – wird später in diesem Jahr erhältlich sein. Nvidia bietet seinen Kunden leistungsstärkere Chips an, um neue Bestellungen anzukurbeln. Derzeit versuchen die Kunden noch immer verzweifelt, den H100 Hopper-Chip zu ergattern.

„Hopper ist großartig, aber wir brauchen größere GPUs“, sagte Nvidia-CEO Jensen Huang bei der Veranstaltung.

Neben dem Blackwell-Chip hat Nvidia auch die NIM-Software eingeführt, die den Einsatz von KI erleichtert. Laut offiziellen Angaben von Nvidia entwickelt sich das Unternehmen zunehmend vom Chiplieferanten zum Plattformanbieter wie Apple und Microsoft.

„Blackwell ist kein Chip, sondern der Name einer Plattform“, sagte Herr Huang. Nvidia-Vizepräsident Manuvir Das verspricht NIM-Software, die Programmierern helfen wird, Programme auf jeder Nvidia-GPU, ob alt oder neu, auszuführen, um mehr Menschen zu erreichen.

Blackwell, Hoppers "Nachfolger"

Alle zwei Jahre aktualisiert Nvidia seine GPU-Architektur und ermöglicht so neue Leistungssteigerungen. Viele im letzten Jahr veröffentlichte KI-Modelle wurden auf der Hopper-Architektur trainiert, die 2022 auf den Markt kam.

Laut Nvidia bieten Chips auf Blackwell-Basis wie der GB200 eine deutliche Leistungssteigerung für KI-Unternehmen, nämlich 20 Petaflops im Vergleich zu 4 Petaflops beim H100. Diese Verarbeitungsleistung ermöglicht es KI-Unternehmen, größere und komplexere Modelle zu trainieren.

Die Blackwell-GPU ist groß und kombiniert zwei separat hergestellte Dies zu einem Chip. Es ist auch als kompletter Server namens GB200 NVLink 2 erhältlich, der 72 Blackwell-GPUs und andere Nvidia-Teile kombiniert, die zum Trainieren von KI-Modellen entwickelt wurden.

Amazon, Google, Microsoft und Oracle werden den Zugang zu GB200 über Cloud-Dienste verkaufen. Der GB200 kombiniert zwei B200 Blackwell-GPUs mit einer Grace-CPU. Nvidia sagte, Amazon Web Services (AWS) werde einen Servercluster mit 20.000 GB200-Chips bauen.

Das System kann ein Modell mit 27 Billionen Parametern einsetzen, das viel größer ist als die größten aktuellen Modelle wie GPT-4 (1,7 Billionen Parameter). Viele KI-Forscher glauben, dass größere Modelle mit mehr Parametern und Daten neue Möglichkeiten eröffnen können.

Nvidia hat keine Preise für das neue GB200 oder Systeme mit dem GB200 bekannt gegeben. Der auf Hopper basierende H100 von Nvidia kostet laut Analystenschätzungen zwischen 25.000 und 40.000 US-Dollar pro Einheit, und das gesamte System kostet bis zu 200.000 US-Dollar.

(Laut CNBC)

[Anzeige_2]

Quelle

![[Foto] Premierminister Pham Minh Chinh und der Premierminister des Königreichs Thailand, Paetongtarn Shinawatra, nehmen am Vietnam-Thailand Business Forum 2025 teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/16/1cdfce54d25c48a68ae6fb9204f2171a)

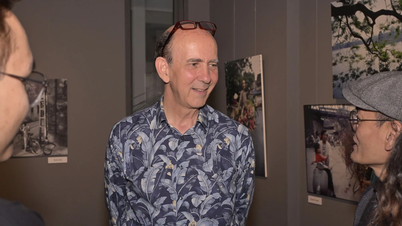

![[Foto] Viele Menschen und Touristen kommen zur Fotoausstellung "Heller Name der Person"](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/16/de2c8ad0828f4883bbdeb4f84a074a05)

![[Foto] Präsident Luong Cuong empfängt den Premierminister des Königreichs Thailand, Paetongtarn Shinawatra](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/16/52c73b27198a4e12bd6a903d1c218846)

Kommentar (0)