ในงานประชุมนักพัฒนาเมื่อวันที่ 18 มีนาคม Nvidia ได้ประกาศเปิดตัวผลิตภัณฑ์ใหม่ชุดหนึ่งเพื่อเสริมความแข็งแกร่งให้กับตำแหน่งของตนในตลาดปัญญาประดิษฐ์ (AI) ราคาหุ้นของผู้ผลิตชิปพุ่งขึ้น 54 เท่าและรายได้เพิ่มขึ้นมากกว่าสามเท่านับตั้งแต่ ChatGPT เริ่มต้นการแข่งขัน AI ระดับโลกในช่วงปลายปี 2022 GPU สำหรับเซิร์ฟเวอร์ระดับไฮเอนด์ของ Nvidia มีความสำคัญอย่างยิ่งต่อการฝึกอบรมและการใช้งานโมเดลภาษาขนาดใหญ่ บริษัทอย่าง Microsoft และ Meta ได้ทุ่มเงินหลายพันล้านดอลลาร์ในการซื้อชิป

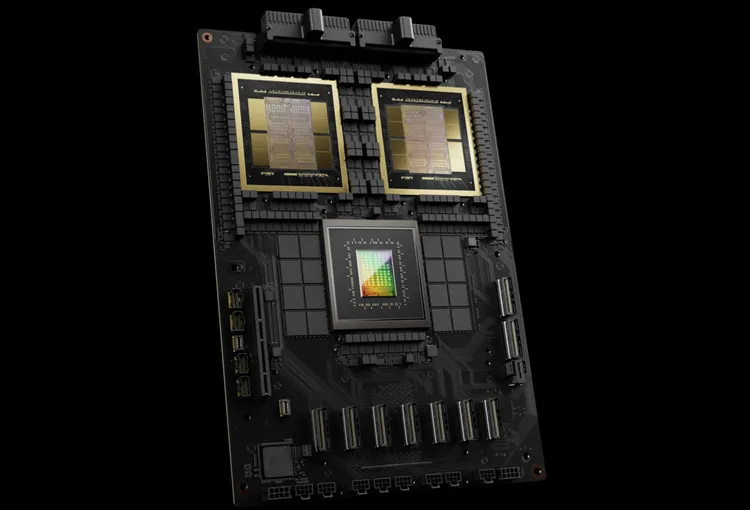

Nvidia ตั้งชื่อชิป AI รุ่นใหม่ว่า Blackwell ชิป Blackwell ตัวแรก – GB200 – จะวางจำหน่ายในช่วงปลายปีนี้ Nvidia นำเสนอชิปอันทรงพลังยิ่งขึ้นให้กับลูกค้าเพื่อกระตุ้นคำสั่งซื้อใหม่ ปัจจุบันลูกค้ายังคงดิ้นรนเพื่อให้ได้ชิป H100 Hopper

“Hopper นั้นยอดเยี่ยม แต่เราจำเป็นต้องมี GPU ที่ใหญ่กว่านี้” Jensen Huang ซีอีโอของ Nvidia กล่าวในงานสัมมนา

นอกจากชิป Blackwell แล้ว Nvidia ยังเปิดตัวซอฟต์แวร์ NIM ที่ช่วยให้การปรับใช้ AI ง่ายขึ้นอีกด้วย ตามที่เจ้าหน้าที่ Nvidia เปิดเผย บริษัทกำลังกลายเป็นผู้ให้บริการแพลตฟอร์มเช่นเดียวกับ Apple และ Microsoft แทนที่จะเป็นซัพพลายเออร์ชิป

“แบล็กเวลล์ไม่ใช่ชิป แต่เป็นชื่อของแพลตฟอร์ม” นายหวง กล่าว Manuvir Das รองประธานบริษัท Nvidia สัญญาว่าซอฟต์แวร์ NIM จะช่วยให้โปรแกรมเมอร์รันโปรแกรมบน GPU ของ Nvidia ไม่ว่าจะเก่าหรือใหม่ เพื่อให้เข้าถึงผู้คนได้มากขึ้น

แบล็กเวลล์ ผู้ “สืบทอด” ของฮอปเปอร์

ทุกๆ สองปี Nvidia จะอัปเดตสถาปัตยกรรม GPU เพื่อปลดล็อกประสิทธิภาพที่เพิ่มขึ้นใหม่ โมเดล AI หลายตัวที่เปิดตัวเมื่อปีที่แล้วได้รับการฝึกอบรมบนสถาปัตยกรรม Hopper ที่เกิดขึ้นในปี 2022

Nvidia กล่าวว่าชิปที่ใช้ Blackwell เช่น GB200 นั้นช่วยอัปเกรดประสิทธิภาพ AI ให้กับธุรกิจ AI ได้อย่างมีนัยสำคัญ โดยมีประสิทธิภาพถึง 20 petaflops เมื่อเทียบกับ 4 petaflops บน H100 พลังการประมวลผลนี้ช่วยให้ธุรกิจ AI สามารถฝึกอบรมโมเดลที่ใหญ่ขึ้นและซับซ้อนยิ่งขึ้น

GPU ของ Blackwell มีขนาดใหญ่และรวมชิปที่ผลิตแยกกันสองตัวเข้าไว้ในชิปตัวเดียว นอกจากนี้ ยังพร้อมใช้งานเป็นเซิร์ฟเวอร์แบบสมบูรณ์ที่เรียกว่า GB200 NVLink 2 ซึ่งประกอบด้วย GPU Blackwell จำนวน 72 ตัวและชิ้นส่วน Nvidia อื่นๆ ที่ออกแบบมาเพื่อฝึกโมเดล AI

Amazon, Google, Microsoft และ Oracle จะขายการเข้าถึง GB200 ผ่านทางบริการคลาวด์ GB200 รวม GPU B200 Blackwell สองตัวเข้ากับ CPU Grace Nvidia กล่าวว่า Amazon Web Services (AWS) จะสร้างคลัสเตอร์เซิร์ฟเวอร์โดยใช้ชิป GB200 จำนวน 20,000 ตัว

ระบบสามารถใช้โมเดลพารามิเตอร์ได้ถึง 27 ล้านล้านพารามิเตอร์ ซึ่งมากกว่าโมเดลที่ใหญ่ที่สุดในปัจจุบันอย่าง GPT-4 (1.7 ล้านล้านพารามิเตอร์) มาก นักวิจัย AI จำนวนมากเชื่อว่าโมเดลขนาดใหญ่ที่มีพารามิเตอร์และข้อมูลมากขึ้นสามารถปลดล็อกความสามารถใหม่ ๆ ได้

Nvidia ยังไม่ได้ประกาศราคาของ GB200 ใหม่หรือระบบที่รองรับ GB200 Nvidia H100 ซึ่งเป็นแบบ Hopper มีราคาอยู่ระหว่าง 25,000 ถึง 40,000 ดอลลาร์สหรัฐฯ ต่อหน่วย และทั้งระบบมีราคาสูงถึง 200,000 ดอลลาร์สหรัฐฯ ตามการประมาณการของนักวิเคราะห์

(ตามรายงานของซีเอ็นบีซี)

แหล่งที่มา

![[ภาพ] นายกรัฐมนตรี Pham Minh Chinh และนายกรัฐมนตรีแห่งราชอาณาจักรไทย แพทองธาร ชินวัตร เข้าร่วมงาน Vietnam-Thailand Business Forum 2025](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/16/1cdfce54d25c48a68ae6fb9204f2171a)

![[Photo] ประชาชนและนักท่องเที่ยวจำนวนมากมาชมนิทรรศการภาพถ่าย “ชื่อสดใสของบุคคล”](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/16/de2c8ad0828f4883bbdeb4f84a074a05)

![[ภาพ] ประธานาธิบดีเลือง เกวง ให้การต้อนรับ นายกรัฐมนตรีแห่งราชอาณาจักรไทย แพทองธาร ชินวัตร](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/16/52c73b27198a4e12bd6a903d1c218846)

การแสดงความคิดเห็น (0)