Giám đốc điều hành Truepic Jeffrey McGregor cho rằng, vụ việc trên chỉ mới là phần nổi của "tảng băng chìm". Sẽ có nhiều nội dung do AI tạo ra xuất hiện trên mạng xã hội và chúng ta chưa sẵn sàng cho điều đó, ông McGregor nói.

Theo CNN, Công ty Truepic muốn giải quyết vấn đề này bằng cách cung cấp công nghệ tuyên bố xác thực phương tiện tại thời điểm được tạo thông qua Truepic Lens. Ứng dụng thu thập dữ liệu sẽ cho người dùng biết ngày, giờ, địa điểm và thiết bị được sử dụng để tạo hình ảnh, đồng thời áp dụng chữ ký số để xác minh xem hình ảnh có phải là tự nhiên hoặc được AI tạo ra.

Bức ảnh giả mạo vụ nổ ở Lầu Năm Góc đã được lan truyền khắp Twitter

Truepic - công ty do Microsoft hậu thuẫn được thành lập vào năm 2015. Ông McGregor cho biết công ty đang nhận thấy sự quan tâm từ các tổ chức phi chính phủ đến các công ty truyền thông, ngay cả công ty bảo hiểm cũng cần tìm cách xác nhận yêu cầu bồi thường là hợp pháp.

McGregor cho biết khi mọi thứ đều có thể bị làm giả, khi trí tuệ nhân tạo đã đạt đến đỉnh điểm về chất lượng và khả năng tiếp cận, chúng ta không còn biết thực tế là gì khi online.

Các công ty công nghệ như Truepic đã làm việc để chống lại thông tin sai lệch trực tuyến trong nhiều năm. Nhưng sự gia tăng của một loạt công cụ AI mới có thể tạo ra hình ảnh và tác phẩm viết từ lệnh của người dùng đã làm tăng thêm tính cấp bách. Đầu năm nay, hình ảnh giả mạo về Giáo hoàng Francis trong chiếc áo phao Balenciaga và cựu Tổng thống Mỹ Donald Trump bị bắt được chia sẻ rộng rãi. Cả hai vụ việc đã khiến hàng triệu người hoang mang trước nguy hiểm tiềm tàng của AI.

Một số nhà lập pháp hiện kêu gọi các công ty công nghệ giải quyết vấn đề bằng cách dán nhãn nội dung do AI tạo ra. Phó chủ tịch Ủy ban châu Âu (EC) Vera Jourova cho biết các công ty bao gồm Google, Meta, Microsoft và TikTok đã tham gia Bộ quy tắc thực hành tự nguyện của Liên minh châu Âu (EU) về chống thông tin sai lệch.

Ngày càng có nhiều công ty khởi nghiệp và các "ông lớn" công nghệ, bao gồm một số công ty đang triển khai AI tạo sinh trong các sản phẩm của họ, đang cố gắng triển khai các tiêu chuẩn và giải pháp để giúp mọi người xác định xem hình ảnh hoặc video có được tạo bằng AI hay không.

Nhưng khi công nghệ AI phát triển nhanh hơn khả năng theo kịp của con người, thì vẫn chưa rõ liệu các giải pháp này có thể giải quyết triệt để vấn đề hay không. Ngay cả OpenAI, công ty đứng sau Dall-E và ChatGPT, đã thừa nhận rằng nỗ lực của chính họ trong việc giúp phát hiện tác phẩm viết do AI tạo ra là không hoàn hảo.

Các công ty phát triển giải pháp đang có hai cách tiếp cận để giải quyết vấn đề. Cách đầu tiên dựa vào việc phát triển các chương trình để xác định hình ảnh do AI tạo ra sau khi chúng được sản xuất và chia sẻ trực tuyến. Cách còn lại tập trung vào việc đánh dấu một hình ảnh là thật hoặc do AI tạo ra bằng một loại chữ ký số.

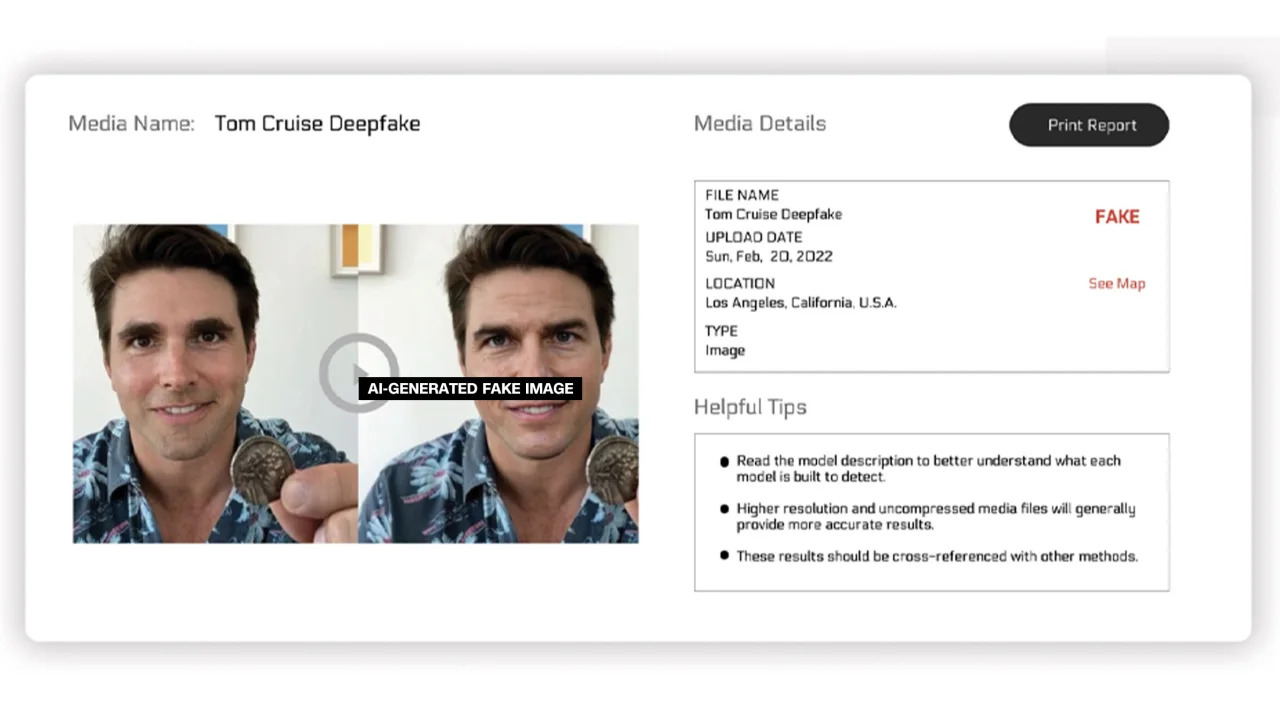

Reality Defender và Hive Moderation đang nghiên cứu về cách thứ nhất. Với nền tảng của họ, người dùng có thể tải lên các hình ảnh để quét và sau đó nhận được bảng phân tích hiển thị tỷ lệ phần trăm cho biết liệu đó là ảnh thật hay do AI tạo ra.

Reality Defender cho biết công ty sử dụng công nghệ lấy dấu vân tay nội dung tạo sinh và deepfake độc quyền để phát hiện video, âm thanh và hình ảnh do AI tạo ra. Trong một ví dụ do công ty cung cấp, Reality Defender đưa ra tấm hình Tom Cruise được tạo ra bằng deepfake, có độ "đáng ngờ" là 53% vì người trong ảnh có khuôn mặt biến dạng thường thấy ở những tấm ảnh bị chỉnh sửa.

Hình ảnh bị gắn nhãn do AI tạo ra

Các dịch vụ này cung cấp những phiên bản miễn phí và trả phí. Hive Moderation cho biết họ tính phí 1,5 USD cho mỗi 1.000 hình ảnh. Realty Defender nói rằng giá sản phẩm của họ có thể thay đổi dựa trên nhiều yếu tố khác nhau, trong trường hợp khách hàng đòi hỏi chuyên môn và sự hỗ trợ của công ty. CEO Reality Defender Ben Colman cho biết rủi ro đang tăng gấp đôi mỗi tháng vì bất kỳ ai cũng có thể tạo ra ảnh giả mạo bằng các công cụ AI.

Một số công ty khác đang nỗ lực tích hợp một loại nhãn dán vào hình ảnh để chứng nhận nó là thật hay do AI tạo ra. Cho đến nay, nỗ lực này phần lớn được thúc đẩy bởi Liên minh về tính xác thực và nguồn gốc nội dung (C2PA).

C2PA được thành lập vào năm 2021 để tạo ra một tiêu chuẩn kỹ thuật chứng nhận nguồn gốc và lịch sử của phương tiện kỹ thuật số, kết hợp giữa Sáng kiến xác thực nội dung (CAI) của Adobe và Project Origin, do Microsoft và BBC đứng đầu, với mục tiêu tập trung vào việc chống lại thông tin sai lệch trong tin tức số. Các công ty khác tham gia vào C2PA bao gồm Truepic, Intel và Sony.

Dựa trên các nguyên tắc của C2PA, CAI sẽ đưa ra các công cụ mã nguồn mở cho các công ty tạo thông tin đăng nhập nội dung hoặc siêu dữ liệu chứa thông tin về hình ảnh. Theo trang web CAI, điều này cho phép người sáng tạo chia sẻ minh bạch các chi tiết về cách họ tạo ra một hình ảnh. Bằng cách này, người dùng cuối có thể truy cập bối cảnh xung quanh ai, cái gì và cách hình ảnh được thay đổi - sau đó tự họ đánh giá mức độ xác thực của hình ảnh đó.

Nhiều công ty đã tích hợp tiêu chuẩn C2PA và các công cụ CAI vào ứng dụng của họ. Firefly của Adobe - công cụ tạo hình ảnh AI mới được thêm vào Photoshop, tuân theo tiêu chuẩn C2PA thông qua tính năng Content Credentials (tạm dịch: thông tin xác thực nội dung). Microsoft cũng thông báo rằng những hình ảnh, video được tạo bởi Bing Image Creator và Microsoft Designer sẽ mang chữ ký được mã hóa trong những tháng tới.

Vào tháng 5, Google đã công bố tính năng "About This Image", cho phép người dùng xem thời gian hình ảnh xuất hiện lần đầu trên Google và những nơi có thể nhìn thấy nó. "Gã khổng lồ" tìm kiếm cũng thông báo rằng mọi hình ảnh do AI tạo ra của Google sẽ mang một đánh dấu trong tệp gốc để “bổ sung ngữ cảnh” nếu hình ảnh được tìm thấy trên một trang web hoặc nền tảng khác.

Trong khi các công ty công nghệ đang cố gắng giải quyết những lo ngại về hình ảnh do AI tạo ra và tính toàn vẹn của phương tiện kỹ thuật số, các chuyên gia trong lĩnh vực này nhấn mạnh các doanh nghiệp sẽ cần phải hợp tác với nhau và với chính phủ để giải quyết vấn đề. Song, những công ty công nghệ vẫn đang chạy đua phát triển AI bất chấp rủi ro.

Source link

![[Ảnh] Dòng người trẻ nối dài trước Báo Nhân Dân, ôn lại ký ức ngày thống nhất đất nước](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/4709cea2becb4f13aaa0b2abb476bcea)

![[Ảnh] Phụ san đặc biệt của Báo Nhân Dân lan toả tới bạn đọc toàn quốc](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/0d87e85f00bc48c1b2172e568c679017)

![[Ảnh] Lễ ký kết hợp tác, trao đổi văn kiện giữa Việt Nam và Nhật Bản](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/e069929395524fa081768b99bac43467)

![[Ảnh] Người dân đội mưa xếp hàng, háo hức nhận phụ san đặc biệt của Báo Nhân Dân](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/ce2015509f6c468d9d38a86096987f23)

![[Ảnh] Bạn đọc ở Đồng Nai hào hứng với phụ san đặc biệt của Báo Nhân Dân](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/82cdcb4471c7488aae5dbc55eb5e9224)

Bình luận (0)